早在今年九月,我就写过一篇关于人工智能应用中的模拟计算的博客。那些机构正在努力以协同处理的形式使用模拟计算硬件和系统,以帮助解决数字电子技术在开发人工智能技术中存在的一些问题。我没有谈到的是模拟计算这一用例的进展程度,或者其他潜在的应用以及在复兴模拟计算上的努力。

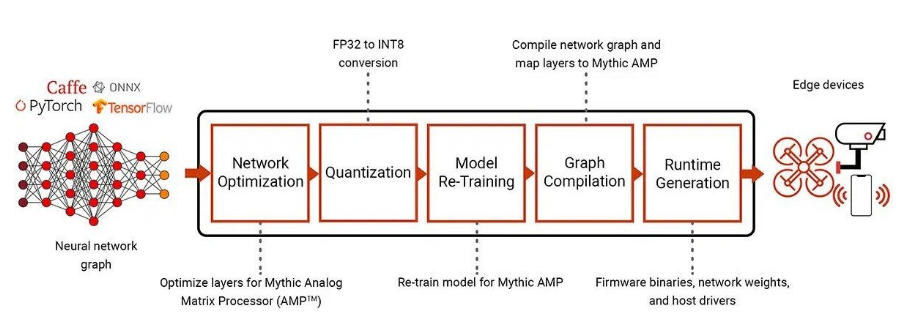

截至目前,IBM已将重点放在模拟AI上,而Mythic AI则在寻求更多资金,以继续开发其模拟人工智能技术,并在可能的情况下推出商业解决方案。尽管Mythic AI确实有一款产品正在初步交付给某些特定客户,但Mythic AI的解决方案仅专用于边缘AI推理。该解决方案声称比目前的边缘人工智能推理数字解决方案更省电、更快速、更紧凑。

此外,Mythic的解决方案还声称可以进行一些额外的计算,尽管这些计算纯粹是用于神经网络操作。这些解决方案依靠存算一体(或存内计算)的模拟处理技术的优势,旨在提供比GPU、CPU和FPGA等数字计算设备更高效的矩阵向量乘法。

图1 利用模拟计算引擎对人工智能模型进行优化、量化和再训练。来源:Mythic

尽管如此,这些解决方案仍然需要前端和后端的数字电路,以支持模拟人工智能芯片使用可接受的输入数据,并解决输出模拟处理的一些固有误差问题。这些解决方案单纯的针对边缘人工智能推理用例,似乎无法解决部署大规模人工智能的更大挑战。

模拟计算和内存的应用是有意义的,因为它解决了执行类似任务所需的数字系统在能效、计算速度和复杂性方面的普遍挑战。

新兴的模拟人工智能系统

除了边缘人工智能推理之外,模拟计算还有许多潜在应用,但几十年来这些应用在很大程度上被忽视了。少数研究人员正在公开致力于开发模拟计算系统,其中包括微软的一个部门最近的努力。

微软的模拟迭代机(AIM)是一种光学计算设备,旨在快速解决优化问题。具体来说,AIM的目标是高效解决广泛的二次无约束混合优化(QUMO)问题,并原生支持连续变量和二元变量的全对全连接。

在微软研究团队最新发表的论文中,研究人员声称他们的技术已经能够在室温下完全在模拟领域内解决金融交易结算问题,其精度比量子硬件更高。这是在AIM中通过使用存算一体和多个变量的空分复用表示以及梯度下降法等复杂算法来实现的。

哥伦比亚大学和麻省理工学院的研究人员也一直致力于开发模拟计算技术。这些研究人员正在致力于开发一种更通用的模拟计算机,利用数字接口使模拟计算机更方便用户使用。该研究小组开发的单片模拟计算机被设计为像FPGA一样可编程。

初代芯片和第二代芯片包括用于积分、矩阵乘法、插值、滤波和函数发生器的模拟电路,这些电路通过模拟硬件可以更有效地开发。此外,这种模拟计算芯片对函数发生器采用了一种新颖的连续时间数字方法,该方法使用无时钟二进制信号,这些信号可以根据响应变化而不是以固定时钟间隔变化。

要实现这一点,需要专门的模数转换器和数模转换器(ADC/DAC)以及可以处理连续时间数字信号的数字存储器。从根本上说,该系统的工作原理是将无时钟二进制信号从模拟信号转换为数字信号,引用查找表中的值并将存储在内存中的值转换回模拟信号。这有利于模拟输入/模拟输出函数的生成。

这样做的主要好处是,该系统可以高效、快速地以相对较高的精度求解相当复杂的微分方程。尽管它的精度不如当今的数字硬件和算法,但对于某些情况来说,这种精度水平已经足够了。此外,这种模拟计算解决方案的开发时间和运行能耗仅为数字计算机的零头。

这样,模拟/数字协处理器就可以使用模拟计算机的结果来为数字计算机进一步处理提供一个起始解决方案。与通过纯数字迭代处理达到的起始相比,它的效率要高得多,资源消耗要少得多。

模拟/数字混合人工智能

在输入为近似值的情况下,这也可能是一种单步解决方案,例如机器学习(ML)、计算机视觉、生物信息学、机器控制、分子生物学和大数据集挖掘。然而,虽然利用模拟芯片可以实现更高水平的精度,但当前的方法需要更大的芯片面积(这种方法的模拟计算与芯片面积成正比)以及混合方法中更复杂的模拟处理技术。

由于这项工作大部分在20世纪70年代初就已停滞不前,因此在支持模拟计算技术的研究方面存在着巨大的差距。例如,有人建议采用晶圆级技术和全3D集成电路技术来制造高性能模拟计算芯片。然而,这些工艺极其昂贵,尽管它们可能取得超出当前超级计算机甚至量子计算机能力的结果。

举例说明:Tsividis建议在300mm晶圆上构建具有10万个积分器的模拟计算机,这样就可以创建一个包含10万个耦合一阶非线性动态方程的系统,或者一个更小的高阶方程组来进行模拟。通过这种方法,处理一个方程只需要几毫秒,并且只需要几十瓦的功率。

人们还在努力进一步改进这种模拟/数字混合计算方法。尽管关于该方法的信息不多,但Anabrid Gmbh公司正在讨论一种模拟计算芯片,以及它与以往的努力有何不同。

这家总部位于德国柏林的人工智能新贵正在销售一款开源模拟计算平台——The Analog Thing(THAT),这是一个硬件电位器和模拟硬件的组合,可用于简单计算和教育目的(图3)。它可以通过引线手动重新配置,并且似乎更像是一种模拟计算的教育工具。

这些早期产品和研究项目尚未产生可用于主流市场的集成模拟/数字混合或协处理器技术。然而,在模拟/数字混合技术因全数字计算而被抛弃近50年后,一些研究团队正在致力于开发模拟辅助或真正的协处理器技术。

这些团体押注于模拟计算的未来。即使目前投向人工智能的资金和资源的一小部分可以转用于模拟计算机的开发,模拟计算也有可能成为现实。

-

IBM

+关注

关注

3文章

1782浏览量

75062 -

神经网络

+关注

关注

42文章

4789浏览量

101581 -

人工智能

+关注

关注

1800文章

48076浏览量

242110

发布评论请先 登录

相关推荐

模拟人工智能能否通过混合数字计算东山再起?

模拟人工智能能否通过混合数字计算东山再起?

评论