共读好书

张志伟 田果 王世权

摘要:

AI芯片是被专门设计用于加速人工智能计算任务的集成电路。在过去几十年里,AI芯片经历了持续的演进和突破,促进着人工智能领域的发展。文章探讨了AI芯片的发展史、主流技术和应用场景,以及面临的挑战和问题。进而提出采用Chiplet技术,将不同的功能模块独立集成为独立的Chiplet,并融合在一个AI芯片上,从而实现更高的计算能力。该设计不仅允许独立开发和升级各个模块,还可在封装过程中将它们巧妙组合起来,使得AI芯片能够随着人工智能技术的不断优化而持续发展。

1 AI芯片发展的历史与现状

AI(人工智能)芯片是被专门设计用于加速人工智能计算任务的集成电路。在过去几十年里,AI芯片经历了持续的演进和突破,为人工智能领域发展作出了巨大贡献。

1.1 AI芯片演进与重大突破

AI芯片的历史可以追溯到20世纪80年代初。最早的AI计算任务是采用通用微处理器进行人工智能计算而完成的,但由于计算需求与通用处理器性能之间不匹配,计算效率并不高。随着人工智能领域的迅速发展,社会对高效计算的需求越来越迫切,AI芯片研究逐渐受到重视。在20世纪90年代,图形处理单元(GPU)成为AI计算的主要加速器。GPU在图形渲染方面表现出色,但其架构对于一些特定的AI计算任务并不高效。然而,GPU的并行计算能力为AI芯片发展奠定了基础。随着人工智能的兴起,20世纪末和21世纪初一些专用AI加速硬件出现了,如FPGA(现场可编程门阵列)和ASIC(专用集成电路)。这些芯片采用定制化的架构,能够更好地满足AI计算的需求,但设计和生产成本较高,限制了其广泛应用。

2010年,深度学习兴起推动了AI芯片技术重大突破。GPU在深度学习中的应用取得了巨大成功,但为了更好地适应深度学习模型的特点,研究人员开始探索新的AI芯片架构。ASIC出现进一步提高了AI计算的性能和能效,诸如Google的TPU(张量处理单元)和NVIDIA的Tensor Cores就是这一时期的代表。

1.2 当前的主流AI芯片技术与其应用场景

目前,AI芯片技术呈现多样化的发展趋势,主要包括以下几种类型。

(1)图形处理单元。GPU因其并行计算能力成为早期AI计算的主流加速器。现代GPU在深度学习训练和推理方面表现出色,广泛应用于计算机视觉、自然语言处理等领域。

(2)张量处理单元。TPU是Google推出的专用AI加速器,特别优化了张量计算。TPU在大规模深度学习模型训练中表现出色,广泛应用于云端AI服务。

(3)神经处理单元(NPU)。NPU是一类专门用于神经网络计算的AI芯片,广泛应用于智能手机和移动设备中,用于加速图像识别、语音识别等任务。

(4)量子芯片。量子芯片是一种革命性的AI芯片,利用量子位来进行计算。尽管目前处于早期阶段,但量子芯片在解决某些特定问题上显示出巨大潜力,如优化问题和密码学。

(5)脑神经芯片。脑神经芯片研发受到人脑神经元结构的启发,试图模拟神经元之间的连接和信息传递。这种芯片在模拟类脑计算和智能机器方面具有潜在应用。

从广义上讲,能运行AI算法的芯片都叫AI芯片。CPU、GPU、FPGA、NPU、ASIC都能执行AI算法,但执行效率有巨大的差异。CPU可以快速执行复杂的数学计算,但同时执行多项任务时,CPU性能开始下降,目前行业内基本确认CPU不适用于AI计算。CPU+xPU的异构方案成为大算力场景标配,GPU为应用最广泛的AI芯片。目前业内广泛认同的AI芯片类型包括GPU、FPGA、NPU等。当前主流AI芯片广泛应用于各个领域,包括但不限于自动驾驶、智能语音助手、医疗图像识别、金融风控等。随着技术的不断进步,AI芯片的应用场景将进一步拓展。

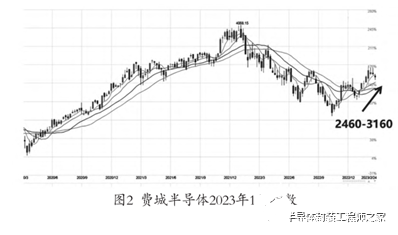

1.3 ChatGPT引燃AI及半导体产业及资本市场热情

瑞银集团(UBS)发布的研究报告显示,ChatGPT在2023年1月份的月活跃用户数已达1亿,对比各大热门平台月活跃用户数破亿所需时长,ChatGPT只花了2个月的时间(见图1),成为史上用户数增长最快的消费者应用。在资本市场上,知情人士透露,聊天机器人ChatGPT背后的研究实验室OpenAI正谈判以收购要约的形式出售现有股份,交易对该公司的估值达到290亿美元左右,使其在没有收入的情况下成为账面上最值钱的美国初创公司之一。国内外科技巨头都非常重视ChatGPT引发的科技浪潮,积极布局生成式AI。与此同时,全球半导体资本市场也迎来大幅上涨,费城半导体指数自2023年1月至今已上涨约30%(见图2)。

1.4 短期内GPU增量与市场规模

参考OpenAI算法,假设每日1亿用户,每人进行10条交互,每个问题的回答长度为50词,算力利用率30%,则单个大语言模型(LLM)的日常需求有望带来2.13万片A100芯片的增量,对应市场规模2.13亿美元。假设有5家大企业推出此类LLM,则总增量为10.7万片

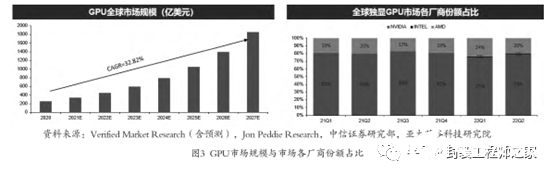

A100芯片,对应市场规模10.7亿美元。短期服务器增量与市场规模:单个服务器包含8个GPU,因此单个LLM带来2 669台服务器需求,对应市场规模3.39亿美元,5家大企业共需要13 345台,对应市场规模20亿美元。长期市场空间:参考谷歌,若每日访问30亿次,需要106.74万片A100芯片,对应13.3万台服务器DGX A100,带来市场空间200亿美元。根据Verified Market Research数据,2020年,全球GPU市场规模为254.1亿美元(约1717.2亿人民币)。随着需求的不断增长,预计到2027年全球将达到1 853亿美元,年复合增长率为32.82%,如图3(左)。2020年中国大陆的独立GPU市场规模为47.39亿美元,GPU市场厂商NVIDIA、Intel、AMD份额占比分别为79%、1%、20%,如图3(右),预计2027年将超过345.57亿美元。

1.5 AI芯片发展所面临的挑战与问题

虽然AI芯片在过去几十年取得了显著的进展,但在其发展过程中仍然面临一些挑战与问题。

(1)复杂的算法与模型。随着深度学习等复杂算法的出现,其对AI芯片计算能力和存储要求提出了更高的挑战。一些大规模的神经网络模型需要海量的计算资源才能高效运行,因此,如何在芯片设计中实现高度并行和高效的计算,是亟待解决的问题。

(2)能耗和散热问题。随着AI芯片计算规模的增加,能耗和散热问题变得日益严峻。高功耗会导致芯片发热过多,进而影响计算性能和稳定性。因此,如何在保证性能的同时降低能耗,并解决散热问题,是AI芯片发展中需要攻克的难题。

(3)可编程性与定制化。通用处理器如GPU虽然在AI计算中有一定的应用,但其可编程性相对较弱,不能完全适应各类AI任务的需求。与此同时,定制化AI芯片虽然能提供更高效的计算性能,但其开发和生产成本较高。如何在可编程性与定制化之间找到平衡,是AI芯片发展的一个重要课题。

(4)安全与隐私问题。AI芯片在智能设备和云端服务中广泛应用,但这也带来了安全和隐私方面的问题。一些AI算法可能会面临对抗攻击,导致模型输出错误。同时,个人隐私保护也成为AI芯片应用的一大挑战。

(5)国际竞争与政策制约。AI芯片领域的竞争日益激烈,许多国家都在加大投入进行技术研发。在国际竞争中,如何保持技术领先优势,以及应对不同国家对AI芯片技术的政策限制,都是需要面对的问题。

2 先进封装Chiplet技术概述

2.1Chiplet技术的定义与特性

Chiplet是一种先进封装技术,它将芯片功能分割成多个独立的模块,称为Chiplet(小芯片)。每个Chiplet都具有特定的功能,例如处理器核心、存储器控制器或其他外围设备。这些独立的Chiplet可以单独设计、测试和生产,并在封装过程中组合在一起,形成一个完整的芯片。这种模块化的设计使得芯片开发更具灵活性和可扩展性,同时也提高了生产效率。

2.2Chiplet的主要应用与发展趋势

Chiplet技术在现代半导体行业中具有广泛的应用和良好的发展趋势。其中一个主要应用领域是高性能计算领域,例如数据中心和超级计算机。通过组合多个特定功能的Chiplet,可以实现更高的计算能力和效能。此外,将芯片分割成多个模块还可以提高整体芯片的可靠性和可维护性。另一个重要的应用是在物联网(IoT)设备和移动设备中。这些设备通常需要集成多种功能,如无线通信、传感器、处理器和存储器。通过使用Chiplet技术,可以独立开发和升级不同功能的模块,从而提供更大的灵活性和可扩展性。

2.3 与传统芯片封装的比较

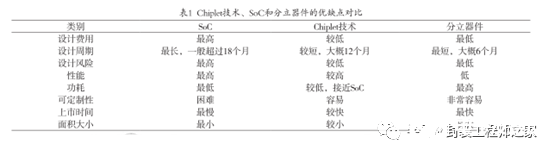

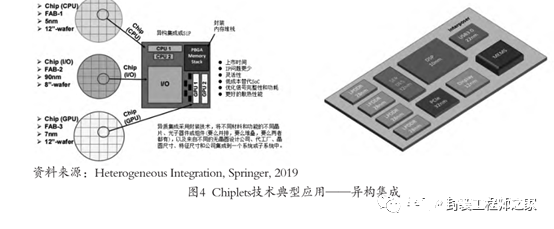

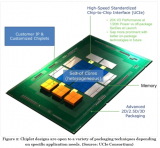

相比传统的单一芯片封装方式,Chiplet技术具有一些显著的优势。首先,可以实现更高的整体芯片集成度,因为不同的模块可以在较小的面积上组合。其次,芯片的开发周期可以更短(见表1),因为各个功能模块可以同步开发和测试,而不需要等待整个芯片的开发完成。此外,由于不同模块可以由不同的制造商提供,因此可以实现更多元化的供应链(见图4),从而提高生产效率并降低成本。使用Chiplet技术将不同设计公司中的不同Wafer 制程的芯片集成为一个系统或子系统中。

3 AI芯片与Chiplet结合

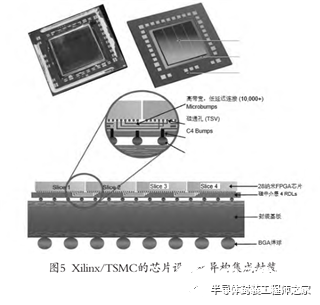

3.1 解决AI芯片发展问题的Chiplet方案随着人工智能应用的不断发展,AI芯片面临着一些挑战,例如计算能力提升、能源效率提高和更高的集成度要求。在这些挑战中,Chiplet技术可以提供解决方案。例如,TSMC工艺和Xilinx的新一代Virtex系列FPGA产品(见图5),基于硅基板进行集成。通过将不同的功能模块作为独立的Chiplet集成在一个AI芯片上,可以实现更高的计算能力。例如,将处理器核心、神经网络加速器和存储器控制器作为独立的模块,可以独立开发和升级,同时在封装过程中组合在一起,形成一个高性能的AI芯片。

3.2 AI芯片与Chiplet结合的实例分析

GPU性能提升与功能丰富逐步满足AI运算需要。2010年NVIDIA提出的Fermi架构是首个完整的GPU计算架构,其中提出的许多新概念沿用至今。Kepler架构在硬件上拥有了双精度计算单元(FP64),并提出GPU Direct技术,绕过CPU/System Memory,与其他GPU直接进行数据交互。Pascal架构应用了第一代NVLink。Volta架构开始应用Tensor Core,对AI计算加速具有重要意义。简要回顾NVIDIA GPU硬件变革历程,工艺、计算核心数增加等基础特性的升级持续推动性能提升,同时每一代架构所包含的功能特性也在不断丰富,逐渐更好地适配AI运算的需要。

目前已经有一些实际的AI芯片与Chiplet技术结合的实例。AMD公司的与Chiplet技术结合的实例是AMD在其Zen 2架构的Ryzen 3000系列CPU中采用了Chiplet设计 [6] 。该设计允许AMD将更多的CPU核心集成到单个CPU中。同样,AMD也计划将Chiplet技术应用于GPU设计中,以解决GPU制造中遇到的一些挑战,比如增加芯片尺寸导致产量下降和成本增加。在这个GPU的Chiplet设计中,AMD使用了高带宽互连(HBX)来促进不同Chiplet之间的通信,该互连类似于Zen 3 CPU中使用的互连方式。这种设计通过一个被称为HBX的交叉连接来解决在GPU计算工作负载中并行性难以跨多个Chiplet传输的问题。而这种设计使得CPU与GPU交互时,看起来就像是与一个大型的单一GPU通信,而不是与许多小型GPU通过控制器通信。

3.3 AI芯片与Chiplet结合展望

AI芯片与Chiplet技术结合在未来将继续发展和扩展。随着人工智能应用的不断演进,对于更高的计算能力、更低的功耗和更高的集成度的需求将持续增加。因此,进一步改进和发展Chiplet技术,并与AI芯片相结合,将是未来的发展方向。此外,随着物联网设备的普及,对于更灵活、可扩展的芯片解决方案的需求也将增加。因此,将AI芯片与各种不同的Chiplet结合,以满足不同物联网设备的需求,将成为未来的一个重要发展方向。

4 结论

Chiplet技术是一种模块化的封装方法,其优势在于提供了更高的灵活性、可扩展性和生产效率。AI芯片面临着一些挑战,如计算能力提升、能源效率提高和更高的集成度要求。

为了更好地发展AI芯片与先进封装Chiplet技术结合,提出以下建议。

(1)加强合作。鼓励芯片制造商、封装技术供应商和研究机构之间合作,促进技术共享和交流,以加速AI芯片与Chiplet技术结合发展。

(2)技术创新。持续投入研发,不断创新先进封装Chiplet技术,以满足AI芯片不断提高的性能要求。

(3)标准化。制定相关的技术标准,以确保不同厂商生产的芯片和Chiplet之间的互换性,推动整个行业健康发展。

随着人工智能应用的不断扩展和技术的进步,AI芯片与先进封装Chiplet技术结合将会得到更广泛的应用。这种结合将不仅仅用于高性能计算领域,也将广泛应用于物联网设备、智能手机和其他各种人工智能应用中,为人们的生活和工作带来更多的便利。

审核编辑 黄宇

-

芯片

+关注

关注

456文章

51157浏览量

426818 -

封装

+关注

关注

127文章

7990浏览量

143353 -

AI

+关注

关注

87文章

31493浏览量

270162 -

人工智能

+关注

关注

1796文章

47643浏览量

240047 -

chiplet

+关注

关注

6文章

434浏览量

12623

发布评论请先 登录

相关推荐

半导体芯片先进封装——CHIPLET

AI应用致复杂SoC需求暴涨,2.5D/Chiplet等先进封装技术的机遇和挑战

北极雄芯开发的首款基于Chiplet异构集成的智能处理芯片“启明930”

光芯片走向Chiplet,颠覆先进封装

何谓先进封装/Chiplet?先进封装/Chiplet的意义

先进封装技术是Chiplet的关键?

AI网络物理层底座: 大算力芯片先进封装技术

先进封装 Chiplet 技术与 AI 芯片发展

先进封装 Chiplet 技术与 AI 芯片发展

评论