简介

本文介绍了一个名为Alpha-CLIP的框架,它在原始的接受RGB三通道输入的CLIP模型的上额外增加了一个alpha通道。在千万量级的RGBA-region的图像文本对上进行训练后,Alpha-CLIP可以在保证CLIP原始感知能力的前提下,关注到任意指定区域。通过替换原始CLIP的应用场景,Alpha-CLIP在图像识别、视觉-语言大模型、2D乃至3D生成领域都展现出强大作用。

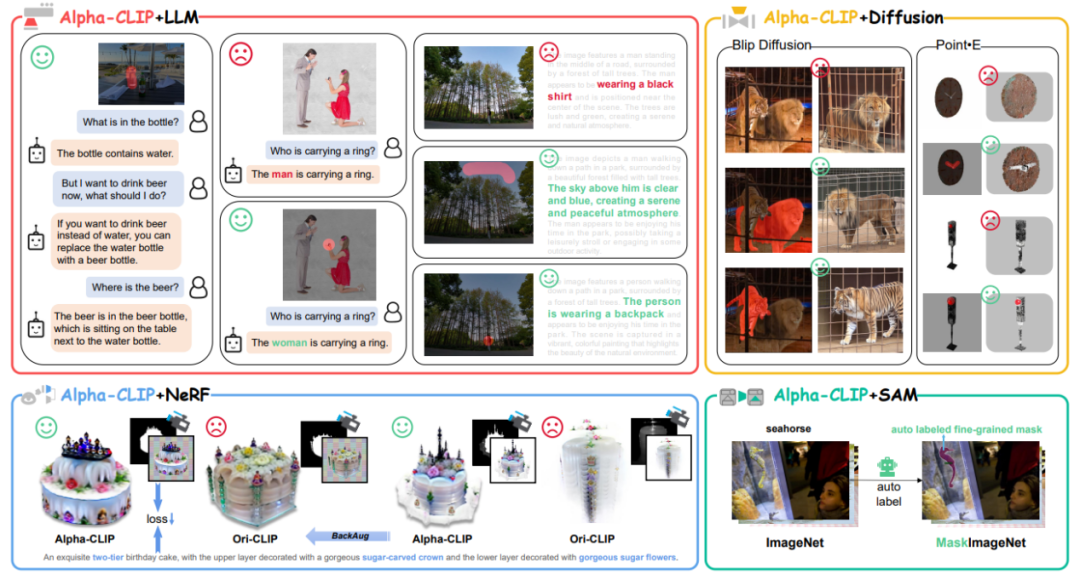

图1 Alpha-CLIP使用场景总览

CLIP作为目前最流行的视觉基座模型被广泛使用。它的应用场景包括但不限于1.与LLM大语言模型结合成为视觉多模态大模型。2.作为图像生成(Stable Diffusion)、点云生成(Point-E)的condition model, 实现image-to-3D。3.用于指导NeRF的优化方向从而实现text-to-3D。4.本身用于开放类别的识别和检测。

然而CLIP必须以整张图片作为输入并进行特征提取,无法关注到指定的任意区域。然而,自然的2D图片中往往包含不同的物体,part和thing。如果能由用户或检测模型指定需要关注的区域,在图像编码的过程就确定需要关注的对象,将会提升CLIP模型的可控制性和区域检测能力。

为此,上海人工智能实验室联合上海交通大学、复旦大学、香港中文大学、澳门大学的学者们提出了Alpha-CLIP模型,在原始CLIP模型的RGB三个通道的基础上额外引入了第四个alpha通道来决定需要关注的区域。通过构造千万量级的【RGBA四通道图片-文本对】对Alpha-CLIP进行训练,Alpha-CLIP不仅在ImageNet上保持了原始的全图检测能力,还能对用户指定的任意区域进行highlight关注。下面分别介绍Alpha-CLIP的应用场景。

* 论文链接:https://arxiv.org/abs/2312.03818 * 项目主页:https://aleafy.github.io/alpha-clip * 代码链接:https://github.com/SunzeY/AlphaCLIP1. 图像分类

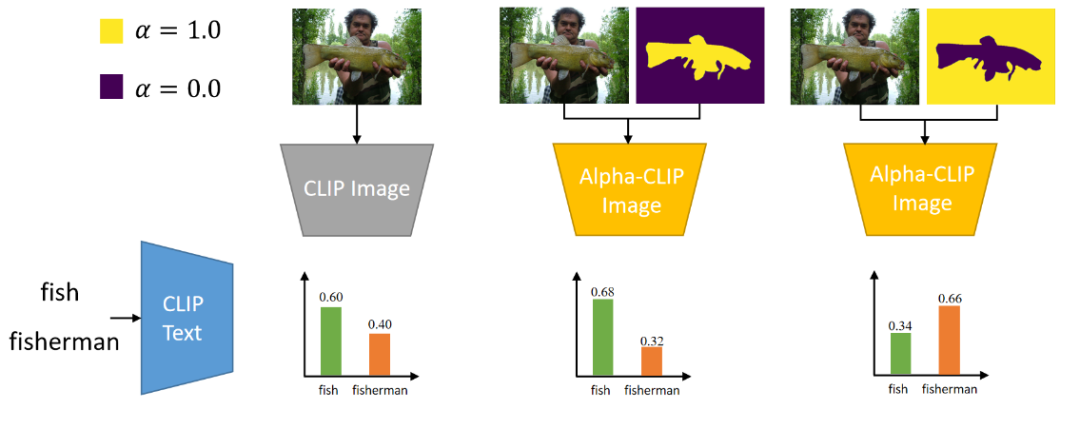

如图所示,对于ImagNet的一张图片,我们可以通过alpha-map控制CLIP去关注鱼或渔夫。

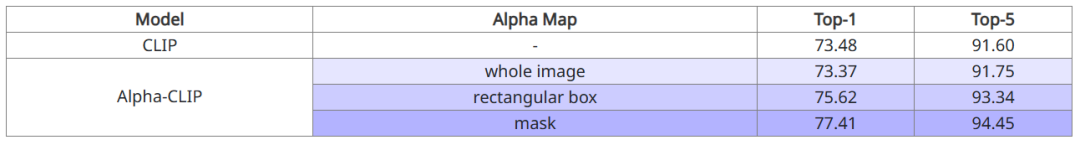

以ImageNet的Zero-Shot Classification作为评价指标,我们验证了在对全图进行识别时,Alpha-CLIP可以保持原本CLIP的分类准确率。进一步地,在给出了需要关注区域的长方形box或者mask时,Alpha-CLIP可以进一步提升分类准确率。

2. 与LLM大语言模型的结合

将主流的LLaVA-1.5中的CLIP基座模型替换为Alpha-CLIP,用户可以通过简单地用画笔标记处需要关注的区域,从而进行指定区域的对话交互。

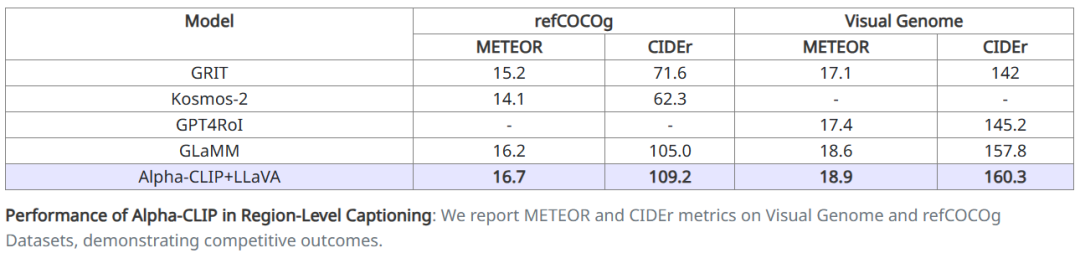

在定量实验方面,我们通过LLaVA测试了MLLM的region caption能力。通过在RefCOCO和VG上分别进行finetune,取得了SOTA的region caption分数。

3. 与Stable Diffusion的结合

Stable-Diffusion是目前主流的2D图片生成模型,其Image Variation版本可以实现“图生图”,其中图片的编码器也是CLIP模型。通过将该模型替换为Alpha-CLIP,可以实现更复杂图片中指定物体的生成(同时较好地保留背景)。如上图所示,使用原始的CLIP会生成同时具有狮子和老虎特征的“狮虎兽”,而Alpha-CLIP能够很好地区分两个物体,从而指导Stable Diffusion模型生成更专一的图片。更多结果见下图

4. 与Point-E的结合

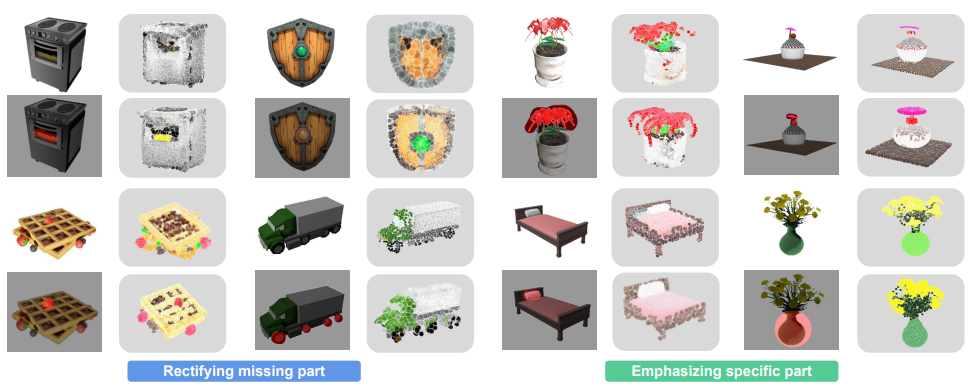

Point-E是Open-AI开源的一个支持Image-to-3D和text-to-3D的点云diffusion模型,通过将它的Image编码器从原始的CLIP替换为Alpha-CLIP。可以支持用户对任意区域进行关注,从而恢复丢失的“表针”和“盾牌的十字架”。更多结果见下图

5. Attention Map可视化

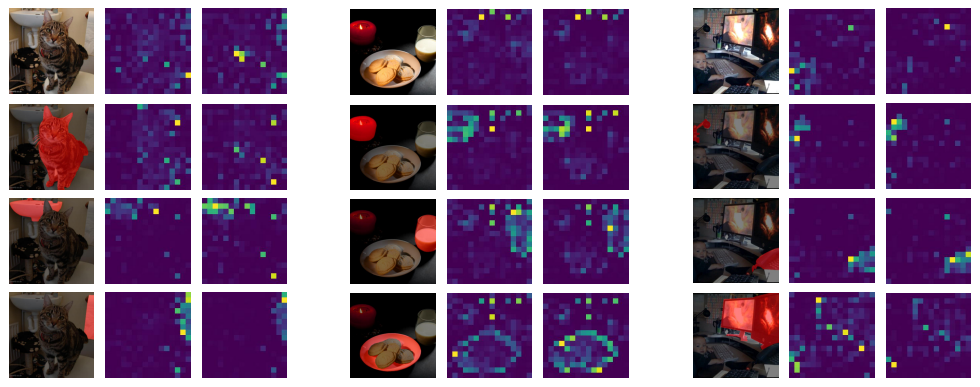

本工作对Alpha-CLIP的注意力进行可视化,以检查Alpha-CLIP是否更加关注用户定义alpha-map。通过检查视觉编码器中最后一个Transformer块中[CLS] token的注意力图。可视化采用了具有16个注意头的ViT-L/14模型。为了进行公正比较,使用第5和第16个注意头的注意力图进行可视化,因为我们发现在这16个头中,这两个特征图最为明显。结果如下图所示。这种可视化验证了Alpha-CLIP更加关注要聚焦的区域,更重要的是,它在保留原始CLIP特征位置的二维位置信息时没有造成损害。

结论

本文介绍的这项工作提出了Alpha-CLIP模型,该模型引入了一个额外的alpha通道,用于指定感兴趣的区域。通过对数百万个RGBA区域-文本对进行训练,Alpha-CLIP不仅表现出卓越的区域关注能力,而且确保其输出空间与原始的CLIP模型保持一致。这种一致性使得Alpha-CLIP在CLIP的各种下游应用中能够轻松替代,无缝衔接。我们证明了当提供特定关注的区域时,Alpha-CLIP展现出了更强大的Zero-Shot识别能力,并验证了它在许多下游任务中的有用性。CLIP的应用远远超出了本文的范围。我们希望在前景区域或mask较容易获得时,Alpha-CLIP将能够在更多场景中得到应用。

虽然Alpha-CLIP在需要关注区域的各种场景中表现出有效的性能,但目前的结构和训练过程限制了其专注于多个对象或建模不同对象之间关系的能力。此外,当前的训练方法限制了alpha通道在中间值之外的泛化(只能接受0,1两个值)。因此,用户无法指定注意力的幅度。另一个限制同时存在于我们的Alpha-CLIP和原始CLIP中,即纯Transformer结构的编码器分辨率较低,这阻碍了Alpha-CLIP识别小物体并进行关注。我们计划在未来的工作中解决这些限制并扩展CLIP的输入分辨率。我们相信这些未来的方向是增强Alpha-CLIP能力并在各种下游任务中扩展其实用性的途径。

-

人工智能

+关注

关注

1796文章

47643浏览量

240203 -

Clip

+关注

关注

0文章

31浏览量

6701 -

大模型

+关注

关注

2文章

2543浏览量

3136

原文标题:更强!Alpha-CLIP:让CLIP关注你想要的任何地方!

文章出处:【微信号:CVer,微信公众号:CVer】欢迎添加关注!文章转载请注明出处。

发布评论请先 登录

相关推荐

微源LP7820B充电仓芯片在漫步者花再Zero Clip耳机的应用

漫步者花再Zero Clip开放式耳机拆解报告

新品 | 可拼接灯板矩阵 Puzzle Unit &amp; 创意固定套件CLIP-A/CLIP-B

使用TPA6112A后,蓝牙1KHz信号有失真现象,怎么解决?

设计的tas5613a板子BTL模式正常工作1,2分钟后clip告警,输出端电压为0是哪里的问题?怎么解决?

TPA3251不小心把GVDD_CD脚和CLIP管脚碰到一起,然后CILP和FAULT指示灯一直亮,管脚一直输出低电平,什么问题?

为什么我的TPA3251上电后,FAULT和CLIP_OTW输出电压是1.4V左右?

请问TPA3244,RESET FAULT CLIP_OTW怎么跟MCU连接?

TPA3220功放的OTW_CLIP管脚会异常拉低,为什么?

TAS5630电路PBTL接法,CLIP灯无法灭是怎么回事?

如何停止引导加载程序输出消息?

爱芯元智推出边端侧智能SoCAX650N,让视觉更智能

更强!Alpha-CLIP:让CLIP关注你想要的任何地方!

更强!Alpha-CLIP:让CLIP关注你想要的任何地方!

评论