今日,微软发布官方声明,称其开发的 Phi-2 2.7B 模型在多项指标上超过了 Google 的 Gemini Nano-2 3.2B 模型。

Microsoft研发的Phi-2 2.7B模型

早前在 IT之家的报道中,微软在Ignite 2023大会上首次披露了容纳27亿参数的Phi-2,在性能上较以往型号有明显进步。

去年六月份,微软推出了包含13亿参数的Phi-1,主要应用于QA 问答、文本处理等领域。该模型使用大量高质量数据进行训练,在基准测试中的表现甚至超过同类模型十倍以上。

今年九月份,微软又进一步推出了Phi-1.5版,尽管依旧仅含13亿元参数,但已可创作诗歌、电子邮件及故事,甚至可以对大量文本进行总结概括。在常识、语言理解以及推理的基准测试中,该版本的模型在部分领域已经可以媲美甚至超越含有高达100亿参数的同类模型。

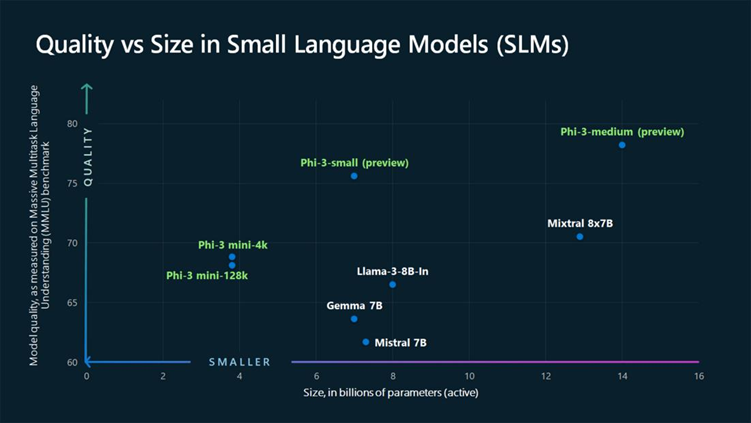

现如今,Phi-2的出现,使其所包含的参数数量达到惊人的27亿,尽管与其他大型语言模型相比仍显不足,它却在逻辑推理和系统安全性能上展现出不容忽视的提升。通过适当的调整和定制化,小型的语言模型将成为云和边缘应用的得力助手。

Google研发的Gemini Nano-2 3.2B模型

针对面向小型设备本地操作设计的Gemini Nano,新升级的2.0版本有着高达32亿的参数,预计将首先配置在Pixel 8 Pro手机上。

就录音功能而言,选择所需的音频文件后,用户只需点击“文本稿”标签,再点选上方的“总结”按钮,该应用便能迅速生成完整的主旨简报。

而在用户最为依赖的Gboard输入法中,Gemini Nano的加入将极大程度提高交互的自然度,未来包括WhatsApp在内的众多应用将会逐步引入这一更加人性化的功能。

-

微软

+关注

关注

4文章

6627浏览量

104319 -

模型

+关注

关注

1文章

3298浏览量

49063 -

语言模型

+关注

关注

0文章

538浏览量

10315

发布评论请先 登录

相关推荐

谷歌Gemini AI目标年底用户达5亿

谷歌正式发布Gemini 2.0 性能提升近两倍

谷歌发布Gemini 2.0 AI模型

谷歌计划12月发布Gemini 2.0模型

联发科新一代天玑旗舰芯片针对谷歌大语言模型Gemini Nano优化

在英特尔酷睿Ultra7处理器上优化和部署Phi-3-min模型

微软Phi-2 2.7B性能领先谷歌Gemini Nano-2 3.2B

微软Phi-2 2.7B性能领先谷歌Gemini Nano-2 3.2B

评论