微软明年减少H100 订单至8 万台,大摩指出,但这是因为要改单拿B100,价格虽较H100 贵5 成,但算力是HBM 的2 倍,并会拿些许AMD MI300,而英伟达可能会延迟对台积电明年下半年CoWoS 产能的预付款,但这不是砍单,主要是B100 芯片产能需要2 倍的CoWoS 产能。

大摩表示,微软可能会将2024 年H100 AI 伺服器的订单,从12 万台减少至8 万台,并将部分订单转移到B100,预计2024 年第四季出货,因为B100 的运算能力至少是H100 的2 倍,但价格仅高出 50~60%。

大摩指出,微软从2024 年第二季开始将透过英业达将部分订单转移到MI300X,而且NVIDIA 在2024 年第二季对台积电CoWoS 产能的预付款可能会有所延迟,但这并不意味着NVIDIA 在2024 年对台积电CoWoS 的需求减少,反而是B100 需要2 倍的CoWoS 产能。

中国GPU 方面,大摩指出,美国商务部长提出警告,华盛顿将「改变」出口管制措施,以阻止NVIDIA 专门针对中国市场进行芯片改良,而L20S 的云端推理似乎符合效能密度规则,并没有使用高效能的HBM,并预计年底前就准备好出货,至于华为910B 需求畅旺,但代工能力却不足。

散热方面,大摩指出, 散热解决方案供应商预计AWS AI AISC 伺服器的出货量将在2023 年第四季成长,而AI AISC 的3D VC 售价接近100 美元,预计微软Maia 的水冷板出货量最快要到2024 年第一季增加。

2023年Q3,英伟达AI GPU销量达50万块

据市场跟踪公司 Omdia 的统计分析,英伟达在 2023 年第三季度大约卖出了 50 万台 H100 和 A100 GPU,此前,Omdia 通过英伟达第二季度的销售额,估计其大概卖出了 900 吨 GPU。据英伟达财报显示,在本财年第三季度,Nvidia 在数据中心硬件上获得了 145 亿美元的收入,比去年同期几乎翻了两番。这显然得益于随着人工智能和高性能计算(HPC)的发展而变得炙手可热的 H100 GPU。

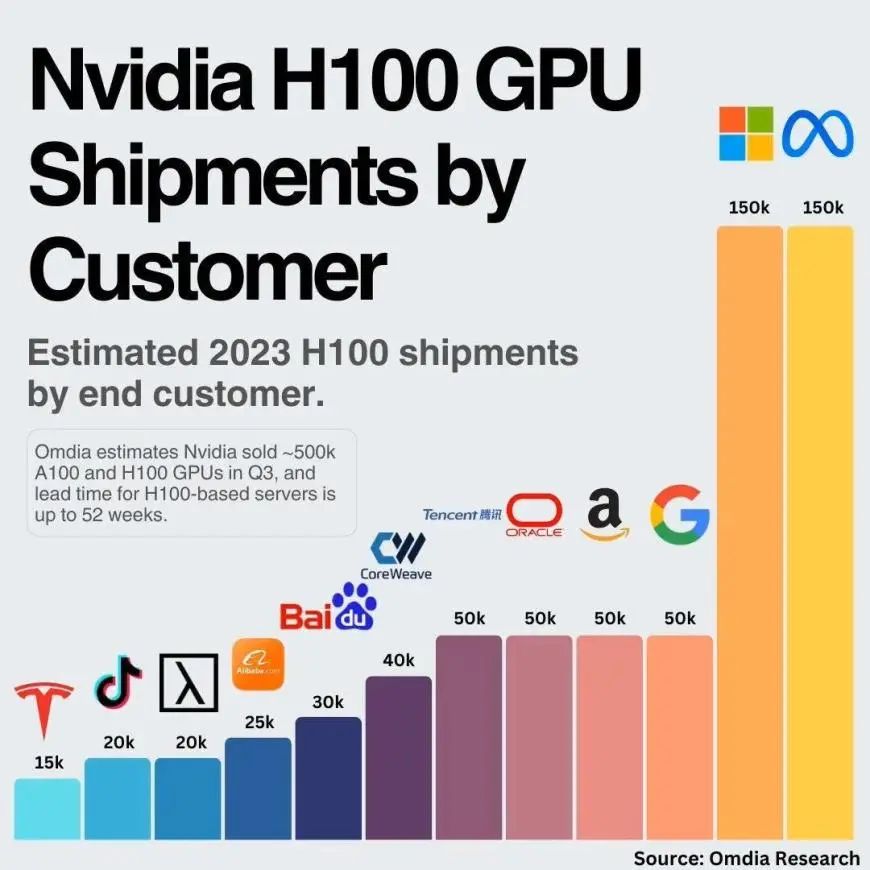

市场跟踪公司 Omdia 表示,Nvidia 售出了近 50 万个 A100 和 H100 GPU,庞大的需求量也导致了,基于 H100 的服务器需要 36~52 周的时间才能交付。

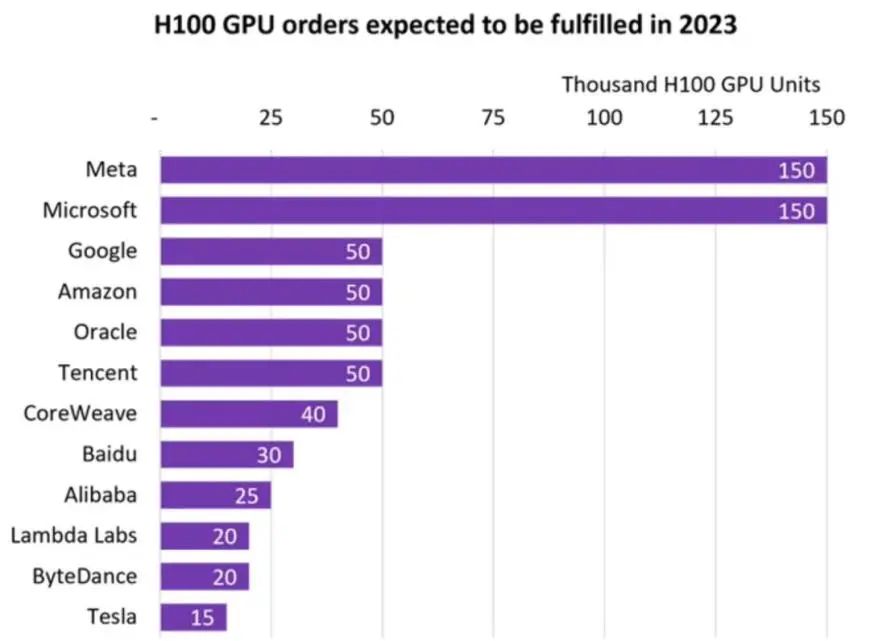

Meta 和微软是最大买家。它们各自采购了多达 15 万个 H100 GPU,大大超过了谷歌、亚马逊、甲骨文和腾讯采购的数量(各 5 万个)。

英伟达明年推新AI芯片,加速CoWoS封装需求

人工智能(AI)芯片带动先进封装需求,市场预期AI芯片大厂英伟达(Nvidia)明年将推出新一代绘图芯片架构,加速CoWoS封装需求,台湾,韩国、美国、日本、甚至中国等半导体大厂,积极布局2.5D先进封装。

AI芯片带动先进封装需求,加速AI芯片效能,CoWoS先进封装扮演关键角色,不过CoWoS产能仍短缺,影响包括英伟达在内的大厂AI芯片出货进度。

天风国际证券分析师郭明錤预期,先进封装CoWoS供应在第4季可显著改善,有利未来生产能见度。美系外资法人表示,随着CoWoS产能扩充,英伟达AI芯片出货量看增,这也反向带动CoWoS产能需求成长。

外资评估,英伟达H100绘图芯片(GPU)模组第4季供应量可到80万至90万个,较第3季约50万个增加,预估明年第1季供应量可到100万个,主要是CoWoS产能持续提升。

至于CoWoS产能配置,外资法人评估,英伟达可从台积电取得5000至6000片CoWoS晶圆产量,也将从后段专业委外封测代工(OSAT)厂取得2000至3000片CoWoS产量。

市场预期,英伟达明年将推出新一代B100绘图芯片架构,外资和本土投顾评估,B100架构可能采用台积电的4纳米制程,推估采用结合2颗GPU晶粒和8颗高频宽记忆体(HBM ),因此也将带动CoWoS先进封装需求。

本土期货法人分析,CoWoS先进封装主要有3种技术架构,其中矽中介层(CoWoS-S)封装是目前主流,包括英伟达H100芯片和超微(AMD)MI300芯片均采用CoWoS-S封装,效能佳不过成本较高。

至于导入重布线层(RDL)的有机中介层(CoWoS-R)封装可降低成本,另外CoWoS-L封装在矽中介层加进主动元件LSI层提升芯片设计及封装弹性,可支援更多颗高频宽记忆体堆叠,预期明年CoWoS-R与CoWoS-L封装应用将明显增加。

台积电已卡位CoWoS先进封装3种技术架构,后段封测厂日月光半导体也布局扇出型FOCoS-Bridge(Fan-Out-Chip-on-Substrate-Bridge)封装技术,并推出跨平台整合的先进封装设计平台工具。

亚系外资和本土投顾指出,包括英特尔(Intel)、韩国三星(Samsung)、艾克尔(Amkor)、联电、中国江苏长电、通富微电等也布局2.5D先进封装,此外,日本索尼(Sony)、力成、美国德州仪器(TI)、韩国SK海力士(SK Hynix)等也急起直追。

值得注意的是,大多数服务器 GPU 都供应给了超大规模云服务提供商。而服务器原始设备制造商(如戴尔、联想、HPE)目前还无法获得足够的 AI 和 HPC GPU。

Omdia 预计,到 2023 年第四季度,Nvidia 的 H100 和 A100 GPU 的销量将超过 50 万台。

不过,几乎所有大量采购 Nvidia H100 GPU 的公司都在为人工智能、HPC 和视频工作负载开发定制自己的芯片。

因此,随着他们转向使用自己的芯片,对 Nvidia 硬件的采购量可能会逐渐减少。

审核编辑:黄飞

-

微软

+关注

关注

4文章

6593浏览量

104048 -

gpu

+关注

关注

28文章

4735浏览量

128919 -

服务器

+关注

关注

12文章

9142浏览量

85384 -

英伟达

+关注

关注

22文章

3773浏览量

91023

原文标题:传微软砍单英伟达H100

文章出处:【微信号:晶扬电子,微信公众号:晶扬电子】欢迎添加关注!文章转载请注明出处。

发布评论请先 登录

相关推荐

微软砍单英伟达H100减少至8万台

微软砍单英伟达H100减少至8万台

评论