哈佛大学在量子计算方面取得了新突破。这是一个具有48个逻辑量子比特的新型逻辑量子处理器。据称,它可以在纠错系统上执行大规模算法。

在量子计算中,一个量子比特或“量子位”是一个信息单位,就像经典计算中的二进制位一样。二十多年来,物理学家和工程师们向世界展示了量子计算在原则上是可能的,通过操纵量子粒子——无论是原子、离子还是光子,来创造物理量子位。 但是,成功地利用量子力学的奇异之处进行计算,比简单地积累足够多的物理量子位要复杂得多,因为物理量子位本身就不稳定,容易从量子状态中崩溃。 创建逻辑量子位作为可控单元——就像经典比特一样,一直是该领域的一个基本障碍,人们普遍认为,除非量子计算机能够在逻辑量子位上可靠地运行,否则技术无法真正起飞。 近期,一组来自美国哈佛大学的团队在寻求稳定、可扩展的量子计算方面实现了一个关键的里程碑。该团队首次创建了一个可编程的逻辑量子处理器,能够编码多达48个逻辑量子比特,并执行数百个逻辑门操作。

据悉,他们的系统是第一个在纠错量子计算机上执行大规模算法的演示,预示着早期容错或可靠不间断量子计算的到来。研究人员将这一成就描述为一个可能的转折点。 研究人员说,“我认为这是一个非常特别的事情即将到来的时刻。尽管未来仍有挑战,但我们预计这一新的进展将大大加速大规模、有用的量子计算机的发展。” 这一突破建立在多年来对一种称为中性原子阵列的量子计算架构的研究之上,该架构也是在哈佛大学的实验室中首创的。最新研究成果已于近期发表在了《自然》杂志上。

具体而言,一块超冷的悬浮铷原子是这个系统的核心。这些原子,作为系统的物理量子位,可以移动和形成对或成为“纠缠”在计算过程中。纠缠的原子对聚集在一起形成量子门,这是代表计算能力的单位。该团队此前在纠缠操作中展示了低错误率,从而确立了中性原子阵列系统的可靠性。 在他们的逻辑量子处理器中,科学家们现在已经证明了使用激光对整个逻辑量子位部分的并行多路控制。与单独控制物理量子位相比,这种方法更高效且可扩展。 “我们正试图标志着这一领域的转变,开始用纠错量子位而不是物理量子位测试算法,并为更大的设备开辟道路。”他们说。

审核编辑:黄飞

-

量子计算

+关注

关注

4文章

1105浏览量

34973 -

量子比特

+关注

关注

0文章

38浏览量

8834 -

量子处理器

+关注

关注

0文章

22浏览量

1021

原文标题:量子计算飞跃在即?哈佛大学研发全球首个可编程逻辑处理器

文章出处:【微信号:chinastarmarket,微信公众号:科创板日报】欢迎添加关注!文章转载请注明出处。

发布评论请先 登录

相关推荐

可编程逻辑控制器的特点与用途

可编程逻辑控制器的基本功能

什么是现场可编程逻辑阵列?它有哪些特点和应用?

PLC(可编程逻辑控制器)利用Modbus通讯可以完成哪些任务呢?

Quantinuum 与 Microsoft 合作进行可靠逻辑量子比特的突破性演示,迈入可靠量子计算的新阶段

FPGA零基础学习系列精选:半导体存储器和可编程逻辑器件简介

现场可编程门阵列的原理和应用

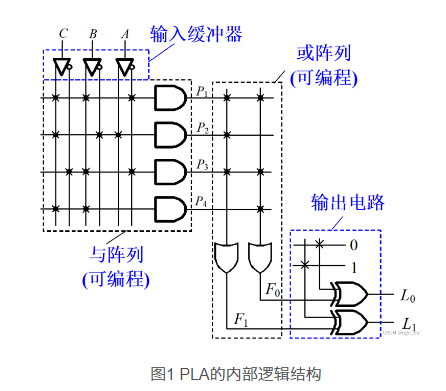

可编程逻辑阵列PLA内部逻辑结构示意

哈佛大学全球首个可编程逻辑处理器,具有48个逻辑量子比特

哈佛大学全球首个可编程逻辑处理器,具有48个逻辑量子比特

评论