以ChatGPT为代表的AI大模型应用普及将推动算力需求快速增长,服务器产业链是其中重要的受益环节之一,AI计算的普及将推动服务器产业链光模块向800G升级提速。

算力网络驱动下光模块市场需求预测

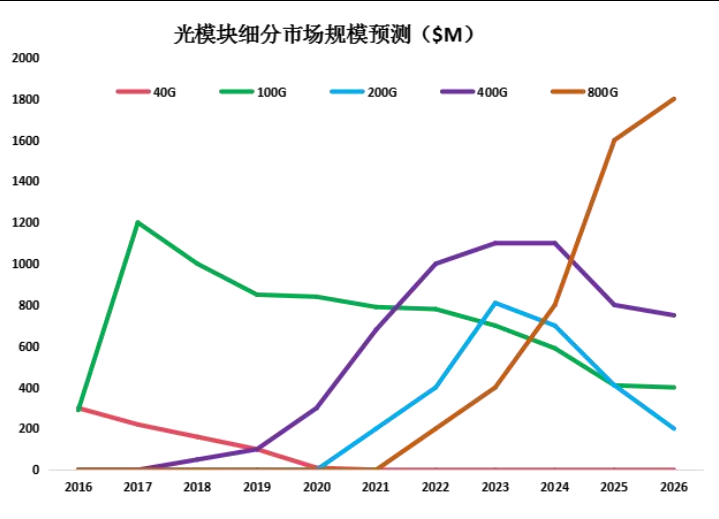

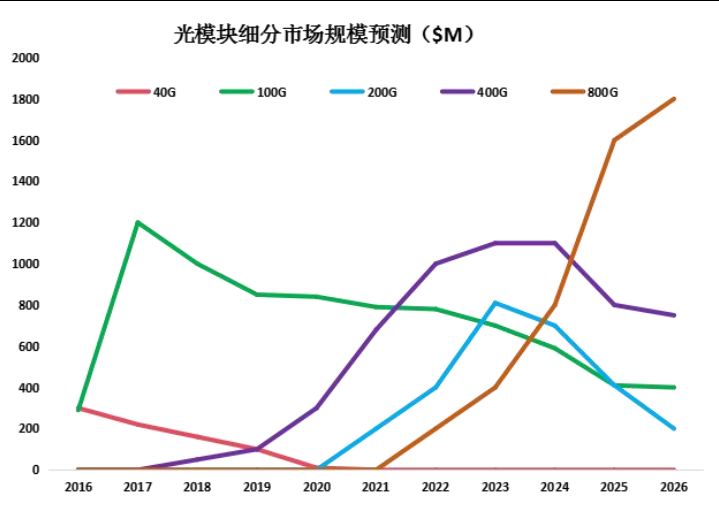

光模块是数据中心内部互连和数据中心相互连接的核心部件。100G和400G是主流产品,800G过去主要用在超算等领域。据LightCounting预计,2023年800G全球普及率仅0.62%。而以ChatGPT为代表的AI大模型,对数据中心内外的数据流量都提出了新要求,有望推动光模块加速向800G升级。800G光模块将从2025年底开始主导光模块市场。

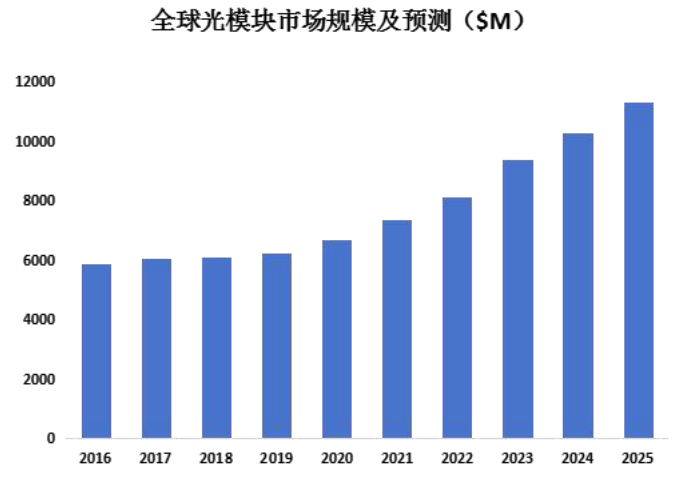

根据LightCounting的数据,2016年至2020年,全球光模块市场规模从58.6亿美元增长到66.7亿美元,预测2025年全球光模块市场将达到113亿美元,为2020年的1.7倍。从结构上看数通市场占60%,电信市场占40%左右。

AI算力场景光模块应用情况

首先我们以英伟达的SuperPOD为例测算单颗GPU与光模块的比例。测算仅考虑IB网络对应的光模块需求。以140个节点的集群为例,每台举例服务器需要8颗GPU芯片,共需140×8=1120颗芯片;集群中每20台服务器组成一个SU(scalable units,可扩展单元),共7个SU。IB网络架构下实现了完整的胖树(Fat-Tree)拓扑结构,胖树架构在训练场景中最优的配置是上下行端口数一样,即无阻塞的网络,具体来看:

第一层:每个SU 中配置8台叶交换机,共有56台叶交换机;

第二层:每10台脊交换机组成一个交换机组Spine Group( SG),每个SU 的第一个叶交换机连接到SG1中的每个交换机,每个SU的第二个叶交换机连接到SG2中的每个交换机,共有80个脊交换机;

第三层:每14台核心交换机组成一个交换机组Core Group(CG),对应共28个核心交换机。

使用系统的对应计算侧和存储侧线缆全部采用AOC有源光缆,因此每个端口对应一个光模块,即每条光缆对应2个光模块,因此计算侧和存储侧共需要(1120+1124+1120)×2+(280+92+288)×2=8048个光模块,即单颗GPU对应所需200G光模块数量约为1:7.2

DGX GH200超级计算机搭载256个超级芯片,每个超级芯片可视为一个服务器,通过交换机进行互联。从结构上来看,超级计算机采用两层的胖树拓扑结构,第一、二层分别使用96个、36个交换机,每台交换机拥有32个速率为800G的端口;此外超级计算机还配备了24个IB交换机用于IB网络。按照端口进行估算,L1层距离较近因此假定使用铜缆进行连接不涉及光模块,L2层36个交换机在无收敛胖树架构下,第二层交换机端口向下与L1层交换机上行端口互联,因此共需要36×32×2=1152个800G光模块;IB网络架构下,24台交换机需要24×32=768个800G光模块;则DGX GH200超级计算机共需要1152+768=1920个800G光模块,对应每颗芯片12个800G光模块。则GPT-3单日完成训练需要8万颗以上200G光模块,如果考虑到FLOPS的利用率约为20%-30%,则需要光模块的数量将约为35万颗。

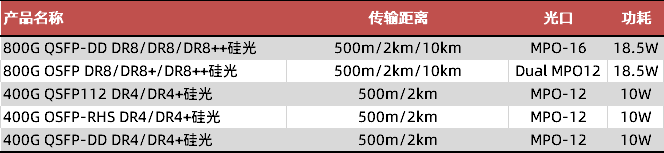

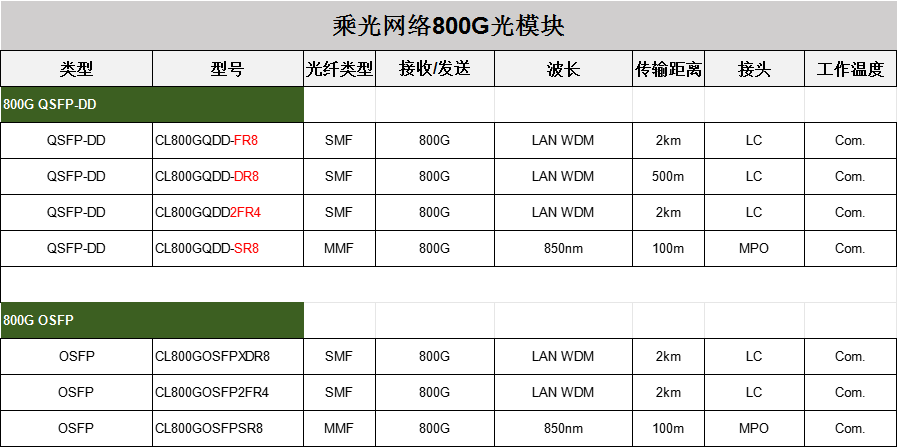

易飞扬应用于算力场景的光模块

AI发展促进了海量光模块需求,易飞扬则已于2023年完成800G/400G AI应用光模块产线建设任务,新建成的生产线主要用于4×100G PAM4和8×100G PAM4光模块和有源光缆的生产。

得益于供应链的支持,易飞扬的系列AI光模块量产顺利,公司本身的产品多样化设计能力、订单能力和供应链能力形成了较好的匹配关系。可以为中小客户提供灵活有效的需求交付和样品测试。

审核编辑:刘清

-

交换机

+关注

关注

20文章

2615浏览量

99180 -

光模块

+关注

关注

76文章

1234浏览量

58860 -

GPU芯片

+关注

关注

1文章

303浏览量

5773 -

ChatGPT

+关注

关注

29文章

1547浏览量

7431

原文标题:AI算力应用中的光模块产品

文章出处:【微信号:gigalight_yifeiyang,微信公众号:易飞扬通信】欢迎添加关注!文章转载请注明出处。

发布评论请先 登录

相关推荐

青云科技强化AI算力架构,升级产品与服务体系

九章云极DataCanvas公司「算力包」产品璀璨亮相2024中国算力大会!

大模型时代的算力需求

DPU技术赋能下一代AI算力基础设施

AI算力的需求推动光模块行业快速迭代

认识一下NI SWITCH模块的组成和特点

认识一下AI算力应用中的光模块产品

认识一下AI算力应用中的光模块产品

评论