英伟达Grace-Hopper提供了一个紧密集成的CPU + GPU解决方案,针对生成式人工智能逐渐成为主导的市场环境。

为了提高性能,这家GPU制造商将HBM3e内存放入了名为GH200的新型芯片封装中,该封装包括一个Grace CPU和一个Hopper GPU。Hopper以前在芯片封装中使用HBM3存储器。

英伟达将把两个GH200芯片(每个都有一个72核CPU和一个Hopper GPU)连接到一个更大的芯片集群中,用于扩展数据中心。

HBM3e内存比HBM3快50%,总带宽为每秒10TB;CPU基于Neoverse V2设计。英伟达CEO黄仁勋表示:“这些芯片正在生产中,我们将在2023年年底左右进行样品测试。”

一个封装中的两个GH200芯片将具有282GB的HBM3e内存,这相比于之前GH100芯片的192GB HBM内存是一大改进。它还将拥有每秒8千万亿次的人工智能计算能力,以及每秒10 TB的HBM3e性能。

该芯片组可以接受任何大型语言模型,“可以疯狂地进行推理”。英伟达表示,这些芯片可以运行3.5倍大的模型,并通过更快的内存带宽获得性能提升。

该公司打算将256个GH200 GPU配置到一个名为Grace Hopper的超级计算机系统中,该系统将提供1百亿亿次的人工智能性能。黄仁勋将该系统称为“世界上最大的单一GPU”,所有256个GH200协同工作。

目前所有的大型学习模型都是在Grace Hopper超级计算机这样的系统上训练的。黄仁勋说,未来随着人工智能在设备之间的分布越来越广,每个应用程序都将使用一个大型语言模型。随着越来越多的公司探索人工智能来提高运营效率,HopperGPU现在很受欢迎。该公司承认GPU供应短缺。

黄仁勋还描绘了如何分解其GPU路线图以满足分布式模型。Grace Hopper超级计算机位于顶部,然后可以将其分配到具有不同要求的服务器和桌面GPU上的不同GPU上。

审核编辑:刘清

-

gpu

+关注

关注

28文章

4826浏览量

129716 -

人工智能

+关注

关注

1799文章

48036浏览量

241912 -

英伟达

+关注

关注

22文章

3872浏览量

92391 -

HBM

+关注

关注

0文章

392浏览量

14892

原文标题:英伟达GH200增加HBM3e内存!

文章出处:【微信号:SSDFans,微信公众号:SSDFans】欢迎添加关注!文章转载请注明出处。

发布评论请先 登录

相关推荐

英伟达CEO确认:液冷Grace Blackwell服务器无过热问题

今日看点丨苹果与富士康接洽,商讨在中国台湾生产AI服务器;英伟达正在开发一款基于ARM架构的新型CPU

软银升级人工智能计算平台,安装4000颗英伟达Hopper GPU

英伟达Blackwell可支持10万亿参数模型AI训练,实时大语言模型推理

英伟达:Hopper芯片需求强劲 英伟达发言人谈生产增长

英伟达GPU新品规划与HBM市场展望

亚马逊AWS暂缓采购英伟达GH200芯片,期待Blackwell更强

亚马逊AWS暂缓订购英伟达Grace Hopper,等待新品Grace Blackwel

亚马逊未中断英伟达订单,等待Grace Blackwell更强性能

英伟达静候新品来临,亚马逊暂缓购买Grace Hopper

NVIDIA通过CUDA-Q平台为全球各地的量子计算中心提供加速

进一步解读英伟达 Blackwell 架构、NVlink及GB200 超级芯片

美国首个Grace Hopper架构超算Venado落地:达10 exaFLOPS

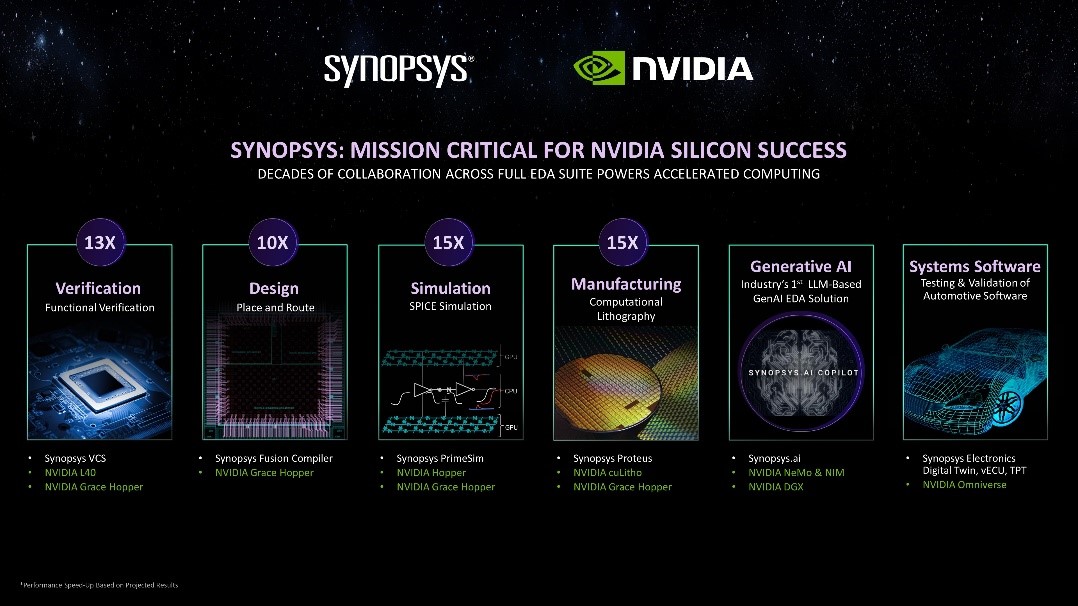

新思科技携手英伟达:基于加速计算、生成式AI和Omniverse释放下一代EDA潜能

英伟达Grace-Hopper提供一个紧密集成的CPU + GPU解决方案

英伟达Grace-Hopper提供一个紧密集成的CPU + GPU解决方案

评论