在软件开发中,经常会遇到数据波动大的情况,这给我们的开发和数据处理带来了很大的挑战。本文将详细讨论如何处理软件中数据波动大的情况,并提供一些有效的解决方案。

首先,我们需要了解数据波动大的原因。数据波动大可能是由于数据源的不稳定性,或者是数据本身的特点导致的。例如,金融行业中的股票价格,由于市场的不确定性,价格波动很大;又如天气预测中的气温,由于天气变化的复杂性,气温也会出现大幅度的波动。在这些情况下,我们需要采取一些策略来稳定数据,并进行准确的处理。

一种常见的方法是使用滑动窗口技术。滑动窗口是一种按照时间顺序滑动的固定大小的数据片段。该技术可以帮助我们抓取波动的数据,并对数据进行平滑处理。具体来说,我们可以定义一个固定大小的时间窗口,例如5分钟或10分钟,在这个时间窗口内对数据进行采样和平均,得到一个平均值作为窗口内数据的代表。这样可以减少数据的波动性,并提供一个更加稳定的数据用于后续的处理。

另一种常用的方法是使用移动平均法进行数据处理。移动平均法是通过计算一系列数据的平均值来减小数据的波动。具体来说,我们可以定义一个固定大小的滑动窗口,该窗口会按照一定的步长从数据序列的起始位置滑动到最后位置。在滑动过程中,我们可以计算窗口内数据的平均值,并用该平均值代表该窗口内的数据。这样可以减小噪声数据对整体数据的影响,并提供一组相对稳定的数据用于后续的分析和处理。

此外,我们还可以使用数据预测和预测建模来处理波动大的数据。通过对历史数据的分析和建模,我们可以预测未来数据的趋势和变化,从而对当前的波动数据进行预测和补偿。常用的预测和建模方法包括时间序列分析、回归分析、神经网络等。通过将预测模型与实时数据相结合,我们可以实现对波动大数据的处理和预测,提高数据的准确性和稳定性。

另外,我们还可以采用异常检测和过滤的方法来处理波动大的数据。异常检测是一种通过对数据进行统计和分析,检测数据中的异常点和异常行为的方法。在波动大的数据中,异常点往往是造成波动的主要原因之一。通过检测和过滤异常点,我们可以减小数据的波动性,并提供更加准确和稳定的数据用于后续的处理。

最后,提高数据采集和传输的稳定性也是处理波动大数据的关键。数据采集和传输是整个数据处理过程中的关键环节,稳定性的提高将直接影响到数据的准确性和稳定性。在数据采集环节,我们需要确保采集设备的稳定性和准确性,并采用可靠的数据传输协议和技术,确保数据能够准确地传输到后端系统。在数据传输过程中,我们需要考虑网络连接的稳定性和传输延迟,采用一些冗余机制和错误校验机制,以确保数据能够完整、准确地传输到指定的目标系统。

综上所述,处理软件中数据波动大的问题,我们可以采用滑动窗口技术、移动平均法、数据预测和建模、异常检测和过滤以及提高数据采集和传输的稳定性等多种方法。这些方法能够帮助我们抓取波动大的数据,并进行准确和稳定的处理,提高数据的质量和可靠性,为后续的分析和决策提供更加准确可靠的基础。在实际应用中,我们可以根据具体的需求和场景选择合适的方法和技术进行处理,以达到最佳的效果。

-

数据

+关注

关注

8文章

7221浏览量

90118 -

软件

+关注

关注

69文章

5058浏览量

88398 -

窗口

+关注

关注

0文章

66浏览量

10933 -

大数据

+关注

关注

64文章

8925浏览量

138170

发布评论请先 登录

相关推荐

ADS1274采样数据波动太大怎么解决?

批量处理txt数据小软件

在数据采集过程中,如果有较大的噪声波动,一般会将临近的N个点平均作为输出,请设计一个程序处理(N=4)

求解答:数据采集过程中有较大的噪声波动怎么处理?

labview做数据处理 思路!!!!!!!

matlab二维数据曲线处理

如何处理存储在非易失性设备中的内存数据集损坏

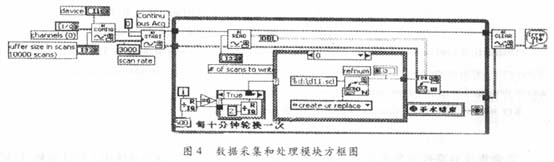

基于LabVIEW的数据采集与处理软件编程技巧

基于LabVIEW的多道电生理系统中数据的采集与处理

数据波动的异常判别方法

浅谈光学波动中的波动概述、波前

软件中数据波动大怎么处理

软件中数据波动大怎么处理

评论