Nvidia 表示,H200 Tensor Core GPU 具有更大的内存容量和带宽,可加快生成 AI 和 HPC 工作负载的速度。

Nvidia H200 是首款提供 HBM3e 的 GPU,HBM3e 是更快、更大的内存,可加速生成式 AI。

H200 芯片定于 2024 年第二季度发布,Nvidia 表示将与“全球系统制造商和云服务提供商”合作以实现广泛可用性。

JAEALOT

Nvidia

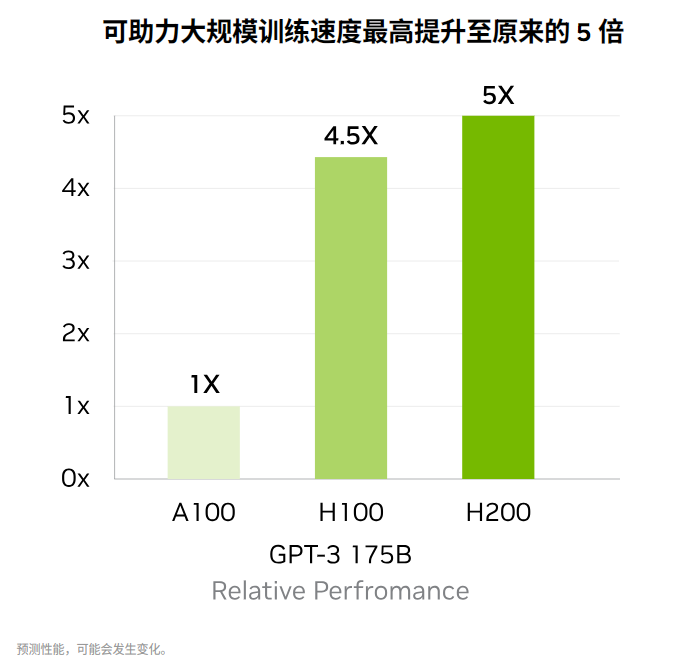

OpenAI推出ChatGPT已经一段时间了 ,全球对AI芯片的需求比以往任何时候都更加难以满足。如今,大多数大型科技公司都将注意力集中在生成式人工智能上。对于制造数量最多、性能最高的图形处理单元 (GPU) 的公司 Nvidia 公司来说,现在的情况从未如此好过。在发布了数十款芯片以满足看似呈指数级增长的人工智能市场之后,这家图形芯片巨头展示了迄今为止最强大的 GPU——H200。

NVIDIA H200 Tensor Core GPU 诞生之际,Nvidia 正在努力捍卫其 在 AI 计算领域的主导地位 ,面对 英特尔、AMD以及众多芯片初创公司和 Amazon Web Services 等试图抢占市场份额的云服务提供商。在生成人工智能工作负载驱动的芯片需求激增的情况下,市场份额不断增加。

为了保持在人工智能和高性能计算 (HPC) 硬件领域的领先地位,英伟达上月初公布了加快新 GPU 架构开发的计划。根据为投资者发布的路线图 以及 SemiAnalysis的进一步解释,这个想法是要恢复到一年一次的产品推出节奏 。SemiAnalysis 的报告中写道:“Nvidia 对 AI GPU 进行年度更新的举动非常重要,并且会产生许多影响。”

这一切的开始就是 Nvidia 推出的 H200,它利用 Hopper 架构来加速人工智能应用程序。它是去年发布的H100 GPU的后续产品 ,也是此前 Nvidia 最强大的 AI GPU 芯片。简而言之,H200 现在是 Nvidia 产品组合中最强大的 AI 芯片。

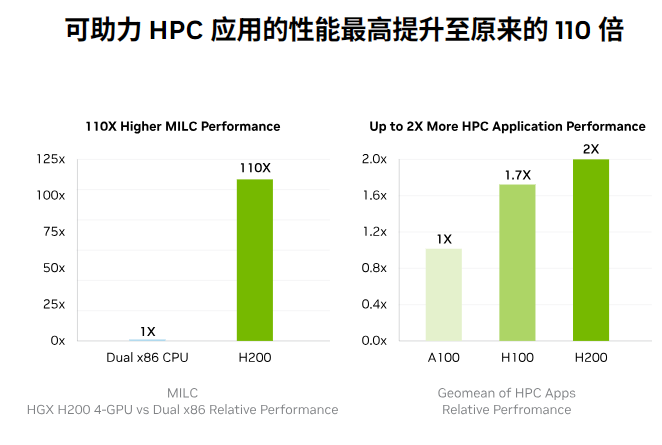

Nvidia 超大规模和 HPC 副总裁 Ian Buck 认为,“借助业界领先的端到端 AI 超级计算平台 Nvidia H200,可以更快地解决世界上一些最重要的挑战。” 一般来说,GPU 在人工智能应用中表现出色,因为它们能够执行大量并行矩阵乘法,这是神经网络运行的关键操作。

它们在构建人工智能模型的训练阶段和随后的“推理”阶段都发挥着至关重要的作用,在“推理”阶段,用户将数据输入到人工智能模型中,并提供相应的结果。Buck 指出:“要通过生成式 AI 和 HPC 应用程序创建智能,必须使用大容量、快速的 GPU 内存高速有效地处理大量数据。”

因此,引入 H200 将带来进一步的性能飞跃,包括与 H100 相比,Llama 2(一个 700 亿参数的 LLM)的推理速度几乎翻倍。据 Nvidia 称,未来的软件更新预计会带来 H200 的额外性能领先优势和改进。

虽然 H200 看起来与 H100 基本相似,但其内存的修改有明显的增强。新的 GPU 引入了一种创新且更快的内存规范,称为 HBM3e。这将 GPU 的内存带宽提升至每秒 4.8 TB,比 H100 的每秒 3.35 TB 明显增加。它将总内存容量从前代产品的 80GB 扩展至 141GB。

“Nvidia H200 是首款提供 HBM3e 的 GPU,HBM3e 速度更快、内存更大,可加速生成式 AI 和大型语言模型 (LLM),同时推进 HPC 工作负载的科学计算。凭借 HBM3e,NVIDIA H200 以每秒 4.8 TB 的速度提供 141GB 内存,与前身 NVIDIA A100 相比,容量几乎翻倍,带宽增加 2.4 倍。”该芯片巨头 表示。

结合实际情况来看,OpenAI 经常提到面临 GPU 资源短缺,导致 ChatGPT 性能下降的问题。为了维持任何水平的服务,该公司采取速率限制。理论上,加入H200可以缓解当前运行ChatGPT的AI语言模型的资源限制,使它们能够有效地迎合更广泛的客户群。

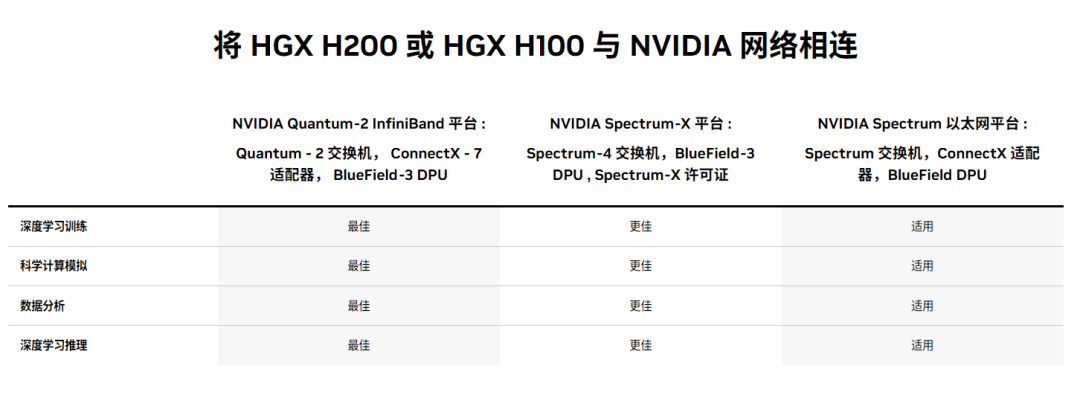

Nvidia 还表示,它将提供多种外形规格的 H200。其中包括四路和八路配置的 Nvidia HGX H200 服务器主板,与 HGX H100 系统的硬件和软件兼容。它还将在 Nvidia GH200 Grace Hopper Superchip 中提供,它将 CPU 和 GPU 组合到一个封装中。

“通过这些选项,H200 可以部署在各种类型的数据中心中,包括本地、云、混合云和边缘。NVIDIA 的 全球合作伙伴服务器制造商生态系统 (包括华擎 Rack、华硕、戴尔科技、Eviden、技嘉、惠普企业、英格拉科技、联想、QCT、Supermicro、纬创资通和 Wiwynn)可以使用 H200 更新其现有系统。” 。

据美国芯片巨头亚马逊网络服务(AWS)称,除了CoreWeave、Lambda、和乌尔特尔。目前,英伟达在AI GPU市场处于领先地位。

然而,AWS、谷歌、微软等主要参与者以及 AMD 等传统 AI 和 HPC 实体正在积极准备 其下一代处理器用于训练和推理。为了应对这种竞争格局,Nvidia 加快了基于 B100 和 X100 的产品进度。

-

芯片

+关注

关注

459文章

51568浏览量

429781 -

NVIDIA

+关注

关注

14文章

5107浏览量

104466 -

人工智能

+关注

关注

1800文章

48083浏览量

242163

发布评论请先 登录

相关推荐

Nvidia 正在利用迄今为止最强大的芯片 H200 推动人工智能革命

Nvidia 正在利用迄今为止最强大的芯片 H200 推动人工智能革命

评论