电子发烧友网报道(文/李弯弯)近年来,AIGC技术的火爆,代表着AI正在从感知理解世界向生成创造世界跃迁。在近日举办的全球人工智能算力论坛上,宝德计算信创BU副总裁邓克武谈到,AIGC产业发展创新正在加速,预计到2030年市场规模会到达万亿。然而随着AI技术的飞速发展,算力也成为了制约AI大模型应用普及的关键因素。

大模型重塑产业格局

在邓克武看来,AIGC产业发展预计将会经历三个阶段。第一个阶段是2023年到2025年,属于培育摸索期,该阶段主要以遵循指令性加工和拼接式为主,例如,播报类(语音合成的电子书)、数字人(支持多种类型任务的数字人)、营销推广等。

第二个阶段是2025年到2027年,这个时期会是AIGC的应用蓬勃期,该阶段主要以人机联合共创的模式为主,例如,各种类型的生成任务,以AI生成为基础进行迭代;行业生态完善,底层大模型对外开发。

第三阶段是2028年以后,这个时期为AIGC增长期,到这个时候,产业链逐渐完善,商业化场景持续拓展拓深,深入变革各行业,预计2030年市场规模超万亿。

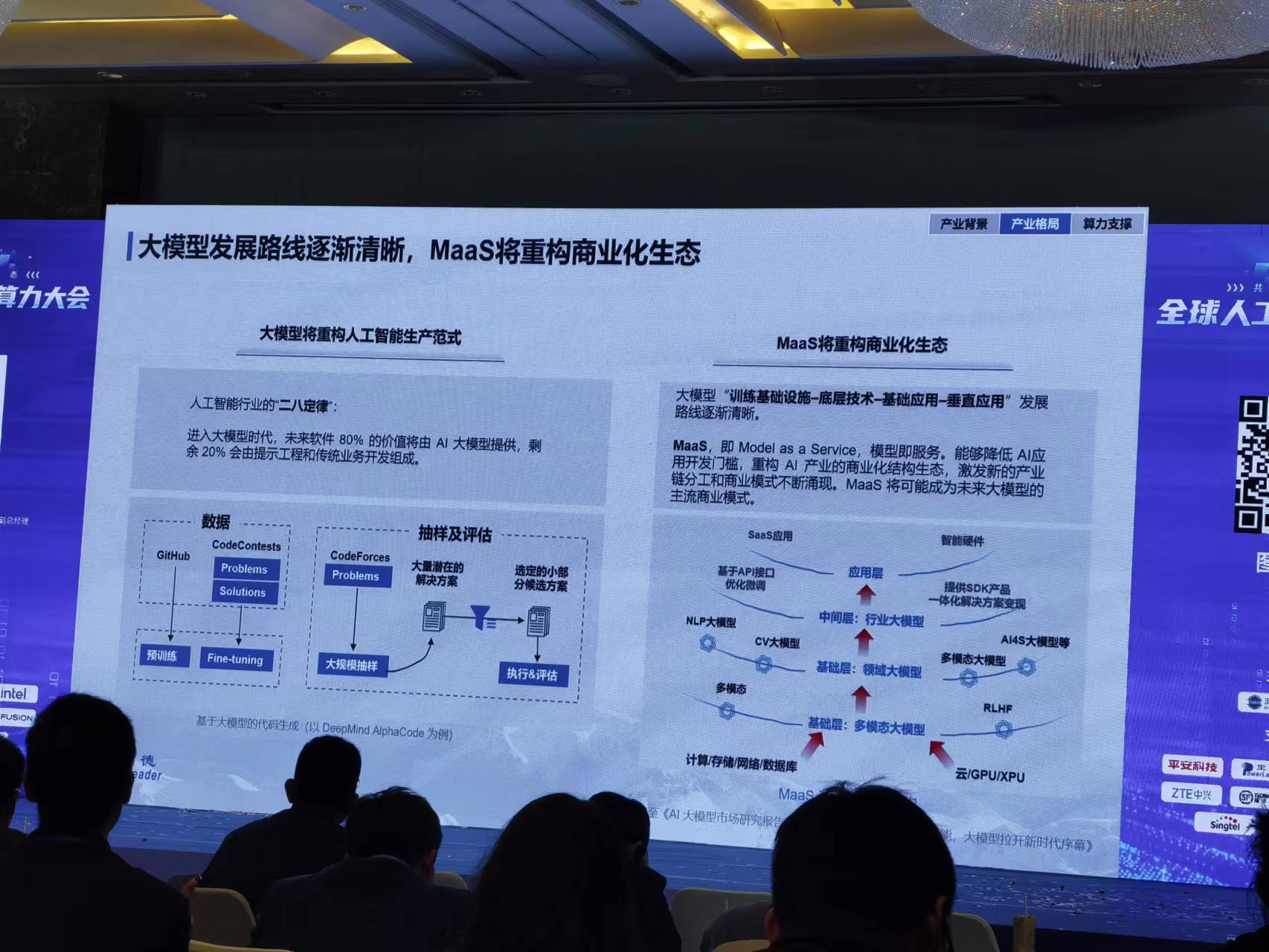

邓克武认为,大模型将重构人工智能生产范式。他还提到“人工智能行业的二八定律”,即进入大模型时代,未来软件80% 的价值将由AI大模型提供,剩余20% 会由提示工程和传统业务开发组成。

同时,他认为,MaaS将重构商业化生态,大模型“训练基础设施-底层技术-基础应用-垂直应用”发展路线逐渐清晰。MaaS,即Model as a Service,模型即服务,能够降低AI应用开发门槛,重构AI产业的商业化结构生态,激发新的产业链分工和商业模式不断涌现。MaaS将可能成为未来大模型的主流商业模式。

随着大模型的发展,其应用也会逐步拓展,从初期To C现象级应用向通用To B应用,再向场景化To B应用发展。当然,这个过程也面临不同的挑战,To C应用的挑战在于用户商业付费挑战大:使用门槛较低,用户量大且接受度高,落地及成长速度快,但客户付费意愿偏低,商业闭环挑战大。To B应用的挑战在于和行业数据&应用的深度融合:行业数据积累、模型调测和行业应用集成均需要时间,但客户付费能力强,未来增长及盈利空间广阔。

算力集群化发展是必然趋势

目前,国内已有超100+企业在战略布局大模型机会。对于企业来说,需要准备迎接产业变革,构筑新的竞争优势。如何做呢?其一,对内提升自身业务效率与感知,即与自身行业、业务特点和需求等深度结合;其二,面向中小企业提供AI模型服务,通过API/三方插件吸引更多应用及数据,通过提供模型开发服务,深度切入行业,掌握行业经验和数据;其三,面向AI创业者/企业提供算力服务,满足企业AI算力需求,构筑数字基础设施格局。

算力方面,大算力集群是业界厂家AI模型开发的共同选择,如腾讯数万卡规模的星星海AI集群,阿里巴巴12EFLOPS的灵骏AI集群,百度4EFLOPS 百舸AI集群,商汤3.7EFLOPS AIDC集群,华为数万卡规模昇腾AI集群等。

在邓克武看来,大模型对算力的需求将指数级增长,AI算力将从单机走向集群时代。据邓克武介绍,大模型算力需求每两年以750倍增长,而硬件算力供给每两年仅增长3倍。比如,从ResNet-50(2500万参数),到GPT-1(1.7亿参数),再到GPT-4(万亿级参数),计算需求需要十倍,到千倍的增长,存储需求经历百倍,到千倍的增长。AI算力和数据中心集群发展,可以加速产业创新。

宝德计算作为中国领先的计算产品方案提供商,构建了自强昇腾高密算力平台,以支撑大模型系统工程建设。在上述论坛上,邓克武详细介绍了公司的两款服务器:PR420KI G2训练服务器和PR410EI 训练服务器。

PR420KI G2训练服务器CPU采用了4颗鲲鹏920处理器,NPU采用了8颗昇腾910,节点内互联采用HCCS Full mesh互联高速网络;PR410EI 训练服务器CPU采用2颗第四代Intel至强可拓展处理器Sapphire Rapids,NPU采用8颗昇腾910,节点内互联采用HCCS Full mesh互联高速网络。

同时,他还介绍了公司的Pod集群组网,以256台训练服务器为例,共计2048颗Ascned910芯片。分成16组,每组16台服务器,里面放置一个完整的模型,每组之间采用数据并行;每组16台服务器,采用模型并行,每台服务器放1/16的模型。

据邓克武介绍,宝德面向多种大模型部署方式,还构建了差异化解决方案。此外,公司联合生态伙伴不断深化合作,成功实践了100多个AI项目,涵盖了电力、安平、教育、金融、互联网、智慧城市等行业,宝德将继续探索更多行业和细分领域智能化实践,共同加速AI行业智能化升级和落地。

写在最后

经过一年多时间的发展,大模型商业化应用已经成为业界探索的焦点,并且已经进展明显。与此同时,随着大模型训练和部署的持续加速,这对算力的需求也会大幅增长。为了满足大模型训练和部署需求,集群成为厂家模型开发的共同选择。而能够为各种大模型部署提供算力支持的企业也必然会乘风而起。

-

AI

+关注

关注

87文章

29665浏览量

267994 -

算力

+关注

关注

1文章

892浏览量

14685 -

AIGC

+关注

关注

1文章

352浏览量

1470 -

大模型

+关注

关注

2文章

2258浏览量

2332

发布评论请先 登录

相关推荐

【「大模型时代的基础架构」阅读体验】+ 未知领域的感受

名单公布!【书籍评测活动NO.41】大模型时代的基础架构:大模型算力中心建设指南

从千卡集群卡到万卡集群,燧原科技打造更好的AI算力底座

摩尔线程张建中:以国产算力助力数智世界,满足大模型算力需求

北京:规划建设支撑万亿级参数大模型训练需求的超大规模智算集群

大模型对算力需求指数级增长,集群成必然选择

大模型对算力需求指数级增长,集群成必然选择

评论