在本篇工作中,研究者探索了一种统一的学习方法,通过考虑多粒度的不确定性来同时对粗粒度和细粒度的图像检索进行建模。论文的方法集成了不确定性建模和不确定性正则化来提高召回率并增强检索过程,在三个公共数据集FashionIQ、Fashion200k 和 Shoes上,所提出的方法在baseline上分别提高了 +4.03%、+ 3.38% 和 + 2.40% Recall@50。

论文题目: Composed Image Retrieval with Text Feedback via Multi-Grained Uncertainty Regularization 论文链接: https://arxiv.org/abs/2211.07394 论文代码: https://github.com/Monoxide-Chen/uncertainty_retrieval

一、背景

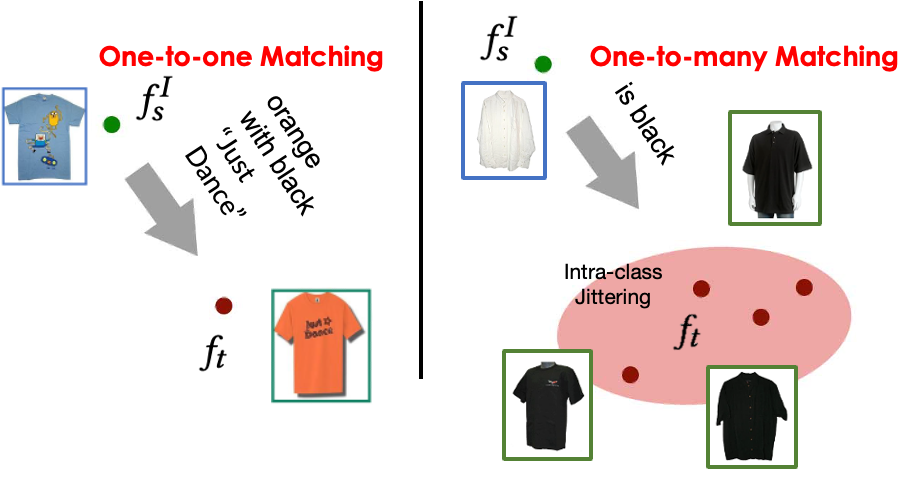

典型的检索过程包含两个步骤,即粗粒度检索和细粒度检索。粗粒度检索利用简短或不精确的描述查询图像,而细粒度检索则需要更多细节进行一对一映射。

之前工作有什么痛点?

1. 传统的图像检索系统要求用户提前提供准确的查询图像,通常是不好获得;而添加文本反馈,用户则可以对查询图像进行的修改,来逐渐细化他们的搜索。

2. 现有的组合搜索方法通常侧重于在训练过程中优化严格的成对距离,这与一对多粗粒度测试设置不同。过多关注一对一度量学习会削弱模型对潜在候选图片的召回能力。

二、方法

1、总览

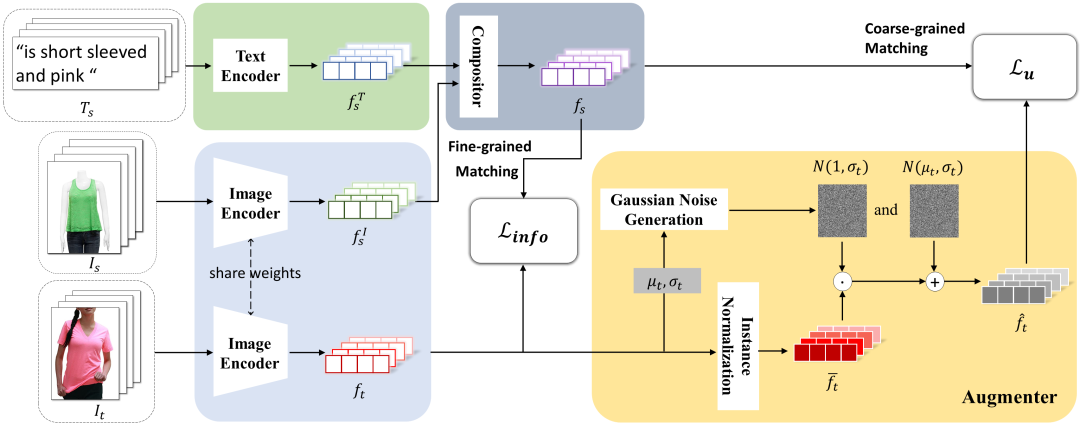

在这篇论文中,研究者不追更精细的网络结构,而是采用一种新的学习策略。因此,主要遵循现有的工作CosMo[1]来构建网络以进行公平比较,更多的结构细节在论文中进行了提供。

给定源图像  和用于修改的文本

和用于修改的文本  ,我们通过Compositor组合

,我们通过Compositor组合  和

和  得到了组合特征

得到了组合特征  。同时,我们通过与源图像相同的Image Encoder提取了目标图像

。同时,我们通过与源图像相同的Image Encoder提取了目标图像  的视觉特征

的视觉特征  。我们的主要贡献是通过Augmenter进行不确定性建模,以及对粗匹配进行的不确定性正则化。

。我们的主要贡献是通过Augmenter进行不确定性建模,以及对粗匹配进行的不确定性正则化。

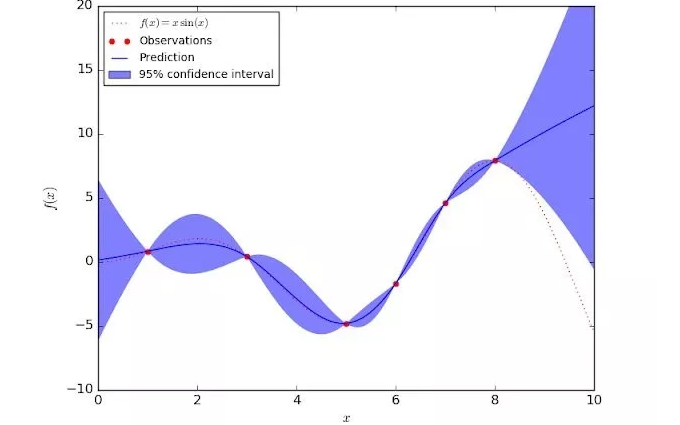

2、不确定性建模

如上图所示,不再采用严格的一对一匹配,而是促使模型专注于一对多匹配,即从细粒度过渡到粗粒度。因此,首先引入了一个用于噪声增强的Augmenter来生成抖动,这个模块直接作用于最终的特征空间。具体而言,Augmenter向目标特征  添加原始特征分布的高斯噪声。高斯噪声的均值

添加原始特征分布的高斯噪声。高斯噪声的均值  和标准差

和标准差  是从原始特征

是从原始特征  计算得出的。因此,最终的抖动特征

计算得出的。因此,最终的抖动特征  可以表示为:

可以表示为:

其中, 和

和  是与输入目标特征具有相同形状的噪声向量,

是与输入目标特征具有相同形状的噪声向量, ,而

,而  。通过这种方式可以使特征在有限程度上波动,接近于原始分布。

。通过这种方式可以使特征在有限程度上波动,接近于原始分布。

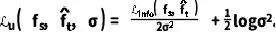

3、不确定性正则化

现有的方法通常采用InfoNCE损失函数,可以看作是一种batch分类损失函数(batch-wise classification loss)。其简单表述如下:

对于一个具有  个样本的batch,给定图文合成特征

个样本的batch,给定图文合成特征  和目标特征

和目标特征  ,InfoNCE损失同时最大化自相似性

,InfoNCE损失同时最大化自相似性  并最小化batch中与其他样本相似性

并最小化batch中与其他样本相似性

。可以看出,InfoNCE损失仅关注一对一的精细粒度匹配。在这项工作中旨在统一精细和粗粒度的匹配。由偶然不确定性(Aleatoric Uncertainty)[2]的启发,给定两种类型的特征

。可以看出,InfoNCE损失仅关注一对一的精细粒度匹配。在这项工作中旨在统一精细和粗粒度的匹配。由偶然不确定性(Aleatoric Uncertainty)[2]的启发,给定两种类型的特征  和

和  ,不确定性正则化可以定义如下:

,不确定性正则化可以定义如下:

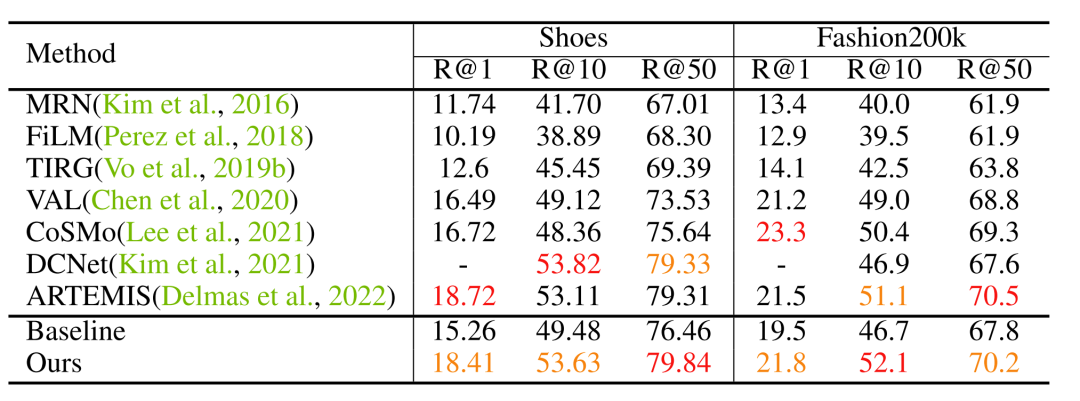

为了优化多粒度检索性能,采用了细粒度损失  和论文提出的不确定性正则化

和论文提出的不确定性正则化  的组合。因此,总损失如下:

的组合。因此,总损失如下:

三、实验

1、实验设置

论文在多个数据集上(FashionIQ、Fashion200k、Shoes)测试了方法的准确性,提升了召回率。代码已经公开在github上。

2、实验结果

展示了一些论文结果,更多的实验结果和消融实验请参考论文。

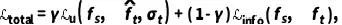

在FashionIQ上的结果

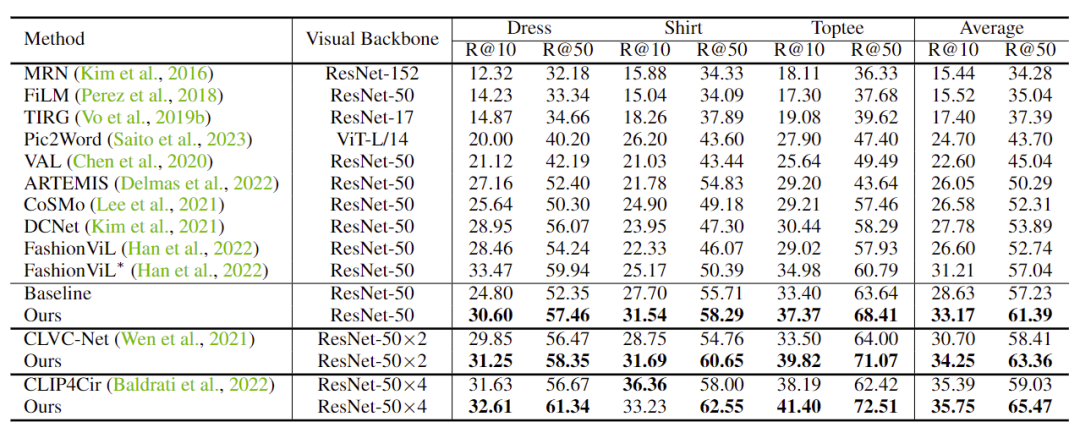

在Fashion200k和Shoes上的结果

四、总结

总的来说,该论文通过多粒度不确定性正则化的角度提出了一种新颖的通过文本反馈进行组合图像检索的方法。该方法通过不确定性建模和正则化同时对粗粒度和精细粒度的检索进行建模,从而解决了现实世界图像检索中的训练和测试不一致性问题。该方法生成抖动特征以模拟不确定范围,并根据波动范围自适应地调整权重。与现有方法相比,所提出的方法在三个公共数据集上显著提高了召回率。论文还讨论了该方法在现实场景中的潜在应用以及其对集成数据集的可扩展性。总体而言,所提出的方法为通过文本反馈进行组合图像检索面临的挑战提供了有希望的解决方案。

-

建模

+关注

关注

1文章

314浏览量

61015 -

模型

+关注

关注

1文章

3406浏览量

49457 -

图像检索

+关注

关注

0文章

28浏览量

8068 -

检索系统

+关注

关注

0文章

8浏览量

6460

原文标题:ICLR 2024 清华/新国大/澳门大学提出一模通吃的多粒度图文组合检索MUG:通过不确定性建模,两行代码完成部署

文章出处:【微信号:CVer,微信公众号:CVer】欢迎添加关注!文章转载请注明出处。

发布评论请先 登录

相关推荐

如何创造可信任的机器学习模型?先要理解不确定性

E8364C PNA的不确定性和跟踪是什么?

是否可以使用全双端口校准中的S11不确定性来覆盖单端口校准的不确定性?

N5531S TRFL不确定性

435B-K05输出不确定性

5G网络架构的不确定性及其对承载网的影响

连续值信息系统的不确定性度量

如何用不确定性解决模型问题

针对自闭症辅助的不确定性联合组稀疏建模方法

ICLR 2024 清华/新国大/澳门大学提出一模通吃的多粒度图文组合检索MUG:通过不确定性建模,两行代码完成部署

ICLR 2024 清华/新国大/澳门大学提出一模通吃的多粒度图文组合检索MUG:通过不确定性建模,两行代码完成部署

评论