在开源开发者圈子来看,2023 年是大模型 LLM 年、生成式 AI GenAI 年,LLM 领域大放异彩。

LLM 是利用深度学习和大数据训练的人工智能系统,专门设计来理解、生成和回应自然语言。这些模型通过分析大量的文本数据来学习语言的结构和用法,从而能够执行各种语言相关任务。

本篇将为大家介绍一下 LLM 相关的工具和平台。

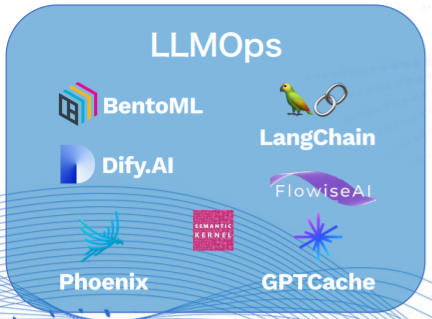

LLMOps

LLMOps 平台专注于提供大模型的部署、运维和优化服务,旨在帮助企业和开发者更高效地管理和使用这些先进的 AI 模型,快速完成从模型到应用的跨越,如 Dify.AI 、LangChain等。

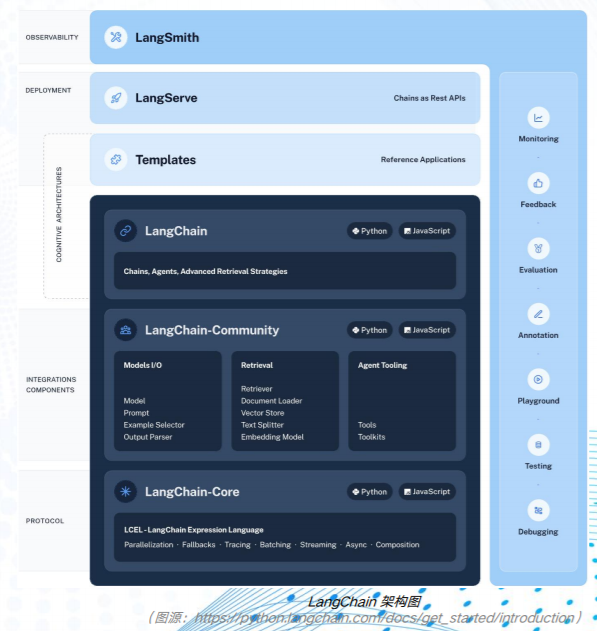

开源框架 LangChain 是一个帮助开发者使用 LLM 创建应用的开源框架,它可以将 LLM 与外部数据源进行连接,并允许与 LLM进行交互。LangChain 于 2022 年 10 月作为开源项目推出,并于2023 年 4 月注册成立公司,累计获得超过 3000 万美元的投资,估值达到了 2 亿美元。在 GitHub 上,LangChain 已经获得了超过 7 万个 Star 和超过 2000 名贡献者。

大模型聚合平台

大模型聚合平台主要用于整合和管理多个大型机器学习模型,在聚合平台之上,衍生出 MaaS(Model-as-a- Service,大模型即服务)的服务模式——通过提供统一的接口和框架,以更高效地部署、运行和优化这些模型,Hugging Face、Replicate 以及 Gitee AI 均为 MaaS 平台。

Gitee AI 是开源中国旗下的 MaaS 平台,提供模型、数据集,以及应用托管能力,同时接入了丰富的国产算力平台,为开发者提供了更高效、实惠的微调方案,降低使用门槛,目前已进入内测阶段。

开发工具

其它开发相关的 LLM 工具,如云原生构建多模态AI应用的工具 Jina,嵌入式数据库 txtai 等。

比较有代表性的 LLM 开发工具有:

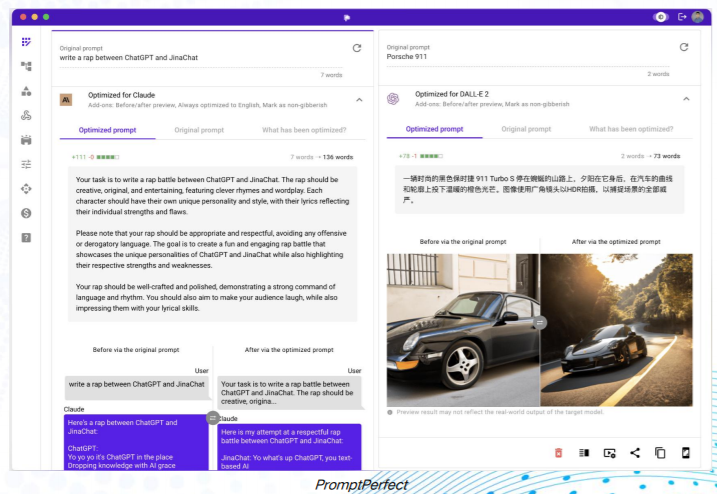

PromptPerfect:帮助用户极致优化给大模型的提示词(prompt),使得对大语言模型提问时,可以获得更理想的输出。

txtai:用于语义搜索、LLM 编排和语言模型工作流的一体化嵌入数据库,可以使用SQL、对象存储、主题建模、图形分析和多模态索引进行矢量搜索。

imgcook:专注以 Sketch、PSD、静态图片等形式的视觉稿作为输入,通过智能化技术一键生成可维护的前端代码,包含视图代码、数据字段绑定、组件代码、部分业务逻辑代码。

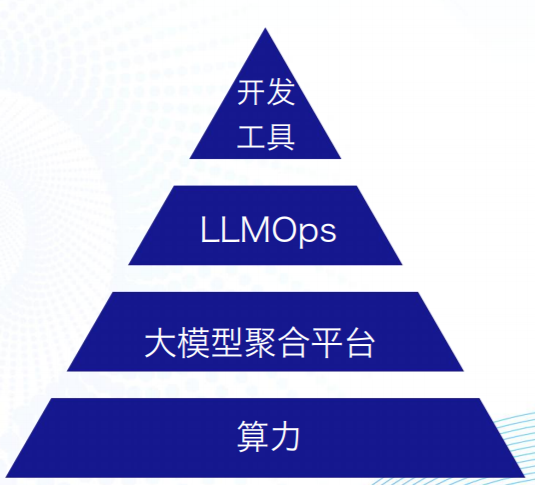

另一个视角来看,在大模型繁荣发展的背后,少不了工具和平台的发力,如 LLMOps 平台、大模型聚合平台以及相关的开发工具,此外还有它们所依赖的最重要的资源——算力。在这些工具、平台和资源的有力支撑下,大模型才得以一步一个台阶,引领全球开发者步入一个技术新时代。

以上内容出自《2023 LLM 技术报告》,此报告浓墨重彩地梳理了 2023 年 LLM 的技术行情。报告整体围绕 LLM Tech Map 梳理逻辑来展开,从基础设施、大模型、Agent、AI 编程、工具和平台,以及算力几个方面,为开发者整理了当前 LLM 中最为热门和硬核的技术领域以及相关的软件产品和开源项目。

-

深度学习

+关注

关注

73文章

5503浏览量

121162 -

大模型

+关注

关注

2文章

2450浏览量

2706 -

LLM

+关注

关注

0文章

288浏览量

335

原文标题:2023 LLM技术报告—— LLM的工具和平台

文章出处:【微信号:OSC开源社区,微信公众号:OSC开源社区】欢迎添加关注!文章转载请注明出处。

发布评论请先 登录

相关推荐

什么是LLM?LLM在自然语言处理中的应用

如何训练自己的LLM模型

LLM技术对人工智能发展的影响

LLM和传统机器学习的区别

LLM大模型推理加速的关键技术

LLM预训练的基本概念、基本原理和主要优势

大模型LLM与ChatGPT的技术原理

llm模型有哪些格式

LLM模型和LMM模型的区别

llm模型和chatGPT的区别

LLM模型的应用领域

什么是LLM?LLM的工作原理和结构

大语言模型(LLM)快速理解

100%在树莓派上执行的LLM项目

2023 LLM技术报告—— LLM的工具和平台

2023 LLM技术报告—— LLM的工具和平台

评论