电子发烧友网报道(文/李弯弯)英伟达遇到劲敌了?近日,Groq芯片计算速度超过英伟达GPU的消息刷屏。Groq是一家成立于2016年的AI创企,该公司近日开放了自家产品的免费试用,相比其他AI聊天机器人,Groq闪电般的响应速度迅速引爆朋友圈,经网友测试,Groq每秒生成速度接近500 tok/s,碾压GPT-4的40 tok/s。

而这样的速度背后,源于Groq自研了一种名为张量流处理器(TSP)的新型处理单元,Groq将其命名为语言处理单元,即LPU,它的工作原理与GPU截然不同。

Groq芯片跑大模型的速度有多快

Groq芯片跑大模型最突出的特点,便是快。有网友震惊地说:“它回复的速度比我眨眼还快。”在传统生成AI中,等待是很平常的事,经常是字符一个个往外蹦,回答完需要挺长时间。而有网友称,在Groq近日开放的云服务体验平台上,你可以看到,当模型收到提示后,几乎能够立即生成答案。

电子邮件初创企业OthersideAI的首席执行官兼联合创始人马特·舒默在演示中亲自体验了Groq的强大功能。他称赞Groq快如闪电,能够在不到一秒钟的时间内生成数百个单词的事实性、引用性答案。更令人惊讶的是,它超过3/4的时间用于搜索信息,而生成答案的时间却短到只有几分之一秒。

需要说明的是,Groq并没有研发新模型,它只是一个模型启动器,主页上运行的是开源模型Mixtral 8x7B-32k和Llama 270B-4k。而驱动模型的硬件便是Groq自研的一种名为张量流处理器(TSP)的新型处理单元,Groq将其命名为语言处理单元,即LPU(Language Processing Units),它的工作原理与GPU截然不同。

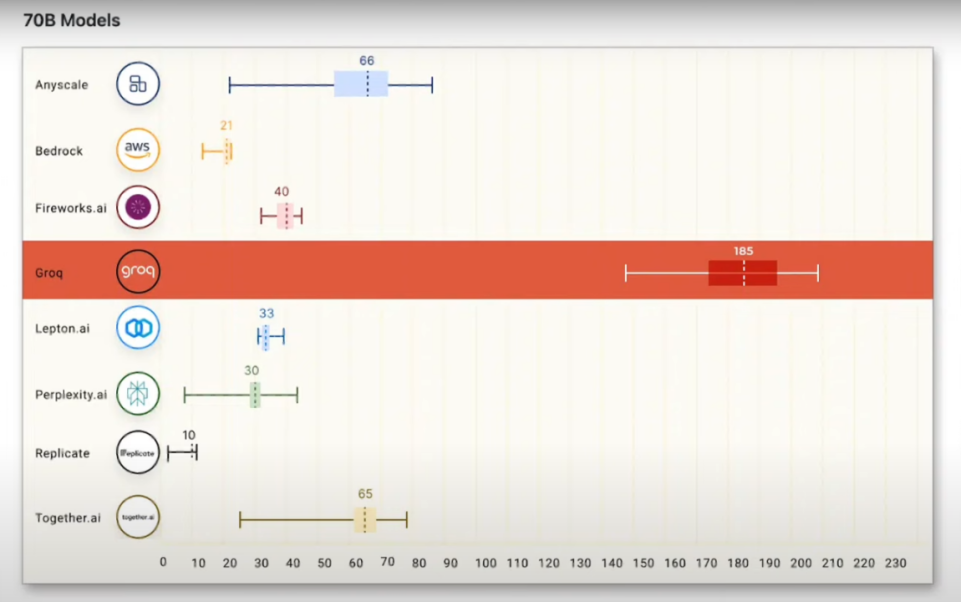

各种测试结果和网友的体验,都显示Groq LPU的计算速度相当快。根据2024年一月的测试结果,由Groq LPU驱动Meta Llama 2模型,推理性能遥遥领先,是顶级云计算供应商的18倍。有报道称,Groq LPU搭配Meta Llama 2 70B能在7分钟内就能生成与莎士比亚《哈姆雷特》相同数量的单词,比普通人的打字速度快75倍。

有网友测试同时用Gemini、GPT-4和Groq完成一个代码调试问题,结果,Groq的输出速度比Gemini快10倍,比GPT-4快18倍。

有从事人工智能开发的用户称赞,Groq是追求低延迟产品的“游戏规则改变者”。有用户认为,Groq的LPU可能成为英伟达A100和H100芯片的“高性能硬件”的有力替代品。不过,也有AI行业的专家表示,Groq的LPU从成本上来看并不具优势,目前并不能代替英伟达。

Groq 开发的LPU与GPU有何不同

Groq开发的LPU到底是个怎样的产品?据其官网介绍,LPU是一种专为AI推理所设计的芯片。驱动包括GPT等主流大模型的GPU,是一种为图形渲染而设计的并行处理器,有数百个内核。而LPU架构则与GPU使用的SIMD(单指令,多数据)不同,这种设计可以让芯片更有效地利用每个时钟周期,确保一致的延迟和吞吐量,也降低了复杂调度硬件的需求。

Groq的LPU推理引擎不是普通的处理单元;它是一个端到端系统,专为需要大量计算和连续处理的应用(如LLM)提供最快的推理而设计。通过消除外部内存瓶颈,LPU推理引擎的性能比传统GPU高出几个数量级。

根据与Groq关系密切的投资人k_zeroS分享,LPU的工作原理与GPU截然不同。它采用了时序指令集计算机(TemporalInstructionSetComputer)架构,这意味着它无需像使用高带宽存储器(HBM)的GPU那样频繁地从内存中加载数据。这一特点不仅有助于避免HBM短缺的问题,还能有效降低成本。

Groq创始人兼首席执行官Jonathan Ross此前在接受采访的时候就谈到,在大模型推理场景,Groq LPU芯片的速度比英伟达GPU快10倍,但价格和耗电量都仅为后者的十分之一。

Ross认为,对于在产品中使用人工智能的公司来说,推理成本正在成为一个问题,因为随着使用这些产品的客户数量增加,运行模型的成本也在迅速增加。与英伟达GPU相比,Groq LPU集群将为大模型推理提供更高的吞吐量、更低的延迟和更低的成本。

他强调,由于技术路径不同,Groq的LPU芯片不依赖于三星或SK海力士的HBM,也不依赖于台积电将外部HBM焊接到芯片上的CoWoS封装技术。它在供应方面比英伟达更充足,不会被台积电或者SK海力士等供应商卡脖子。

可以看到,Groq LPU芯片相当于是去掉了HBM,而只是依靠SRAM来计算。虽然这样计算速度确实相当惊艳,然而其更低成本的问题却遭到质疑。

有AI专家表示,Groq芯片的实际成本并不低,如人工智能专家贾扬清分析称,因为Groq小的可怜的内存容量(230MB),在运行Llama-270b模型时,需要305张Groq卡才足够,而用H100则只需要8张卡。从目前的价格来看,这意味着在同等吞吐量下,Groq的硬件成本是H100的40倍,能耗成本是10倍。

当然也有SRAM行业的专家非常看好这种架构模式,他认为,贾扬清对Groq成本的估算不是很对,因为没有考虑到Groq的per token cost明显低于GPGPU。

可以看到,作为一种新的架构模式,Groq LPU当前必然还面临一些潜在问题,然而它的出现,也让人们看到GPU之外的可能路径。

Groq LPU芯片未来能否肩负起运行大模型的重任,或许再等等,就能看到明确答案。事实上,在去年年底的采访中,Ross就表示,考虑到GPU的短缺和高昂的成本,他相信Groq未来的发展潜力。他说到:“在未来12个月内,我们可以部署10万个LPU,在24个月内,我们可以部署100万个LPU。”

写在最后

过去一年多时间,全球众多科技公司都在研发大模型,今年将会是大模型落地部署的重要一年,而如众多大模型的训练和推理却依赖英伟达的GPU。业界亟需除英伟达GPU之外的芯片,能够用于大模型的部署推理,Groq的LPU芯片可以说是带来了新的探索方向。

虽然Groq公司对自己的LPU芯片在性能和成本上都自信满满,然而业界对于其成本问题还是有所质疑。如果今年LPU芯片能够如规划那样进行较大规模的部署,或许就能一定程度证明LPU芯片在成本上也在众多用户所能接受的范围之内。

-

gpu

+关注

关注

28文章

4754浏览量

129078 -

英伟达

+关注

关注

22文章

3800浏览量

91351 -

Groq

+关注

关注

0文章

9浏览量

82

发布评论请先 登录

相关推荐

挑战英伟达:聚焦本土GPU领军企业崛起

ARM进军GPU领域,挑战英伟达与英特尔

英伟达将全面转向开源GPU内核模块

英伟达GPU新品规划与HBM市场展望

进一步解读英伟达 Blackwell 架构、NVlink及GB200 超级芯片

英伟达、AMD、英特尔GPU产品及优势汇总

英伟达发布新一代AI芯片架构Blackwell GPU

英伟达擅用版权作品遭起诉 AI训练数据和版权的矛盾凸显

英伟达要小心了!爆火的Groq芯片能翻盘吗?AI推理速度「吊打」英伟达?

刷屏的Groq芯片,速度远超英伟达GPU!成本却遭质疑

刷屏的Groq芯片,速度远超英伟达GPU!成本却遭质疑

评论