电子发烧友网报道(文/周凯扬)在Sora把AI生成领域的视线全部吸引过去的这段时间里,谷歌却依然在竭尽全力推进新的生成模型发展。除了上周发布的下一代Gemini 1.5外,谷歌也在近日推出了一系列基于Gemini打造的开源模型Gemma。

谷歌加入AI模型开源阵营,Gemma横空出世

根据谷歌的介绍,Gemma是由谷歌DeepMind以及其他团队开发,由Gemini启发并采用了相同的研究与技术的轻量级模型。与之一起发布的还有全新的响应式生成AI工具包,为利用Gemma创造更安全的AI应用提供关键工具和指导。

从参数大小上来看,Gemma分为20亿参数(Gemma 2B)和70亿(Gemma 7B)参数两个版本,且每个版本又有基础版(预训练)和指令调整版两个变体。其中70亿参数的版本适合消费级的GPU和TPU开发,而20亿参数的版本可以用于CPU和端侧应用上。

在预训练数据上,Gemma 2B和7B分别采用了2T和6T的Token进行训练,数据来源是以英文为主的网络文档、数学计算和代码。需要注意的是,尽管其背后所采用的技术与Gemini类似,但这些模型并不属于多模态模型,也并不适合用于追求极致的多语言任务性能。

在训练硬件上,谷歌采用了自研的TPUv5e,其中Gemma 7B用到了4096块TPUv5e进行训练,Gemma 2B用到了512块TPUv5e进行训练。

开源LLM混战,Gemma 7B超越Llama-2 13B?

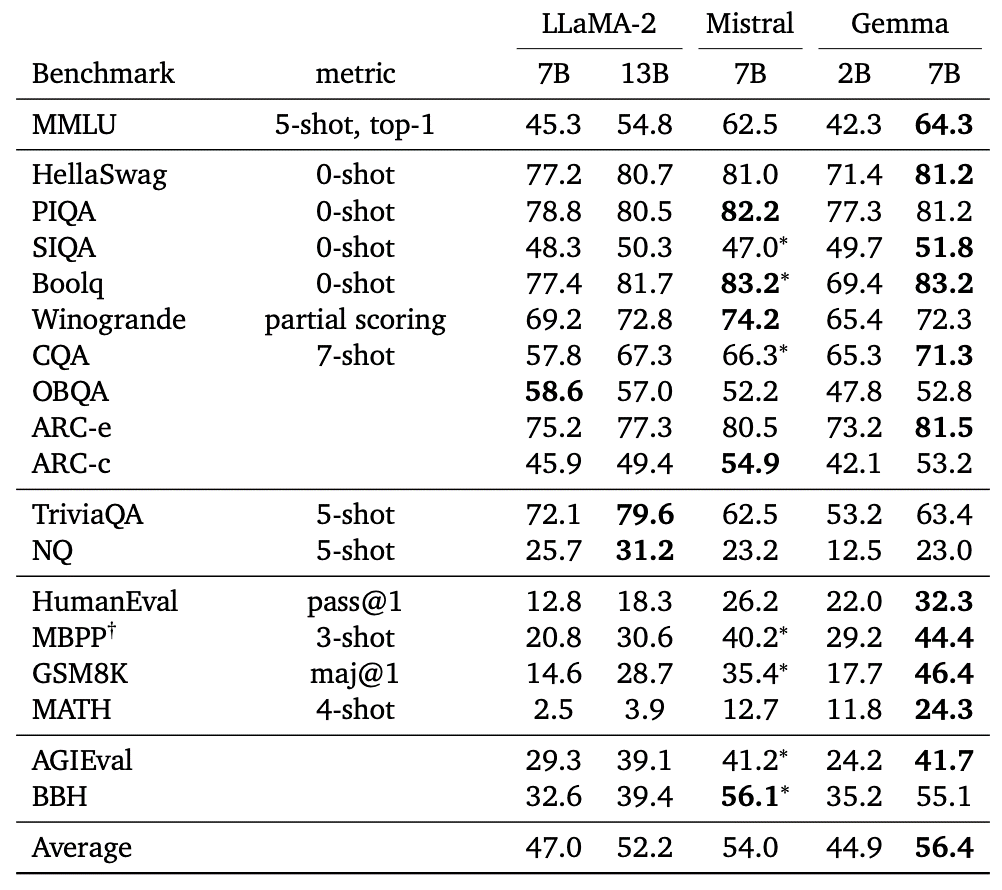

根据谷歌官方提供的数据,与Meta的Llama-2相比,Gemma 7B在多个项目上展现出了优势,比如大规模多任务语言理解(MMLU)、GSM8K和Math计算和HumanEval Python代码生成等应用上,都超过了Llama-2 7B,甚至不少超过了Llama-2 13B。

开源模型文本任务性能对比 / 谷歌

谷歌表示,与同等体量的开源模型对比,比如LLaMA-2和Mistral等,18项文字相关的任务中,Gemma能够做到在11项任务中性能胜出,且平均性能得分占优。

不过Gemma也并不是完全超越了Llama-2,从Huggingface给出的平均得分来看,Gemma 7B超过了同级别的Llama 2 7B,但还是低于LLama 2 70B Chat,不过考虑到这两者之间的参数差异,也印证了Gemma 7B的强大。至于Gemma 2B,与同规格的其他优秀开源LLM相比,比如PHI-2(2.7B),也不存在优势。

作为一个轻量级的模型,Gemma也对跨设备兼容性做了优化,可以在笔记本、PC、IoT设备、智能手机和云端运行。谷歌也与英伟达达成合作,Gemma针对英伟达的GPU硬件进行了优化,无论是云端的AI GPU还是桌面端的RTX AI PC,都能享受Gemma带来的性能。

写在最后

尽管Gemma是谷歌首个大型的开源LLM,但这早已经不是谷歌对开源AI社区做出的首个贡献了,诸如Transformers, TensorFlow, BERT, T5, JAX, AlphaFold和AlphaCode等,可以说当前AI能够有如此繁荣的开发生态,谷歌做出了不少贡献。无疑Gemma的出现,也会给AI开发生态带来新的选择。

-

谷歌

+关注

关注

27文章

6161浏览量

105285 -

AI

+关注

关注

87文章

30698浏览量

268851 -

算力

+关注

关注

1文章

963浏览量

14787 -

大模型

+关注

关注

2文章

2417浏览量

2630

发布评论请先 登录

相关推荐

Meta重磅发布Llama 3.3 70B:开源AI模型的新里程碑

谷歌开源70亿参数大语言模型,全方位超越Meta Llama-2?

谷歌开源70亿参数大语言模型,全方位超越Meta Llama-2?

评论