继ChatGPT后,又一生成式AI横空出世,人工智能一年一阶段的发展,给相关元器件带来了哪些影响?

与2023年相似,就在今年的同一时间,生成式AI再次横空出世。

2月16日,OpenAI发布首个文生视频模型“Sora”。根据OpenAI官网介绍,使用Sora可以用文字指令生成长达1分钟的高清视频。

人工智能一年一阶段的迭代,也让大家看到了正在飞速发展的算力及对其需求的攀升。根据中国信息通信研究院发布的《中国算力发展指数白皮书》显示,近年来全球算力规模保持高速稳定增长态势,全球计算设备算力总规模达到906EFlops,增速达到47%。

AI模型对算力需求更甚。根据OpenAI测算数据,2012年以来的全球头部AI模型训练算力需求每3-4个月就翻一番,每年算力增长幅度高达10倍。

而服务器作为算力的支柱,算力需求的增长无疑是服务器的第一受益领域。

纵观我国服务器发展历史,目前服务器已经升级至AI服务器,AI服务器为专门用于AI计算的高性能服务器,该类服务器配备了强大的计算、存储和网路资源,适用于大规模数据处理和复杂模型训练。

由于需要足够的计算资源,服务器的处理器也随之从CPU逐渐演变至CPU+架构,即CPU 仍作 为 CPU的数据处理主要模块,同时植入并行式计算加速部件,如 ASIC、FPGA、GPU 等, 负责人工智能计算负载加速。其中,以GPU为代表的AI算力芯片大幅度提升了服务器算力,进而满足了人工智能的发展需求,驱动ChatGPT、Sora等大模型的发展。此前根据记者采访了解,相对CPU,GPU所需电源的数量和功率均是CPU的两倍以上。

同时,芯片、电感变压器等配套元器件也是AI服务器的技术创新和性能优化的重要方面。因此,元器件如何面对服务器大功率的发展、更好解决服务器散热和损耗的难题是工程师们和整机企业未来的关键挑战。

在此趋势下,新技术、新产品也应运而生。例如芯片电感。麦捷科技此前在投资者互动平台表示,由于芯片电感的性能更加符合算力领域的应用需求,现已被越来越多地运用于AI服务器等场景。

据了解,铂科新材生产的金属芯片电感属于全球首创,并于2021年开始小批量量产。芯片电感的损耗接近于铁氧体,且体积最大可减少70%,能大幅节约空间。

总而言之,AI的发展,带动了基础设施扩容,使得相关产业链如服务器等迎来新的市场空间。近期,TrendForce集邦咨询预期,2024年全球AI服务器(包含AI Training及AI Inference)将超过160万台,年成长率达40%。

因此,服务器还有哪些市场发展空间?服务器相关产业链如何完善和升级也成为元器件企业需要关注的议题。

4月27日,Big-Bit资讯将在深圳举办2024’中国电子热点解决方案创新峰会。峰会将邀请业内专家学者分享智能网联汽车、大功率锂电BMS、大功率数字电源等当下热门领域技术发展趋势,还有Big-Bit产业研究室代表分享独家市场分析报告,帮助广大行业从业者了解市场发展趋势。

事不宜迟,感兴趣的行业人士请尽快锁定名额,积极报名参会!

审核编辑 黄宇

-

芯片

+关注

关注

455文章

50714浏览量

423147 -

服务器

+关注

关注

12文章

9123浏览量

85324 -

数字电源

+关注

关注

28文章

513浏览量

109299 -

生成式AI

+关注

关注

0文章

502浏览量

471 -

Sora

+关注

关注

0文章

81浏览量

195

发布评论请先 登录

相关推荐

弹性云服务器怎么样?好用吗?

独立服务器与云服务器的区别

云服务器和虚拟服务器的区别是什么

鸿海强化北美AI服务器产能,深化产业链布局

RISC-V在服务器方面应用与发展前景

RISC-V在服务器方面的应用与发展前景如何?刚毕业的学生才开始学来的及吗?

linux服务器和windows服务器

openai sora如何使用?Sora 使用指南:快速上手

成都汇阳投资关于Sora 横空出世,AI 产业链风云再起!

鸿海工业富联与英伟达合作多年,覆盖服务器全产业链

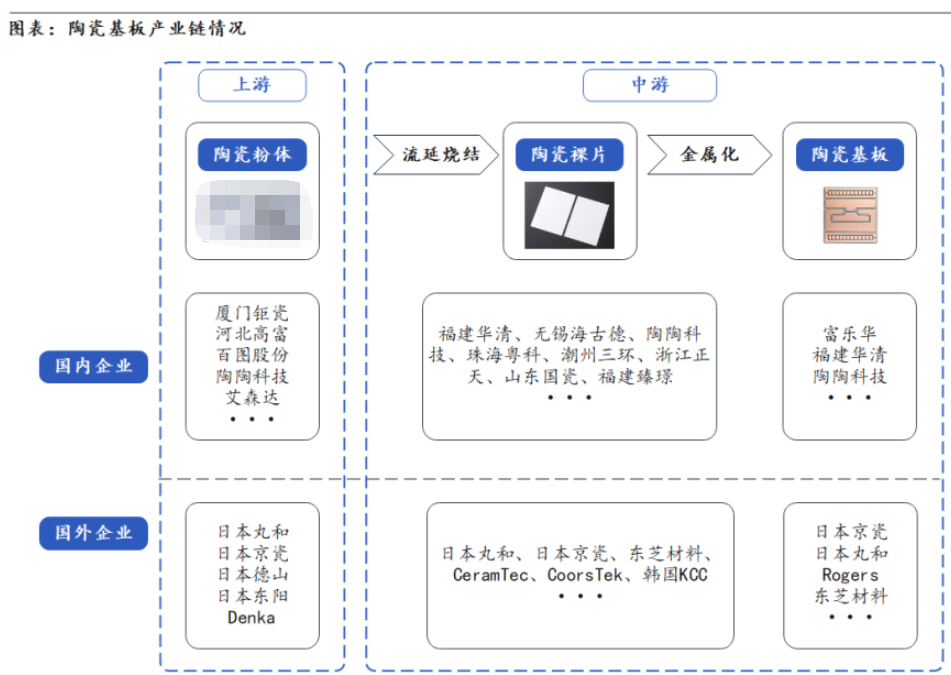

陶瓷基板产业链分布及工艺制作流程

Sora出世 服务器产业链受益极大!

Sora出世 服务器产业链受益极大!

评论