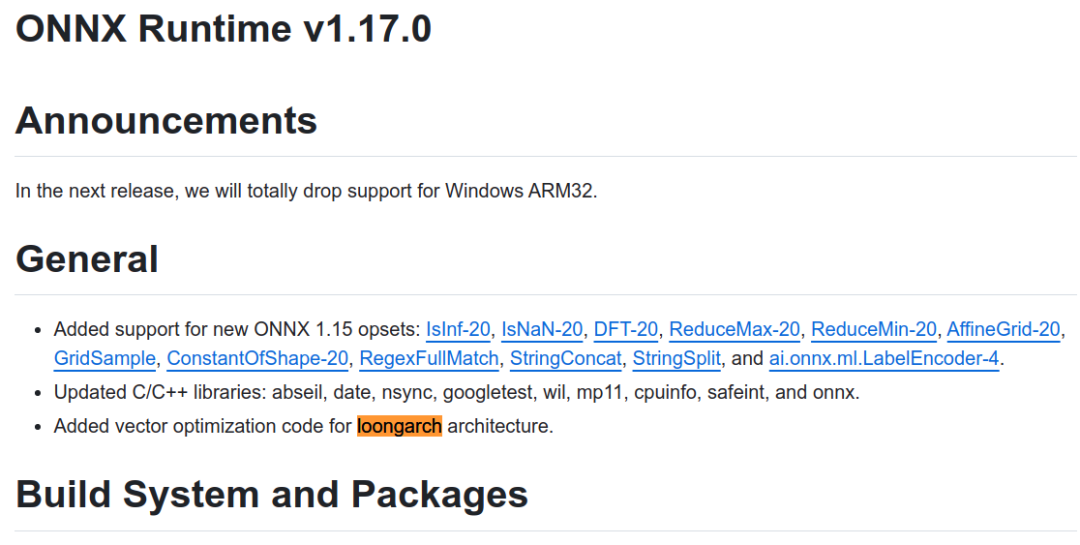

近日,知名AI推理框架开源社区ONNX Runtime正式发布支持龙架构的版本1.17.0。今后,用户可以直接使用ONNX Runtime开源社区发布的版本在龙芯平台完成AI推理类应用的开发和部署,标志着龙架构软件生态得到进一步完善。

ONNX Runtime(ORT)是近年来兴起的AI推理框架软件,被大量AI应用作为基础AI推理引擎。ORT可支持PyTorch、Tensorflow、TFLite等多种格式的模型输入,以及CPU、GPU、IoT、NPU、FPGA等多样化算力后端。

在ONNX Runtime 社区1.17.0版本的研制过程中,龙芯中科技术团队与社区保持紧密合作,期间向ONNX Runtime社区代码仓库提交了7697行代码,对矩阵乘法、卷积、转置等核心算子进行深度向量优化。在社区支持下,龙架构优化代码通过了检视、测试验证等质量保证流程,ONNX Runtime社区自1.17.0版本起正式实现对龙架构的原生支持。

未来,龙芯中科将继续与AI领域的国际开源软件社区携手合作,助力AI领域的生态发展和技术创新,为用户带来更优产品,实现更大价值。

审核编辑:刘清

-

FPGA

+关注

关注

1625文章

21663浏览量

601663 -

龙芯中科

+关注

关注

0文章

260浏览量

7603 -

NPU

+关注

关注

2文章

269浏览量

18536

原文标题:AI推理框架软件ONNX Runtime正式支持龙架构

文章出处:【微信号:gh_53fadbdbd4d4,微信公众号:龙芯中科】欢迎添加关注!文章转载请注明出处。

发布评论请先 登录

相关推荐

基于迅为RK3588开发板的AI图像识别方案

摩尔线程携手东华软件完成AI大模型推理测试与适配

STM CUBE AI错误导入onnx模型报错的原因?

进一步解读英伟达 Blackwell 架构、NVlink及GB200 超级芯片

将yolov5s的模型转成.onnx模型,进行cube-ai分析时报错的原因?

微软推出ONNX Runtime Web,利用WebGPU优化浏览器机器学习性能

Groq LPU崛起,AI芯片主战场从训练转向推理

通过新的ONNX导出器简化模型导出流程

AI推理框架软件ONNX Runtime正式支持龙架构

AI推理框架软件ONNX Runtime正式支持龙架构

评论