斯坦福大学此前提出的FlashAttention算法,能够在BERT-large训练中节省15%,将GPT训练速度提高2/3。此后又提出FlashAttention V2,拥有了更好的并行性和工作分区,让计算提速200%,上下文长度扩展更任性!

Flash-Decoding不仅借鉴了FlashAttention的优点,同时可以显著加快推理过程中的注意力,使非常长的序列的生成速度提高8倍。也可以极大提高了encoding速度。

审核编辑:刘清

声明:本文内容及配图由入驻作者撰写或者入驻合作网站授权转载。文章观点仅代表作者本人,不代表电子发烧友网立场。文章及其配图仅供工程师学习之用,如有内容侵权或者其他违规问题,请联系本站处理。

举报投诉

-

斯坦福

+关注

关注

0文章

28浏览量

9229 -

GPT

+关注

关注

0文章

352浏览量

15342

原文标题:太强了!斯坦福继Flash Attention V1和V2又推出Flash Decoding

文章出处:【微信号:zenRRan,微信公众号:深度学习自然语言处理】欢迎添加关注!文章转载请注明出处。

发布评论请先 登录

相关推荐

斯坦福STANFORD FS725铷钟

斯坦福STANFORD FS725铷钟 SRS斯坦福FS725 10MHzRb频率标准 SRS斯坦福FS72510MHzRb频率标准FS725集成了一个铷振荡器(SRS模型PRS10),一个

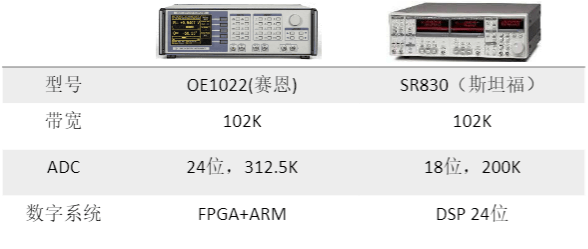

国产仪器崛起:斯坦福替代方案来了!

众所周知,斯坦福的东西一直以来,好用,贵,货期长动辄几个月,很苦恼 今天,他来了,他的替代来了 首先是最经典的型号斯坦福SR830,它的频率可以达到102.4 kHz ,18位的ADC,采样率可以

ESP32S2烧录时提示没有WIFI\\Flash\\PSRAM怎么解决?

Flash, No Embedded PSRAM, ADC and temperature sensor calibration in BLK2 of efuse V1

Crystal

发表于 06-14 07:45

斯坦福团队抄袭国产大模型,主要责任人失联

的广泛关注,也让大家对于开源大模型的规范使用更加担忧。 斯坦福Llama3V模型被证实抄袭 5月29日,斯坦福大学的一个AI团队在Github等平台发布了一款大模型,名为Llama3V

深度解读RoCE v2的核心技术原理

RoCE v2是一种专为实现以太网环境下低延迟、高吞吐量数据传输而设计的RDMA协议。相较于涉及多重处理层次的传统数据传输方式,RoCE v2实现了系统间的直接内存访问机制,最大限度地减少了CPU的参与和降低通信延迟。

发表于 04-29 10:32

•4733次阅读

斯坦福发布《2024 AI指数报告》

近日,斯坦福大学以人为本人工智能研究所(StanfordHAI)发布了《2024年人工智能指数报告》(ArtificialIntelligenceIndexReport2024)。据

Google Cloud推出基于Arm Neoverse V2定制Google Axion处理器

Arm Neoverse 平台已成为云服务提供商优化其从芯片到软件全栈的心仪之选。近日,Google Cloud 推出了基于 Arm Neoverse V2 打造的定制 Google Axion 处理器,面向通用计算和人工智能 (AI) 推理工作负载。

CMSIS-RTOS V1与V2的区别是什么?

最近的学习FreeRTOS,看到STM32CubeMX分别用CMSIS-RTOS V1,V2进行封装,请教CMSIS-RTOS V1与V2的有什么区别?如果用在产品项目,哪个版本合适?

发表于 04-11 06:06

Teledyne e2v宣布扩展其Flash™ CMOS图像传感器系列

Teledyne Technologies[纽交所代码:TDY]旗下公司、全球成像解决方案创新者Teledyne e2v宣布扩展其Flash™ CMOS图像传感器系列,推出Flash

大模型系列:Flash Attention V2整体运作流程

基于1.1中的思想,我们在V2中将原本的内外循环置换了位置(示意图就不画了,基本可以对比V1示意图想象出来)。我们直接来看V2的伪代码(如果对以下伪代码符号表示或解读有疑惑的朋友,最好先看一下

瑞萨Flash示例程序01版V1.20(SC版)发布说明

电子发烧友网站提供《瑞萨Flash示例程序01版V1.20(SC版)发布说明.pdf》资料免费下载

发表于 02-19 10:40

•0次下载

维修斯坦福SR560可编程滤波器烧了overload

近日某院校送修一台斯坦福可编程滤波器SR560,客户反馈仪器烧了 overload,对仪器进行初步检测,确定与客户描述故障一致。本期将为大家分享本维修案例。 下面就是斯坦福-SR560维修情况

LT8228从V1到V2是BUCK模式,从V2到V1是BOOST模式,请问这个模式是固定的吗?

看LT8228的示例,从V1到V2是BUCK模式,从V2到V1是BOOST模式,请问,这个模式是固定的吗?

假如我输入V1是48

发表于 01-05 07:10

斯坦福继Flash Attention V1和V2又推出Flash Decoding

斯坦福继Flash Attention V1和V2又推出Flash Decoding

评论