人工智能(AI)领域中的大模型(Large Model)逐渐成为研究的热点。大模型,顾名思义,是指拥有海量参数和高度复杂结构的深度学习模型。它的出现,不仅推动了AI技术的突破,更为各行各业带来了革命性的变化。

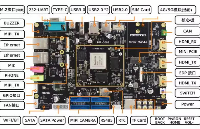

RK3588是瑞芯微推出的新一代旗舰级高端处理器,采用8nm工艺设计,搭载四核A76+四核A55的八核CPU和Arm高性能GPU,内置6T算力的NPU。能够高效地处理AI算法和模型,为大模型的运行提供了强大的硬件支持。

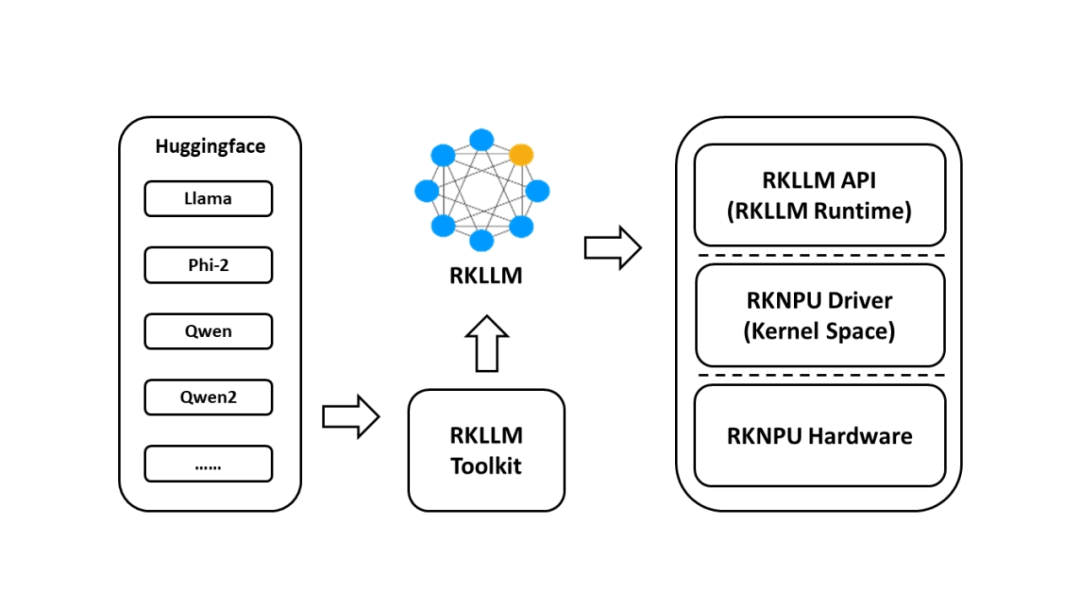

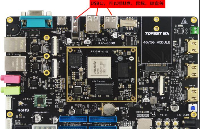

在北京迅为推出的搭载了RK3588处理器的iTOP-RK3588开发板上,使用RKLLM 工具套件支持在iTOP-RK3588平台上进行LLM(大型语言模型)模型的转换和部署。它与Hugging Face模型架构兼容(Hugging Face是广泛用于自然语言处理任务的模型架构。

目前,该系统支持以下模型:LLaMA、Qwen、Qwen2和Phi-2。支持量化技术,即使用w8a8(8位权重,8位激活)和w4a16(4位权重,16位激活)精度进行模型量化。这可以在目标平台上更高效地存储和计算模型,减小内存占用。

iTOP-RK3588开发板体验大模型

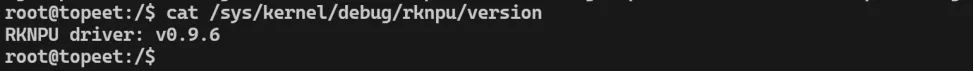

为了让用户更快速的体验RKLLM ,北京迅为已经对Linux内核源码中的NPU版本进行了升级,升级到了最新的0.9.6版本,具体如下所示:

默认以将RKLLM动态库集成在了Ubuntu和Debian系统中,用户可以直接拷贝转换完成的RKLLM大预言模型和推理程序进行测试。

审核编辑:刘清

-

处理器

+关注

关注

68文章

19286浏览量

229823 -

人工智能

+关注

关注

1791文章

47274浏览量

238479 -

GPU芯片

+关注

关注

1文章

303浏览量

5812 -

RK3588

+关注

关注

6文章

329浏览量

4338 -

大模型

+关注

关注

2文章

2448浏览量

2704

原文标题:更新 | 基于北京迅为iTOP-RK3588大语言模型部署测试

文章出处:【微信号:迅为电子,微信公众号:迅为电子】欢迎添加关注!文章转载请注明出处。

发布评论请先 登录

相关推荐

基于北京迅为iTOP-RK3588大语言模型部署测试

基于北京迅为iTOP-RK3588大语言模型部署测试

评论