人工智能 (AI) 和机器学习 (ML) 的加速发展既得益于基础硬件的不断改进,也离不开软件领域的发展成果。

以 Transformer 架构为例。2017 年,谷歌在一篇研究论文中[1]首次提出这一架构,它采用自注意力机制 (self-attention),使模型能够在进行预测时对不同的输入词元 (token) 赋予不同权重。利用自注意力机制,Transformer 模型能够捕捉数据中的远程依赖关系,因此在执行语言翻译、图像处理、文本生成和情感分析等任务时非常高效。例如,生成式预训练模型 (GPT) 就是当前流行训练有素的 Transformer 模型。这些模型已经在语音助手和 AI 图像生成工具中得到应用。

这之于感知器 (perceptron) 还是存在很大的差别。感知器是早期的一种神经网络,由单层人工神经元组成,可在模式识别任务(例如,识别手写数字)中做出二元决策。相较于卷积神经网络 (CNN),Transformer 架构已开始受到更多青睐。CNN 对数据架构方式会进行内置假设,它关注附近的关系,以及观察图像或视频中的对象移动或变化方式。

而 Transformer 架构则不会做出这些假设。相反地,它利用自注意力来理解序列的不同部分如何相互关联,而忽略其位置信息。得益于这种灵活性,基于 Transformer 的模型能够更加轻松地适应不同的任务。

这是如何实现的?Transformer 架构及其采用的注意力机制彻底改变了 AI 应用的格局,因为注意力机制具备的相关功能可以为诸多用例提供支持。文本(及语言)本身就是编码信息,图像、音频以及其他形式的串行数据同样如此。由于编码信息可以解读为一种语言,因此 Transformer 模型可以广泛应用于不同的用例中。这种适应性对于理解视频、填充图像的缺失部分或同时分析来自多个摄像头的数据或多模态数据来源(参见下文示例)等任务非常有效。

2020 年问世的 Vision Transformer (ViT) 是将 Transformer 架构成功应用于图像分类的最早一批神经网络技术[2]之一。ViT 将图像划分为多个图块,并使用自注意力机制对这些图块之间的交互进行建模。

自此,Transformer 模型被迅速应用于各类视觉任务中,例如:

图像分类

目标检测

语义分割

图像超分辨率

图像生成

视频分类

在硬件上优化模型

那么,硬件与这一切有什么关系呢?关系相当密切!而且硬件将是未来发展的关键因素。

GPU、TPU 或 NPU(甚至 CPU)都可以处理 Transformer 模型所需的密集矩阵运算和并行计算。同时,Transformer 架构可使更复杂的模型运行于资源更为受限的边缘设备上。

主要有以下三个原因:

与 CNN 或循环神经网络 (RNN) 相比,Transformer 架构从本质上而言更具可并行性。这一特性能更有效地利用硬件,从而可以在计算资源受限的边缘设备上部署基于 Transformer 的模型。

自注意力机制意味着通过较小的 Transformer 模型所带来的性能表现,可以媲美基于 CNN 或 RNN 的较大模型,从而降低边缘部署的算力与内存需求。

模型压缩技术(例如剪枝、量化、知识提炼和注意力稀疏)的提升可进一步缩小 Transformer 模型的大小,同时又不会造成性能或准确性的明显下降。

Transformer 架构提升

现在,不妨想象一下功能更强大的计算资源,毕竟这一切并不遥远。通过优化支持 Transformer 架构的硬件,创新者可充分发掘这些强大神经网络的全部潜力,并为跨不同领域和模式的 AI 应用带来全新的可能性。

例如,硬件性能和效率的提升可以:

加快 Transformer 模型的推理速度,从而提高响应能力,并改善用户体验。

部署更大的 Transformer 模型,从而在语言翻译、文本生成和图像处理等任务中获得更佳表现。

提高在一系列应用和部署场景中的边缘设备、云服务器或专用 AI 加速器中部署 Transformer 解决方案的可扩展性。

探索全新架构,并不断优化 Transformer 模型。这其中包括尝试不同的层配置、注意力机制和正则化技术,以进一步提高模型的性能和效率。

显著提高能效,鉴于某些模型的规模增长,这一点至关重要。

试想一下,当你打开手机或智能眼镜上[3]的某个视觉应用,它可以识别某个款式的衬衫,并从你的衣柜中推荐与之搭配的下半身穿着。或者由于算力提升而出现的新的图像生成功能[4]。

增加计算资源并不困难。集成子系统可提供经过验证的各种处理单元块,包括 CPU、NPU、互连、内存和其他组件。而软件工具可以根据处理器来优化 Transformer 模型,以获得性能和效率的最大化。

拥抱未来

通过硬件优化,Transformer 模型架构有望推动一些令人惊叹的新应用。借助优化的硬件配置以及集成子系统、互连和软件开发,无论是更快的推理速度,为更大的模型提供更好的性能,还是更出色的可扩展性等等,这一切都将成为可能。这条通往创新和探索的全新旅程,正在蓬勃发展,引领我们走向更远的未来。

审核编辑:刘清

-

神经网络

+关注

关注

42文章

4789浏览量

101527 -

人工智能

+关注

关注

1799文章

48047浏览量

241944 -

机器学习

+关注

关注

66文章

8459浏览量

133370 -

AI加速器

+关注

关注

1文章

69浏览量

8747

原文标题:大咖观点 | 通过 Transformer 架构赋能新一代边缘 AI 应用

文章出处:【微信号:Arm社区,微信公众号:Arm社区】欢迎添加关注!文章转载请注明出处。

发布评论请先 登录

相关推荐

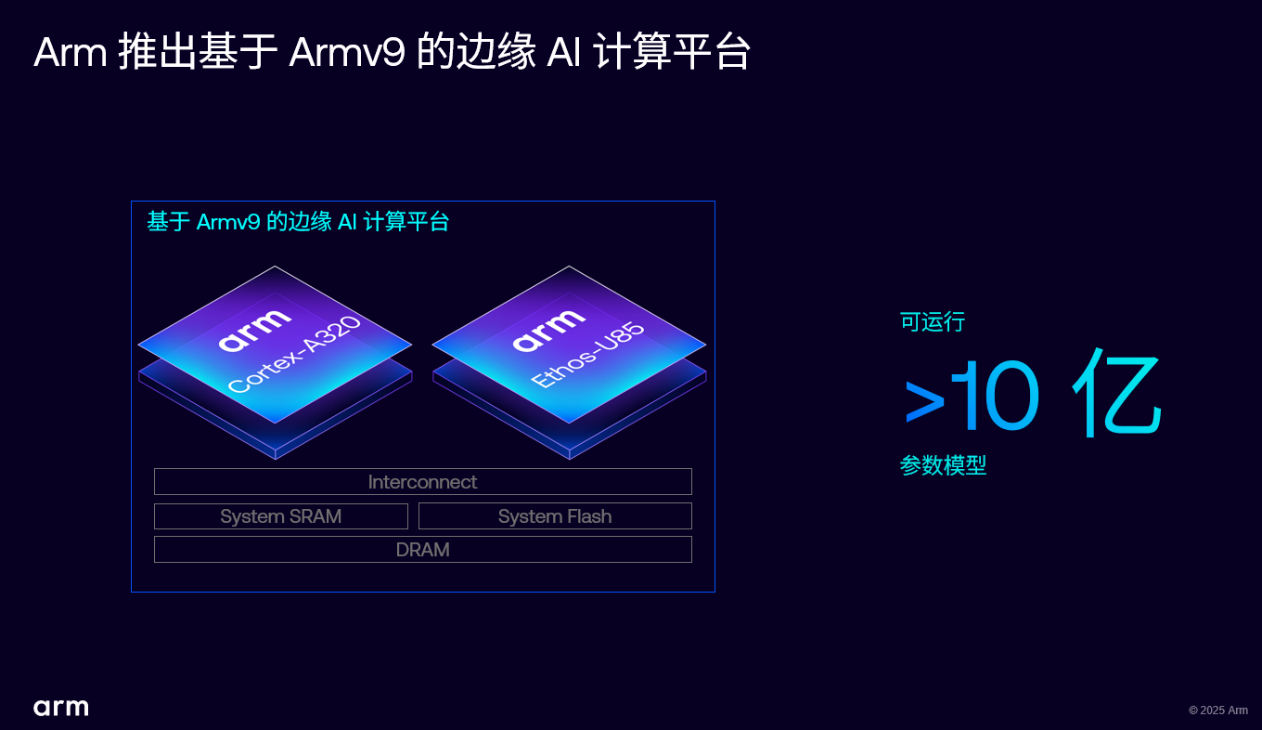

Arm 推出 Armv9 边缘 AI 计算平台,以超高能效与先进 AI 能力赋能物联网革新

华为发布新一代站点能源架构及AI数据中心建设原则

AI赋能边缘网关:开启智能时代的新蓝海

德州仪器发布新一代汽车芯片,赋能边缘AI与音频体验

虹软AI视觉赋能雷鸟V3 AI拍摄眼镜发布

芯原发布新一代Vitality架构GPU IP系列

意法半导体发布新一代微控制器,集成NPU加速器推动边缘AI

芯原推出新一代高性能Vitality架构GPU IP系列

蚂蚁数科发布AI赋能新一代数据标注产品

蚂蚁数科发布新一代融合AI风控引擎“AIR Engine”

让边缘AI实现性能和功耗的平衡,英飞凌新一代PSOC™ Edge MCU如何做到?

耐能推出最新的边缘AI服务器及内置耐能AI芯片的PC设备

英特尔AI产品助力其运行Meta新一代大语言模型Meta Llama 3

DPU技术赋能下一代AI算力基础设施

研扬携手英特尔,联合举办创AI百城行(武汉站):用OpenVINO™赋能AI于边缘计算平台

通过Transformer架构赋能新一代边缘AI应用

通过Transformer架构赋能新一代边缘AI应用

评论