自主机器开发是一个数据生成和收集、模型训练和部署的迭代过程,其特点是跨异构计算资源的复杂的多阶段、多容器工作流。

这其中涉及多个团队,每个团队都需要共享和异构计算。此外,团队希望将某些工作负载扩展到云中,这通常需要 DevOps 专业知识,还需要在本地维护其他工作负载。

到目前为止,还没有一个统一的平台可供开发者轻松提交所需计算的工作负载。

在最近的 GTC 大会上,NVIDIA 发布了OSMO,这是一个云原生工作流编排平台,它提供一个单一界面,用于跨异构共享计算环境调度和管理各种自主机器工作负载。这些工作负载包括:

合成数据生成 (SDG)

DNN 训练和验证

强化学习

基于 SIM 或真实数据的感知评估

跨异构共享计算部署复杂的工作流

借助 OSMO 统一计算资源调度,您可以轻松地在 Kubernetes 集群上部署和协调多阶段工作负载。这包括共享的异构多节点计算资源,例如 aarch64 和 x86-64,可确保跨不同架构的灵活性和兼容性。

您可以轻松设置基于 YAML 的多阶段、多节点任务,并简化从 SDG 、训练到模型验证的端到端开发流程。OSMO 还可以集成到现有的 CI/CD 工作流中,动态调度夜间回归测试、基准测试和模型验证等任务。

该服务还利用 OIDC 等开放标准进行身份验证,并支持通过一键式密钥轮换实现凭据和数据集安全性的最佳实践。在合规性方面,团队可以通过开发中的版本管理和追踪用于模型训练的所有数据。这一功能对于可重复性来说也非常有价值。

协调本地部署和云 SDG 工作负载

合成数据生成尤其受益于分布式环境,因为它通常从本地开始生成较小批量的数据,但当需要生成大量数据时,则需要利用云来进行规模的扩展。OSMO 使用弹性资源调配,在降低 SDG 等离线批量流程的成本方面发挥着关键作用,从而实现高效且经济的大规模数据生成。

高效运行 SIL 和 HIL 测试

OSMO 支持的另一个重要工作负载是软件在环 (SIL) 机器人测试,涉及仿真多传感器和多机器人场景,或是一系列测试场景。这些场景最适合易于访问计算资源的云环境。OSMO 能够跨分布式环境调度和管理工作负载,确保利用云资源的可扩展性和可访问性,从而高效地执行 SIL 测试。

另一方面,由于特定机器人或机器硬件的可用性,硬件在环 (HIL) 测试需要本地部署。

异构计算对于 HIL 测试来说是必需的,因为仿真和调试等工作负载需要 x86,并且需要在 aarch64 上运行针对测试的软件,以提供其他方式无法提供的准确性能和硬件功能。直接在目标硬件上运行 HIL 还可以减少对昂贵的仿真器的需求。

同时生成和训练基础模型

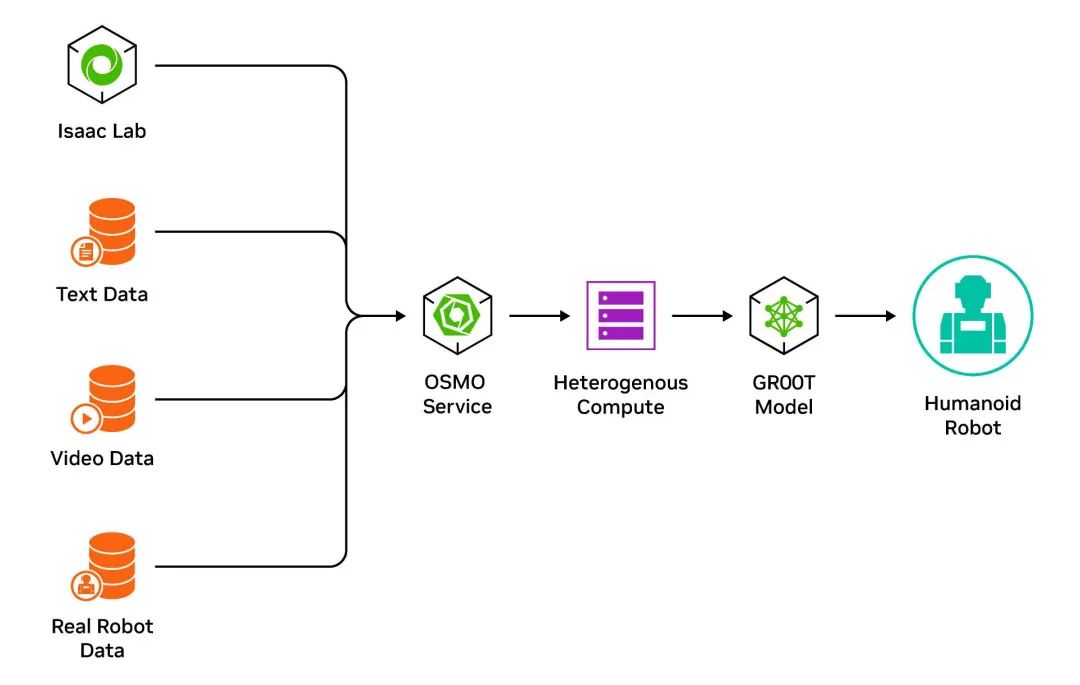

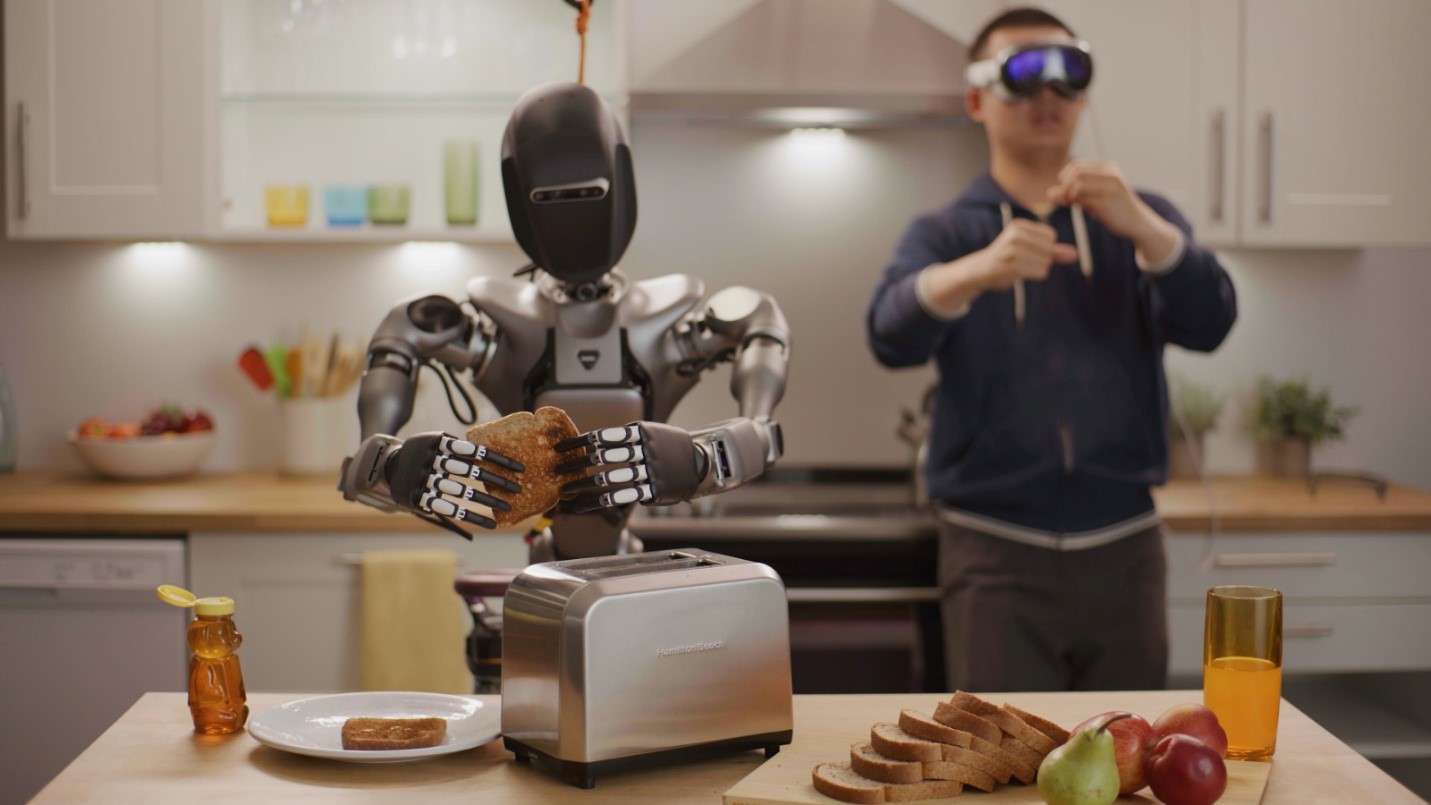

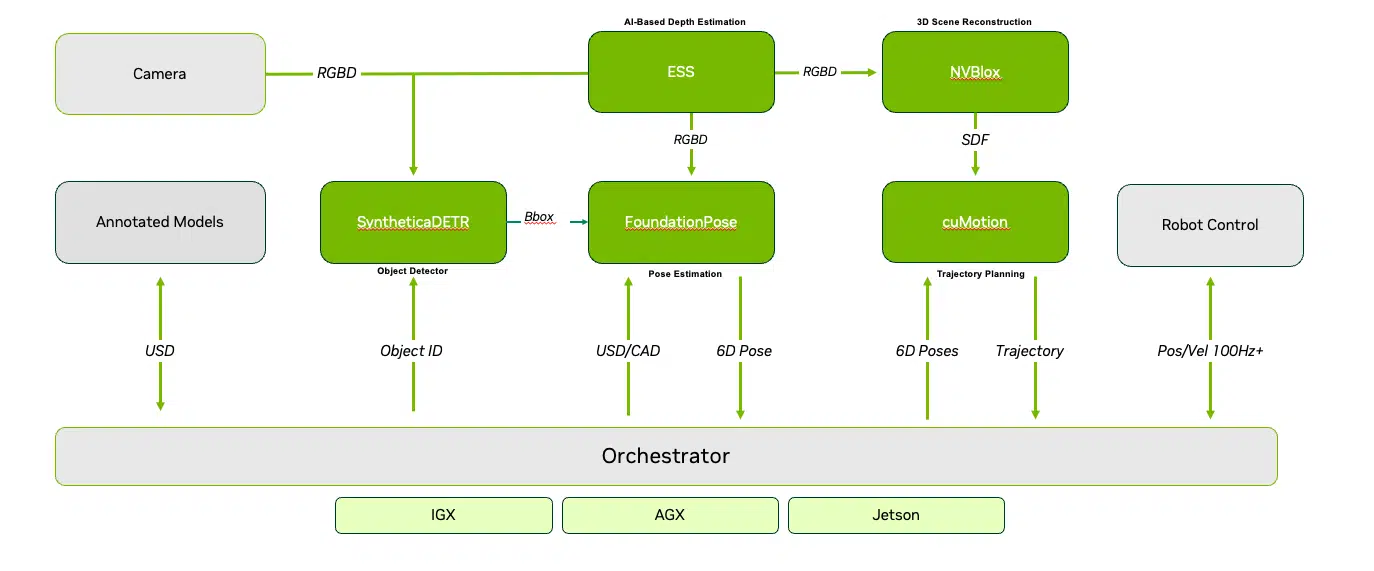

OSMO 支持GR00T这种基础模型,该模型需要在 NVIDIA DGX 上进行模型训练,同时在 OVX 上进行实时强化学习。该工作负载包括在一个循环中以迭代方式生成和训练模型。

OSMO 可以跨分布式环境管理和调度工作负载,从而实现 DGX 和 OVX 系统的无缝协调,从而实现高效的迭代模型开发。

图 1. NVIDIA OSMO 用于 GR00T 基础模型

跟踪数据沿袭

数据沿袭和管理对于模型审计和确保整个开发过程的可追溯性来说至关重要。借助 OSMO,您可以追溯从来源到经过训练的模型的数据沿袭,从而提供透明性和可靠性。

借助 OSMO,您还可以轻松地管理大型数据集和创建数据集,从而实现高效的数据组织和分类。这包括管理真实数据集、合成数据集或混合数据集的能力,从而灵活地控制用于模型训练和评估的数据集。

审核编辑:刘清

-

传感器

+关注

关注

2551文章

51090浏览量

753485 -

机器人

+关注

关注

211文章

28416浏览量

207063 -

NVIDIA

+关注

关注

14文章

4985浏览量

103036 -

仿真器

+关注

关注

14文章

1018浏览量

83739

原文标题:借助 NVIDIA OSMO 扩展 AI 机器人开发工作负载

文章出处:【微信号:NVIDIA-Enterprise,微信公众号:NVIDIA英伟达企业解决方案】欢迎添加关注!文章转载请注明出处。

发布评论请先 登录

相关推荐

NVIDIA通过加速AWS上的机器人仿真推进物理AI的发展

使用NVIDIA Jetson打造机器人导盲犬

NVIDIA发布全新AI和仿真工具以及工作流

利用NVIDIA Isaac平台构建、设计并部署机器人应用

NVIDIA提供一套服务、模型以及计算平台 加速人形机器人发展

NVIDIA 加速人形机器人发展

谷歌借助Gemini AI系统深化对机器人的训练

Al大模型机器人

NVIDIA发布几项新功能来帮助机器人专家和工程师打造智能机器人

NVIDIA Isaac 机器人平台利用最新的生成式 AI 和先进的仿真技术,加速 AI 机器人技术的发展

全球机器人开发领域采用NVIDIA 机器人开发和生产

NVIDIA Isaac机器人平台升级,加速AI机器人技术革新

NVIDIA Isaac平台为AI机器人开发提供支持

生成式AI通过NVIDIA Isaac平台提高机器人的智能化水平

借助NVIDIA OSMO扩展AI机器人开发工作负载

借助NVIDIA OSMO扩展AI机器人开发工作负载

评论