人工智能(AI)领域中的大模型(Large Model)逐渐成为研究的热点。大模型,顾名思义,是指拥有海量参数和高度复杂结构的深度学习模型。它的出现,不仅推动了AI技术的突破,更为各行各业带来了革命性的变化。

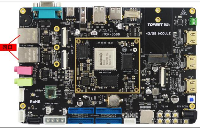

RK3588是瑞芯微推出的新一代旗舰级高端处理器,采用8nm工艺设计,搭载四核A76+四核A55的八核CPU和Arm高性能GPU,内置6T算力的NPU。能够高效地处理AI算法和模型,为大模型的运行提供了强大的硬件支持。

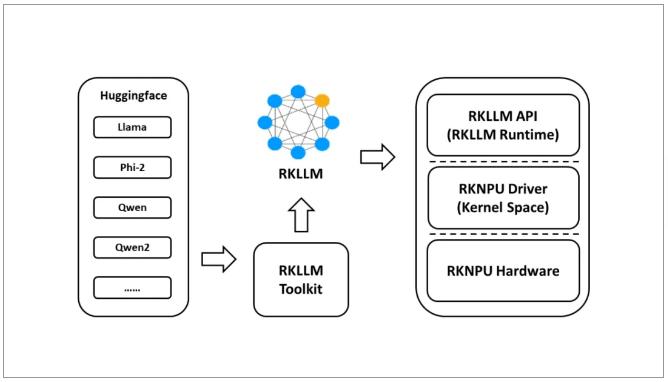

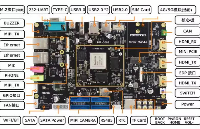

在北京迅为推出的搭载了RK3588处理器的iTOP-RK3588开发板上,使用RKLLM 工具套件支持在iTOP-RK3588平台上进行LLM(大型语言模型)模型的转换和部署。它与Hugging Face模型架构兼容(Hugging Face是广泛用于自然语言处理任务的模型架构。目前,该系统支持以下模型:LLaMA、Qwen、Qwen2和Phi-2。支持量化技术,即使用w8a8(8位权重,8位激活)和w4a16(4位权重,16位激活)精度进行模型量化。这可以在目标平台上更高效地存储和计算模型,减小内存占用。

iTOP-RK3588开发板体验大模型

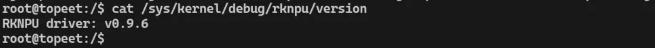

为了让用户更快速的体验RKLLM ,北京迅为已经对Linux内核源码中的NPU版本进行了升级,升级到了最新的0.9.6版本,具体如下所示:

默认以将RKLLM动态库集成在了Ubuntu和Debian系统中,用户可以直接拷贝转换完成的RKLLM大预言模型和推理程序进行测试。详细说明请见NPU手册中RKLLM模型转换和测试相关步骤。

《iTOP-RK3588开发板NPU使用手册》v1.1教程目录

第1章 你好!NPU

1.1 NPU的诞生!

1.2 初识RKNPU

第2章 准备RKNPU开发环境

2.1 开发环境

2.1 软件架构

2.2 SDK说明

第3章 让NPU跑起来

3.1 在Linux系统中使用NPU

3.1.1 设置交叉编译器

3.1.2 修改编译工具路径

3.1.3 更新RKNN模型

3.1.4 编译demo

3.1.5 开发板运行demo

3.2 在Android系统中使用NPU

3.2.1下载编译所需工具

3.2.2 修改编译工具路径

3.2.3 更新RKNN模型

3.2.4 编译demo

3.2.5 开发板运行demo

第4章 体验RKNN_DEMO

4.1 rknn_ssd_demo体验

4.2 rkn_api_demo体验

4.3 rknn_multiple_input_demo体验

第5章 模型转换

5.1 RKNN-Toolkit2 介绍

5.2 RKNN-Toolkit2环境搭建

5.2.1 安装Miniconda

5.2.2 创建RKNN虚拟环境

5.2.3 安装pycharm

5.2.4 配置pycharm

5.3 RKNN-Toolkit2工具的使用

5.3.1 模型运行在模拟器

5.3.2 模型运行在RK3588开发板

第6章 其他模型转换

6.1 使用tensorflow框架

6.2 使用caffe框架

6.3 使用tflite框架

6.4 使用onnx框架

6.5 使用darknet框架

6.6 使用pytorch框架

第 7章 使用RKNN-Toolkit-lite2

7.1 主要功能说明

7.2 环境搭建步骤

7.2.1 安装Miniconda

7.2.2 创建RKNN虚拟环境

7.2.3 安装RKNN-ToolkitLite 2软件包

7.2.4 安装opencv

7.3 运行测试程序

第8章 RKLLM大预言模型测试

8.1 RKLLM-Toolkit介绍

8.2 RKLLM-Toolkit环境搭建

8.2.1 安装Miniconda

8.2.2 创建RKLLM虚拟环境

8.3 大语言模型转换

8.4 推理程序编译

8.5 开发板运行测试

-

测试

+关注

关注

8文章

5125浏览量

126402 -

人工智能

+关注

关注

1791文章

46738浏览量

237310 -

RK3588

+关注

关注

6文章

308浏览量

4183

发布评论请先 登录

相关推荐

基于北京迅为iTOP-RK3588大语言模型部署测试

基于北京迅为iTOP-RK3588大语言模型部署测试

评论