NVIDIA 宣布使用 NVIDIA TensorRT-LLM 加速微软最新的 Phi-3 Mini 开源语言模型。TensorRT-LLM 是一个开源库,用于优化从 PC 到云端的 NVIDIA GPU 上运行的大语言模型推理。

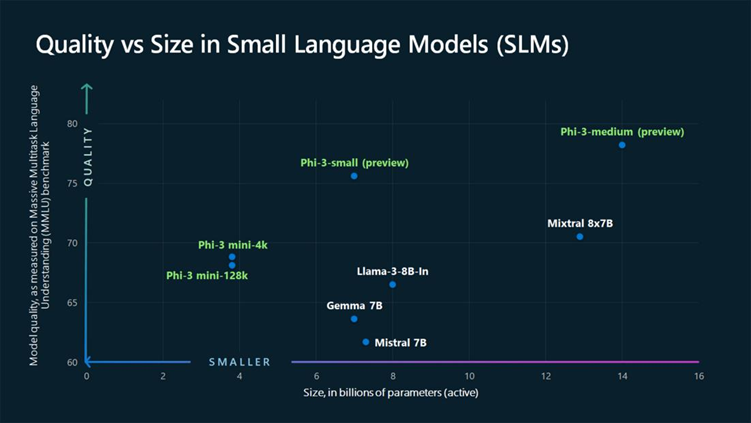

Phi-3 Mini 与 10 倍之于其大小的模型能力不相上下。不同于仅用于研究的 Phi-2,Phi-3 Mini 不仅可以用于研究,同时还可以用于多种商业用途。搭载 NVIDIA RTX GPU 的工作站或搭载 GeForce RTX GPU 的 PC 可以使用 Windows DirectML 或 TensorRT-LLM 在本地运行该模型。

该模型有 38 亿个参数,在 512 个 NVIDIA Tensor Core GPU 上使用 3.3 万亿个 token 训练而成,仅耗时七天时间。

Phi-3 Mini 有两个版本,一个版本支持 4K token,另一个版本支持 128K token,是同类模型中第一个支持超长上下文的模型。因此,开发者在向该模型提问时,可以使用 128,000 个 token(模型能够处理的最小语言单位),使模型能够做出更加符合现实的回答。

开发者可以在 ai.nvidia.com上试用带有 128K 上下文窗口的 Phi-3 Mini。该模型被打包成 NVIDIA NIM,这是一项带有标准应用编程接口的微服务,可以部署在任何位置。

在边缘高效运行

自主机器人和嵌入式设备开发者可以通过社区教程(如 Jetson AI Lab)学习创建和部署生成式 AI,并在 NVIDIA Jetson 上部署 Phi-3。

Phi-3 Mini 模型只有 38 亿个参数,非常小巧紧凑,可以在边缘设备上高效运行。参数就像内存中的旋钮,可在模型训练过程中进行精确的调整,使模型能够对输入的提示做出高度准确的响应。

Phi-3 可以在成本和资源受限的用例中提供帮助,尤其是较简单的任务。该模型在关键语言基准测试中的表现优于一些较大的模型,同时在满足延迟要求的情况下给出结果。

TensorRT-LLM 将支持 Phi-3 Mini 的长上下文窗口,并使用 LongRoPE、FP8/飞行批处理等众多优化措施和内核来提高推理吞吐量,减少延迟。TensorRT-LLM 的应用很快将在 GitHub 上的示例文件夹中提供。

开发者可以转换为 TensorRT-LLM 检查点格式,该格式针对推理进行了优化,可以轻松地与 NVIDIA Triton 推理服务器一起部署。

开发开放式系统

NVIDIA 是开源生态系统的积极贡献者,已经发布了 500 多个带有开源许可证的项目。

NVIDIA 为 JAX、Kubernetes、OpenUSD、PyTorch 和 Linux 内核等众多外部项目做出了贡献,还为各种开源基金会和标准机构提供支持。

此次发布建立在 NVIDIA 与微软深厚的合作基础上,双方的合作为加速 DirectML、Azure 云、生成式 AI 研究以及医疗和生命科学等领域的创新铺平了道路。

审核编辑:刘清

-

机器人

+关注

关注

211文章

28632浏览量

208267 -

NVIDIA

+关注

关注

14文章

5075浏览量

103649 -

嵌入式设备

+关注

关注

0文章

110浏览量

17023 -

GPU芯片

+关注

关注

1文章

303浏览量

5890 -

大模型

+关注

关注

2文章

2543浏览量

3111

原文标题:小巧而强大:NVIDIA 加速微软 Phi-3 开源“小语言模型”

文章出处:【微信号:NVIDIA-Enterprise,微信公众号:NVIDIA英伟达企业解决方案】欢迎添加关注!文章转载请注明出处。

发布评论请先 登录

相关推荐

NVIDIA推出开放式Llama Nemotron系列模型

使用NVIDIA TensorRT提升Llama 3.2性能

NVIDIA NIM助力企业高效部署生成式AI模型

在英特尔酷睿Ultra7处理器上优化和部署Phi-3-min模型

NVIDIA加速微软最新的Phi-3 Mini开源语言模型

NVIDIA加速微软最新的Phi-3 Mini开源语言模型

评论