小型化、私有化, 大厂竞逐端侧生成式AI

2024年,端侧运行生成式AI,几乎成了Intel、AMD、高通等厂商下一代芯片的标配。

在CES上大火的Rabbit R1,可以利用ChatGPT来操作很多手机端的app,完全自然语言控制,演示视频让很多自媒体鼓吹可以抛弃手机了,但是有拿到产品的网友实测后发现,单任务响应时间超过20s,用户体验不友好。

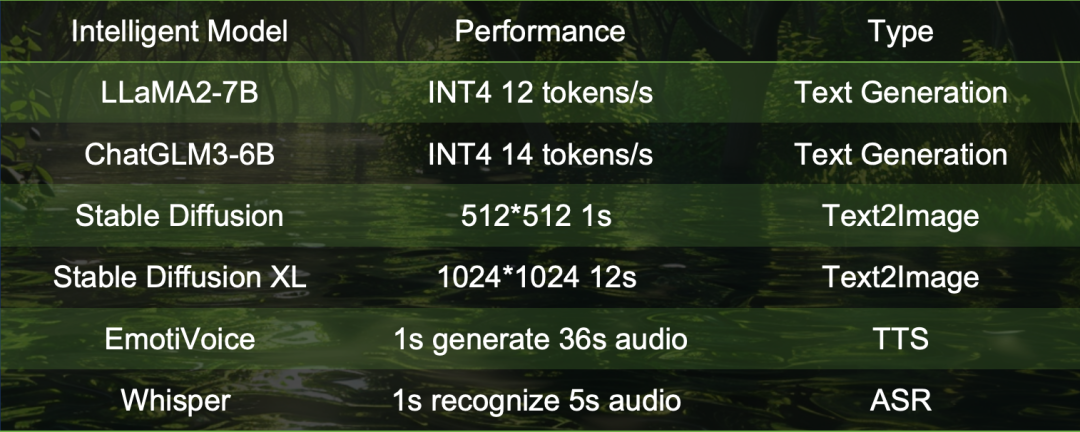

在网络访问不畅通的情况下,如何才能获得实时、低延迟的响应?答案是,把生成式AI服务放在端侧,而不是在云、数据中心和端侧节点之间频繁传输。基于SG2300x打造的端侧生成式AI盒子Airbox,Llama-7B的速度可以达到12 tokens/s,StableDiffusion 1s 出图,让生成式AI触手可及。

SG2300X:令人惊喜的端侧生成式AI处理能力

| 产品规格 | SG2300X |

| 处理器 | ARMA538核2.3GHz |

| 内存 | LPDDR4x 4.266 Gbps 128bit 68.256 GB/s;最大容量支持16GB |

| 智能算力 | 24 TOPS INT8;12 TFLOPS FP16/BF16;2 TFLOPS FP32;支持混合精度计算 |

| 视频解码 | H.264 & H.265: 32路 1080P @25fps;最大分辨率支持7680* 4320 |

| 视频编码 | H.264 & H.265: 12路 1080P @25fps;最大分辨率支持7680* 4320 |

| 图片编解码 | JPEG:解码750张/秒@1080P;编码250张/秒@1080P;最大分辨率支持 32768 * 32768 |

| 视频后处理 | 支持图像的CSC(RGB/YUV/HSV),resize(1/128~128),crop 支持padding,border,font,contrastandbrightnessadjustment 最大分辨率支持8192*8192,分辨率超过的图片支持切割处理后拼接 支持8bits输入格式:Y only,YUV420/YUV422/YUV444 Planar,NV12/NV21/NV16/NV61 Semi-planar,RGB planar and packed,YUV444 packed,YUV422 packed 支持8/16/32bits输出格式:YUV444/RGB planar 支持8bits输出格式:Y only planar,YUV420/I420 planar,NV12/NV21 semi planar,RGBY/BGRY planar,RGB/BGR packed |

| 高速接口 | PCIeGen3X16EP,可配置成X8RC+X8EP,支持级联 2个以太网RGMII接口,支持速率10/100/1000Mbps;1个SD/SDIO controller;1个eMMC 5.1,总线位宽4-bit |

| 低速接口 | 1个SPI Flash接口;3个UART接口,3个I2C接口;2个PWM接口,2个风扇转速检测接口;32个通用IO |

| 安全性 | 支持AES/DES/SM4/SHA/RSA/ECC 加速;支持真随机数产生;支持安全密钥存储机制,支持安全启动,支持Trustzone |

| 典型功耗 | 20W |

| 工作温度 | -40℃~+105℃ |

| 工具链 | 支持TensorFlow / Pytorch / Paddle / Caffe / MxNet / DarkNet / ONNX;支持TensorFlow / Pytorch / Paddle / TensorRT 以及客户定制的INT8、FP16、BF16量化算法 |

SG2300X处理器拥有24T的算力,能够流畅运行像LLAMA-2 7B这样的生成式AI。

SG2300X惊人的算力使其可以在更短的时间内处理更多的数据,实现更快的响应速度,为用户带来更加流畅和智能的体验。

瑞莎 AirBox:国产化边缘智算设备

瑞莎 Fogwise AirBox是瑞莎计算机团队研发的搭载SG2300X的边缘智算盒子,算力高达 24TOPS@INT8,支持多精度(INT8、FP16/BF16、FP32),支持私有 GPT、文本到图像等主流智能模型部署,配备铝合金外壳,可在恶劣环境中部署。

AirBox 的核心元器件皆采用国产元器件,且瑞莎计算机拥有AirBox的完全知识产权,无惧“卡脖子”。

| Radxa Fogwise AirBox | |

| 形态尺寸 | 104mm x 84mm x 52mm |

| 处理器 | SOPHON SG2300X SoC,八核 Arm Cortex-A53(ARMv8)@ 2.3GHz |

| TPU | 张量处理单元,计算能力:最高达24TOPS(INT8),12TFLOPS(FP16/BF16)和2TFLOPS(FP32) 支持领先的深度学习框架,包括 TensorFlow、Caffe、PyTorch、Paddle、ONNX、MXNet、Tengine 和 DarkNet |

| 内存 | 16GB LPDDR4X |

| 存储 | 工业级 64GB eMMC 16MB SPI 闪存 提供高速SD卡的SD卡插槽 |

| 多媒体 | 支持解码32路H.265/H.264 1080p@25fps视频 完全处理32路高清1080P@25fps视频,涉及解码和AI分析 支持编码12路H.265/H.264 1080p@25fps视频 JPEG:1080P@600fps,支持最大32768 x 32768 支持视频后处理,包括图像CSC、调整大小、裁剪、填充、边框、字体、对比度和亮度调整。 |

| 连接 | 2x 千兆以太网端口(RJ45) 1x M.2 M Key(2230/2242)用于NVMe SSD 1x M.2 E Key用于WI-FI/BT |

| 工作温度 | 0°C 到 45°C |

| 外壳 | 耐腐蚀的铝合金外壳 |

| 散热器 | PWM调速风扇与定制散热片 |

大算力+大内存,AirBox打开智能本地化潘多拉魔盒

SG2300X中运行的 Llama-7B 模型,权重量化为 INT4,计算采用 FP16,在计算第一个 token 的时候算力利用率最高达到了80%,后续的推理有kvcache 加持,算力需求有所下降,数据搬运的时间完全覆盖了计算的时间,瓶颈从计算来到了带宽上。

而 StableDiffusion 类的模型,全程都会有密集的算力需求,所以如果想要同时高效运行 LLM 和 Stable Diffusion 类模型,大算力和大内存都是需要的,Airbox 采用的主控 SG2300x 拥有 24TOPS 的 INT8、12TFLOPS 的 FP16 以及 16G 的内存、128bit带宽,恰逢其时。

本地运行并且把响应时间控制到 1s 以内,将极大地提升用户体验。以 qwen-7b 模型为例,跑在 Airbox 上的 latency 为 0.6s,后续推理的速度达到 12 token/s,能够满足自然语言问答、语音交互等场景的实时性需求。

Airbox 同时也是一个完整的运行 Ubuntu Linux 的服务器,它可以支持 CASAOS,独立提供服务,只要联网的设备,就能共享它的算力,古董PC机、平板、手机、NAS、音箱、故事机、电视等设备都能拥有生成式AI的能力,”一机多用“ 已成为现实。

¥2699!极致性价比,让每个人都拥有端侧智能设备

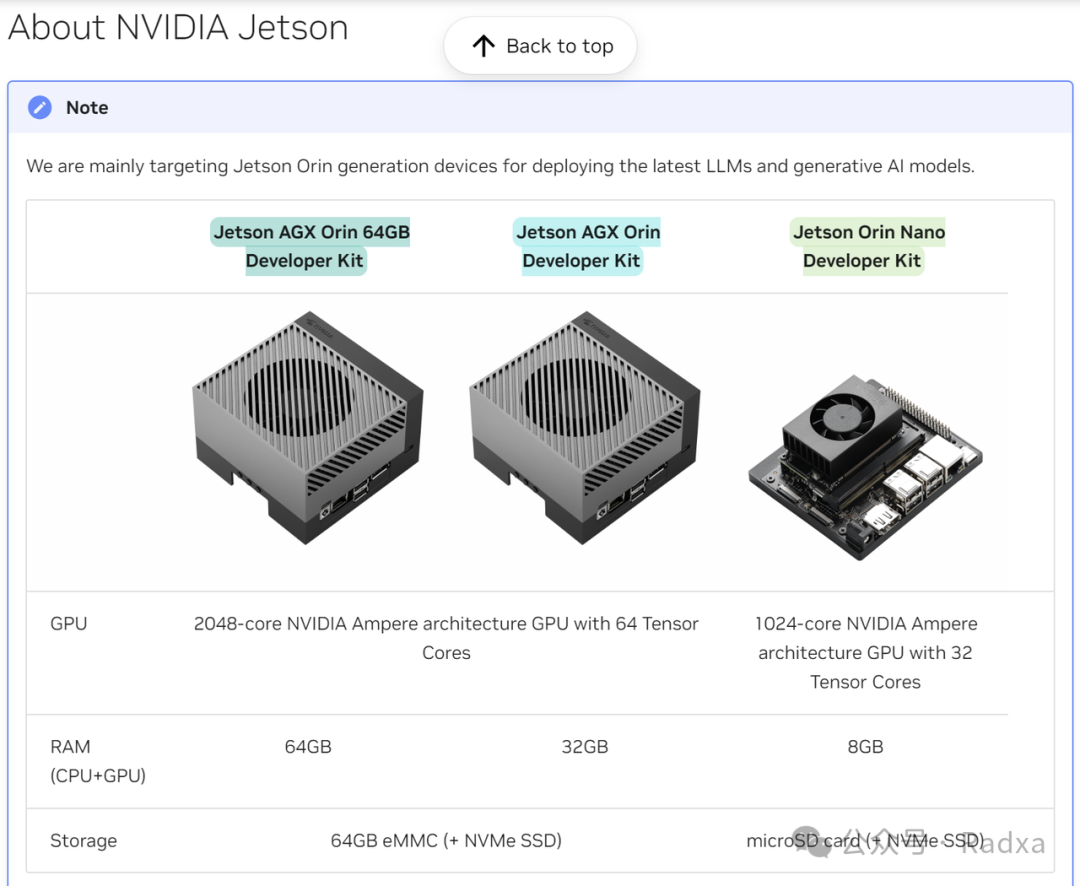

对比目前主流的端侧算力产品,AirBox本地运行生成式AI的效率如何呢?

以Nvidia Jetson 系列多款支持生成式AI的设备为例,京东商城上 Jetson Orin 32G版本售价 8015 元,64G 版本 15600 元。

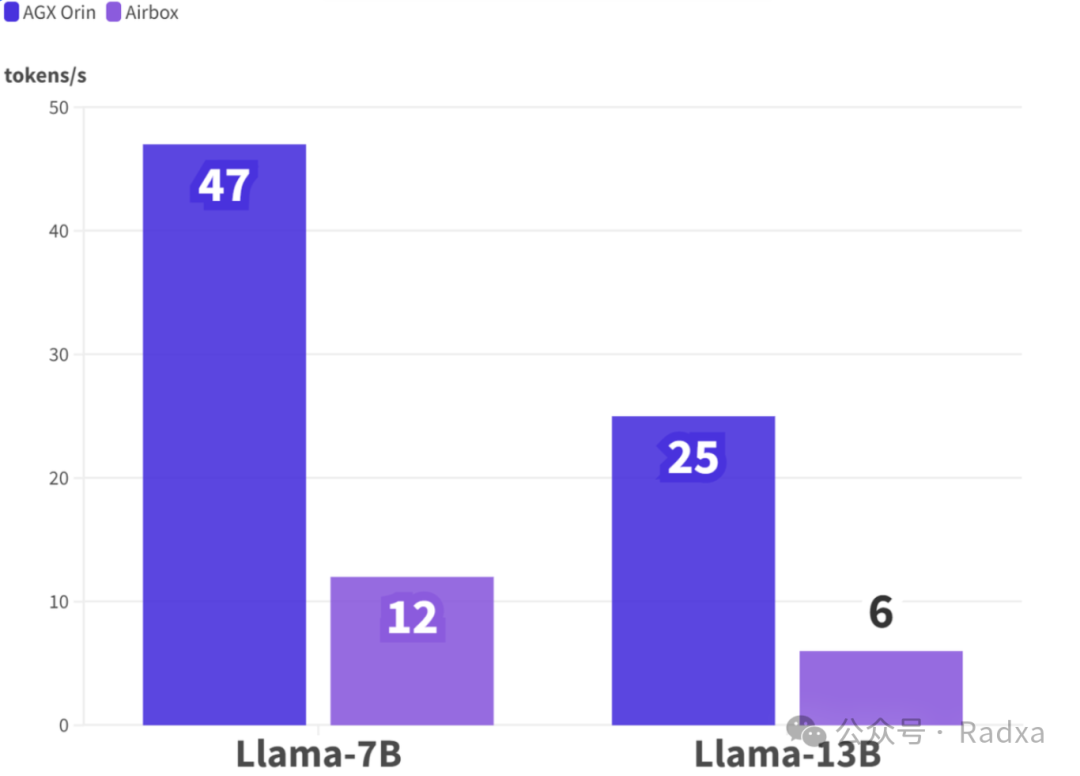

AGX Orin 通过 MLC 加速之后 Llama-7B 47tokens/s,Llama-2-13B 25 tokens/s:airbox 上 Llama2-7B 性能是 12 tokens/s, Llama2-13B 性能是 6 tokens/s,可以支持int4、int8、fp16精度,llama2 及其各种变种模型性能相似;单芯最大可以跑20B-int4的模型。

(注:Orin数据来源英伟达官网;此处数据越高越好)

经测试发现:AGX Orin和AirBox的每人民币(产品售价)可获得的每秒token数(实际性能),AirBox有着显著的优势。

Llama-7B:

AGX Orin(64G)≈0.00301 每秒token数/每人民币

AirBox≈0.00445 每秒token数/每人民币

Llama-13B:

AGX Orin(32G)≈0.00160 每秒token数/每人民币

AirBox≈0.00222 每秒token数/每人民币

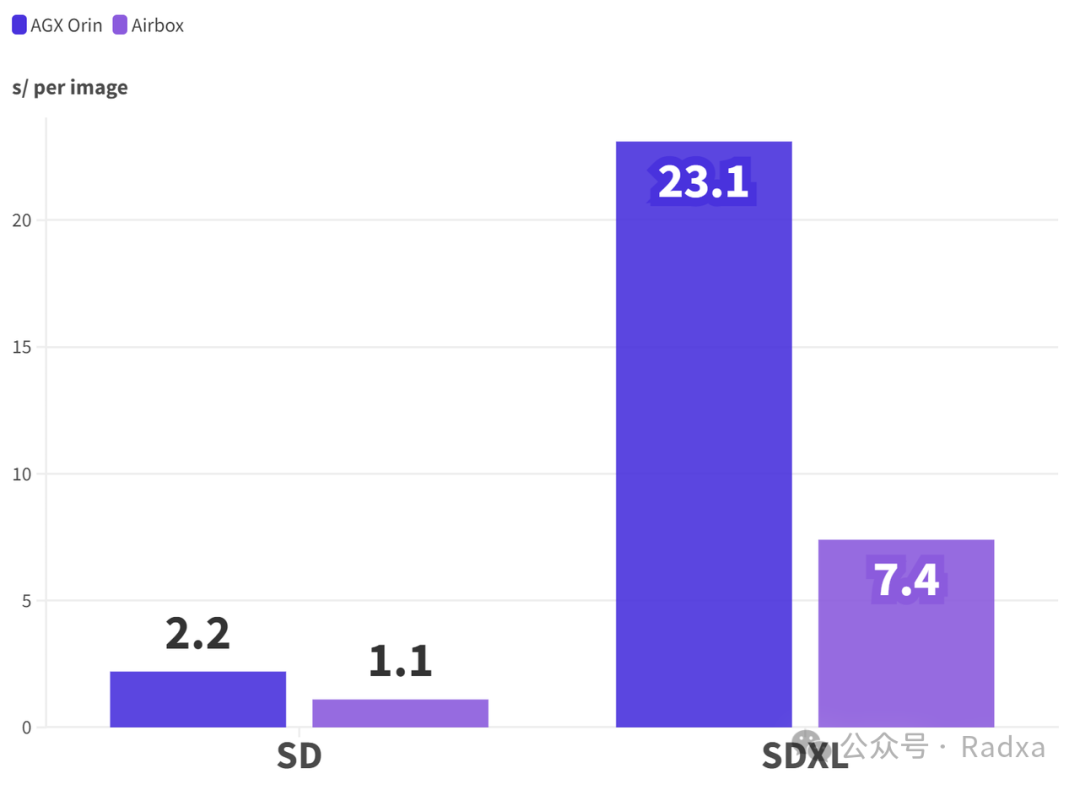

AGX Orin上 Stable Diffusion 每张图耗时 2.2s,SDXL 耗时 23.1s;Airbox使用LCM加速之后,SD1.5 耗时 1.1s,SDXL耗时 7.4s。

(注:Orin数据来源英伟达官网;Orin未标明步数,此处假设都是20步;此处数据越低越好)

丰富的生态应用

瑞莎 Fogwise AirBox 可提供卓越的智能性能,满足您对强大计算能力的需求。这款小巧但功能强大的设备可与 Tensorflow、Pytorch 和 Caffe 等领先的深度学习框架无缝兼容,为用户提供便携、高效的智能体验。无论您是制造商、智算爱好者、业余爱好者还是专业人士,Fogwise AirBox都是您的最佳选择。

支持LLama 3:Meta 最新开源生成式AI

Meta 表示,Llama 3 在多个关键基准测试中展现出卓越性能,超越了业内先进的同类模型。无论是在代码生成、复杂推理,还是在遵循指令和可视化想法方面,Llama 3 都实现了全面领先。该模型在以下五个基准测试中均表现出色:

MMLU(学科知识理解)

GPQA(一般问题解答)

HumanEval(代码能力)

GSM-8K(数学能力)

MATH(高难度数学问题)

面对 Llama 3 如此激动人心的性能,Airbox 团队积极响应,快速将 Llama 3 8B 移植并成功在 Airbox 上运行。以下视频展示了 Llama 3 8B 在 Airbox 上的运行情况:

(注:Llama 3 8B 知识更新到 2023 年 3 月)

可以看到,Llama 3 8B 在 Airbox 上的运行表现极为流畅,达到了 9.6 token/s 的处理速度,已充分展现出其实用价值。

AirBox 团队率先推出基于AirBox的Llama 3 8B 的在线体验,欢迎各位切身感受来自 Llama 3 的高超性能与 AirBox所提供的澎湃算力。

关注瑞莎公众号回复【airbox】即可快速体验

(注:服务基于单个 AirBox 部署,如同时体验人数较多,可能会出现排队情况,如需深度体验,建议您在流量低峰时进行)

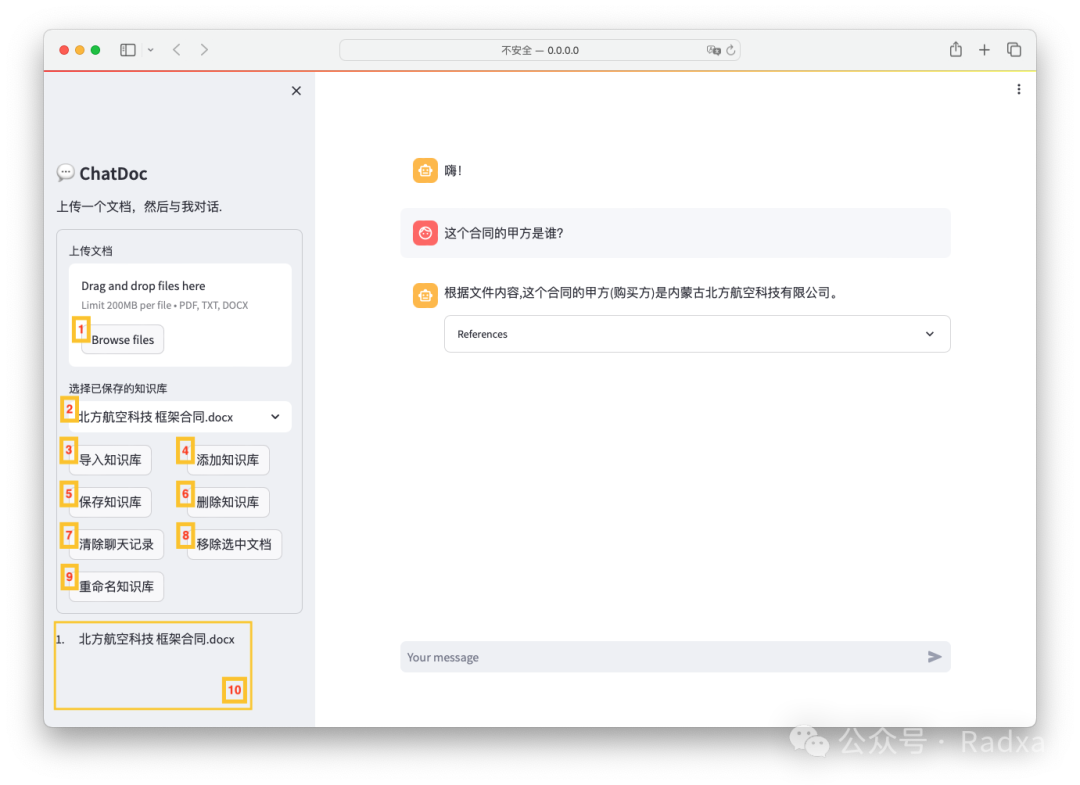

支持CASA OS:轻量且功能丰富的开源面板系统

通过CASA OS 一键安装 AirBox 生成式AI应用

目前已支持 Stable Diffusion、Whisper、ImageSearch、ChatDoc等热门模型,一键轻松安装,免去繁琐环境配置。

文生图、图生图:为您的灵感增添翅膀

AirBox 团队针对 StableDiffusion 进行深度优化和适配,极速出图。支持在线模型更换。

ChatDoc:让AI读懂你的文件

让 AirBox 成为你的私人数据管家。

Whisper:上百种语言实时转文本

Whisper 这个高效的语音识别模型能够实时将语音转换为文本,支持近百种语言,极大地提升了信息获取的便捷性和准确性。无论是会议记录、实时多语翻译还是为视听障人士提供实时字幕,Whisper 都能提供强大的支持,教育、医疗、法律等多个领域都将受益于其精准和快速的语音转录服务。

未来,以LLaMa、Stable Diffusion、Whisper 等生成式AI模型为基座,将诞生更多模态的交叉应用,催生出前所未见的智算能力,覆盖语音、图像和文本等多个领域。设想这样一个场景:一个全能的智能个人助理,Whisper加TTS模型提供真实的多语种能力,实时翻译和转写全球任何一种语言的对话,同时利用Stable Diffusion创造出视觉内容来辅助沟通,这将彻底改变国际会议、远程教育和全球合作的方式,加速数字世界的到来!

-

芯片

+关注

关注

456文章

51157浏览量

427086 -

计算机

+关注

关注

19文章

7534浏览量

88620 -

AI

+关注

关注

87文章

31494浏览量

270253

发布评论请先 登录

相关推荐

FLIR红外热像仪让科技温度触手可及

德州仪器成功举办2024嵌入式技术创新发展研讨会

谷歌Vertex AI助力企业生成式AI应用

智慧交通,让科技触手可及!

亚马逊云科技推出生成式AI服务Amazon App Studio

生成式AI的基本原理和应用领域

芯原AI技术研讨会:引领嵌入式AI新潮流

飞腾云——让高端音质触手可及

天马鼎力支持ThinkPad T14p AI元启版实现全球首发

生成式 AI 进入模型驱动时代

让生成式AI触手可及 ——AirBox 正式开放预定

让生成式AI触手可及 ——AirBox 正式开放预定

评论