据了解,1997年,两位科学家Sepp Hochreiter和Jürgen Schmidhuber共同创建了长短期记忆(LSTM)神经网络结构,用于改善循环神经网络(RNN)的长期记忆功能。

近期,Hochreiter在arXiv平台发表论文,推出了一款新型的XLSTM(扩展LSTM)架构,有效克服了传统LSTM互联网结构“仅能按时间顺序处理信息”的局限性,有望挑战当前热门的Transformer架构。

该论文指出,Hochreiter在新的XLSTM架构中运用了指数型门控循环网络,并引入了“sLSTM”和“mLSTM”两种记忆规则,使神经网络能够更高效地利用RAM,实现类似于Transformer的并行化处理。

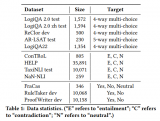

研究团队通过对基于XLSTM和Transformer架构的两款模型进行150亿个Token的训练和测试,结果显示,XLSTM表现更为出色,特别是在“语言能力”方面表现尤为突出。因此,研究人员预测,未来XLSTM有可能与Transformer展开竞争。

声明:本文内容及配图由入驻作者撰写或者入驻合作网站授权转载。文章观点仅代表作者本人,不代表电子发烧友网立场。文章及其配图仅供工程师学习之用,如有内容侵权或者其他违规问题,请联系本站处理。

举报投诉

-

神经网络

+关注

关注

42文章

4762浏览量

100517 -

RAM

+关注

关注

8文章

1367浏览量

114517 -

架构

+关注

关注

1文章

509浏览量

25443

发布评论请先 登录

相关推荐

【《大语言模型应用指南》阅读体验】+ 基础知识学习

的表达方式和生成能力。通过预测文本中缺失的部分或下一个词,模型逐渐掌握语言的规律和特征。

常用的模型结构

Transformer架构:大

发表于 08-02 11:03

Transformer语言模型简介与实现过程

在自然语言处理(NLP)领域,Transformer模型以其卓越的性能和广泛的应用前景,成为了近年来最引人注目的技术之一。Transformer

Transformer模型在语音识别和语音生成中的应用优势

随着人工智能技术的飞速发展,语音识别和语音生成作为人机交互的重要组成部分,正逐渐渗透到我们生活的各个方面。而Transformer模型,自其诞生以来,凭借其独特的自注意力机制和并行计算能力,在

使用PyTorch搭建Transformer模型

Transformer模型自其问世以来,在自然语言处理(NLP)领域取得了巨大的成功,并成为了许多先进模型(如BERT、GPT等)的基础。本

大语言模型:原理与工程时间+小白初识大语言模型

解锁

我理解的是基于深度学习,需要训练各种数据知识最后生成自己的的语言理解和能力的交互模型。

对于常说的RNN是处理短序列的数据时表现出色,耳真正厉害的是

发表于 05-12 23:57

【大语言模型:原理与工程实践】大语言模型的应用

类任务上表现出色,甚至在零样本条件下也能取得良好效果。另一类则需要逐步推理才能完成的任务,类似于人类的系统2,如数字推理等。然而,随着参数量的增加,大语言模型在这类任务上并未出现质的飞

发表于 05-07 17:21

【大语言模型:原理与工程实践】大语言模型的评测

度、多角度的解释或回答。通过这些评测任务,我们能够全面而深入地了解模型在中文语言理解方面的实际能力。

常识百科类评测任务:此类评测任务主要评估

发表于 05-07 17:12

【大语言模型:原理与工程实践】揭开大语言模型的面纱

了随着模型规模扩大,其性能和能力提升速度的变化规律。这一定律在深度学习中表现为模型规模与性能改进之间的关系,通常表明扩大

发表于 05-04 23:55

【大语言模型:原理与工程实践】探索《大语言模型原理与工程实践》

处理中预训练架构Transformer,以及这些技术在现实世界中的如何应用。通过具体案例的分析,作者展示了大语言模型在解决实际问题中的强大

发表于 04-30 15:35

大模型在战略评估系统中的应用有哪些

智慧华盛恒辉大模型,顾名思义,是指参数规模超过千万的机器学习模型。这些模型主要应用于自然语言处理、计算机视觉、语音识别等领域,在大场景下的

大语言模型背后的Transformer,与CNN和RNN有何不同

电子发烧友网报道(文/李弯弯)近年来,随着大语言模型的不断出圈,Transformer这一概念也走进了大众视野。Transformer是一种非常流行的深度学习

Transformer迎来强劲竞争者 新架构Mamba引爆AI圈!

作为通用序列模型的骨干,Mamba 在语言、音频和基因组学等多种模态中都达到了 SOTA 性能。在语言建模方面,无论是预训练还是下游

发表于 12-07 14:14

•476次阅读

基于xLSTM和Transformer的模型评估:xLSTM在“语言能力”的表现

基于xLSTM和Transformer的模型评估:xLSTM在“语言能力”的表现

评论