K折交叉验证算法通常使用数据集中的大部分数据作为**训练集**。

K折交叉验证是一种评估模型性能的统计方法,它涉及将数据集分成K个子集,每个子集大致等大。在K折交叉验证过程中,其中一个子集被留作测试集,而其余的K-1个子集合并起来形成训练集。这个过程会重复K次,每次选择不同的子集作为测试集,以确保每个样本都有机会作为测试集和训练集的一部分。这种方法可以有效地评估模型对新数据的泛化能力,因为它考虑了数据集的多个子集。具体步骤如下:

1. 数据划分:原始数据集被平均分成K个子集。这些子集通常具有相似的数据分布,以确保训练过程的稳定性。

2. 模型训练:在每次迭代中,K-1个子集被合并用作训练集,剩下的一个子集用作验证集。模型在训练集上进行训练。

3. 模型验证:训练好的模型在保留的验证集上进行测试,以评估模型的性能。

4. 性能汇总:重复上述过程K次,每次都使用不同的子集作为验证集。最后,将所有迭代的结果平均,得到模型的整体性能估计。

5. 模型选择:如果有多个模型需要比较,可以根据K折交叉验证的结果选择表现最佳的模型。

6. 最终测试:一旦选择了最佳模型,可以在未参与交叉验证的独立测试集上进行最终测试,以验证模型的泛化能力。

总的来说,K折交叉验证的优势在于它能够更全面地利用数据集,每个数据点都有机会参与训练和测试,从而提高了评估的准确性。此外,它还可以减少由于数据划分方式不同而导致的评估结果波动。然而,这种方法的缺点是计算成本较高,因为需要多次训练模型。此外,如果数据集太小,K折交叉验证可能不够稳定,因为每次迭代的测试集只有总数据集的一小部分。

审核编辑 黄宇

-

算法

+关注

关注

23文章

4646浏览量

93717 -

数据集

+关注

关注

4文章

1212浏览量

24990

发布评论请先 登录

相关推荐

大模型训练:开源数据与算法的机遇与挑战分析

第三章:训练图像估计光照度算法模型

【飞凌嵌入式OK3576-C开发板体验】RKNN神经网络算法开发环境搭建

pycharm怎么训练数据集

机器学习中的交叉验证方法

如何理解机器学习中的训练集、验证集和测试集

神经网络如何用无监督算法训练

人脸识别模型训练失败原因有哪些

人脸识别模型训练是什么意思

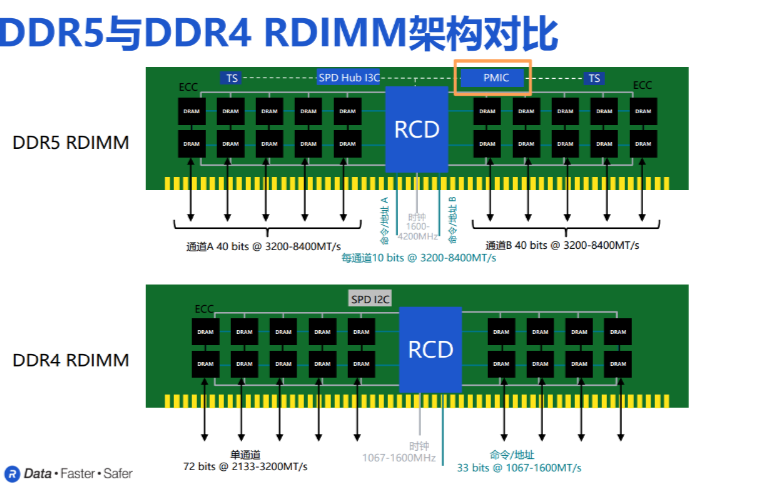

AI训练狂飙,DDR5集成PMIC护航,内存技术持续助力

K折交叉验证算法与训练集

K折交叉验证算法与训练集

评论