GPU在人工智能中相当于稀土金属,甚至黄金,它们在当今生成式人工智能时代中的作用不可或缺。那么,为什么GPU在人工智能发展中如此重要呢?

什么是GPU

图形处理器(GPU)是一种通常用于进行快速数学计算来渲染图形和图像的计算机芯片专业和个人计算。最初,GPU负责渲染2D和3D图像、动画和视频,但现在它们的应用范围更广,尤其在人工智能领域。

GPU应用

具有嵌入式或离散GPU的电子设备能够流畅地渲染3D图形和视频内容,非常适用于人工智能视觉应用。现代可编程GPU也适用于更广泛的场景,一些常见应用包括:加速实时2D和3D图形应用的渲染;视频编辑和视频内容创建,视频游戏图形,加速图像识别、面部检测和识别等机器学习应用,训练深度学习神经网络。

GPU如何工作

GPU通过使用并行处理的方法工作,多个处理器处理单个任务的不同部分。GPU还有单独的内存用于存储正在处理的数据。这种内存专门设计用于容纳大量的信息,以应对高度密集的图形使用情况。

对于图形应用程序,CPU向GPU发送指令以在屏幕上绘制图形内容。GPU以并行和高速的方式执行指令,将内容显示在设备上,这个过程被称为图形或渲染流水线。

GPU与CPU:哪个更适合人工智能?

GPU包含数百个或数千个核心,其晶体管比CPU还多,可以进行并行计算和快速的图形输出。

由于其更快的时钟速度和较少的核心,CPU更适合处理日常的单线程任务,而不是人工智能工作负载。而GPU则处理更复杂的数学和几何计算。这意味着GPU在人工智能训练和推理方面能够提供更高的性能,同时也可以受益于各种加速计算负载。

为什么GPU对于当今的人工智能如此重要?

在人工智能领域,GPU发挥着重要作用,为人工智能的训练和推理提供了出色的性能,在需要加速计算的各种应用中也提供了显著的优势。

GPU的关键功能有3个:

GPU并行处理

人工智能模型主要由层层叠加的线性代数方程组成。每个方程反映了一组数据与另一组数据之间的关联可能性。GPU包含数千个核心,这些微小的计算器并行工作,分片处理构成人工智能模型的计算,为人工智能工作负载提供高效的计算能力。此外,GPU核心不断升级以满足人工智能模型的不断变化需求。

模型复杂性和系统扩展

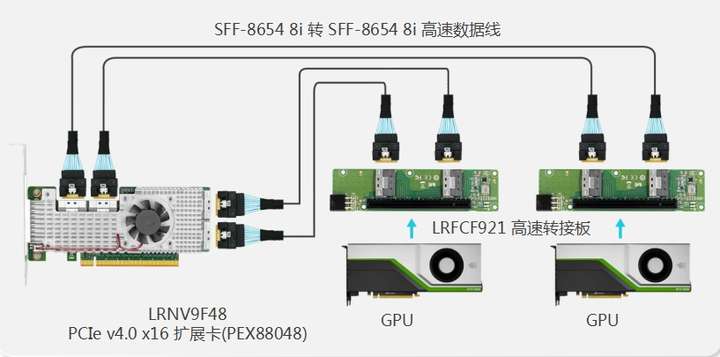

人工智能模型的复杂性以每年10倍的速度增长。前沿大型语言模型(LLM)GPT-4包含超过一万亿个参数,其数学密度令人瞩目。GPU系统通过有效的协作巧妙地应对了这一挑战。它们轻松扩展到超级计算级别,利用快速的NVLink互连和强大的Quantum InfiniBand网络。

广泛而深入的GPU软件堆栈

自2007年以来,不断扩大的英伟达(NVIDIA) GPU软件已经涵盖了人工智能的各个方面,从高级功能到高级应用。CUDA编程语言和cuDNN-X深度学习库为开发人员构建软件提供了基础,例如NVIDIA NeMo。它使用户能够创建、配置和推理自己的生成式人工智能模型。其中许多元素都可作为开源软件提供,这对软件开发人员来说是必不可少的。

GPU对人工智能发展的贡献

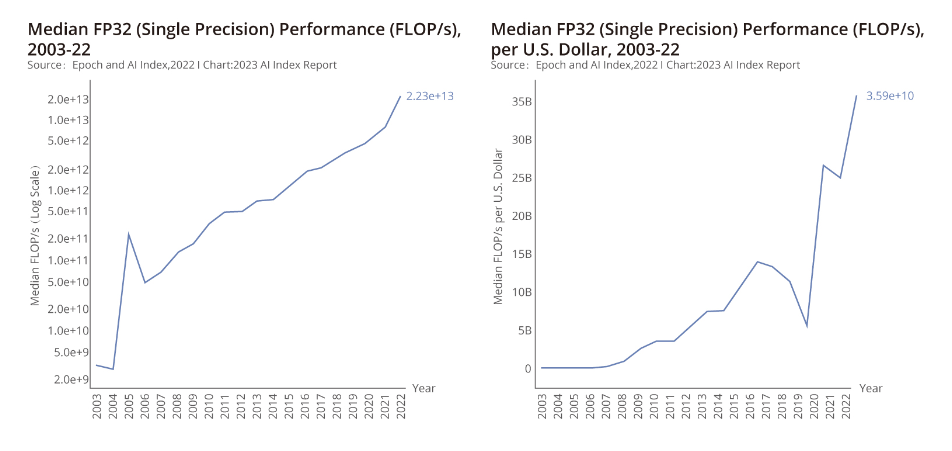

斯坦福大学人工智能小组的报告强调自2003年以来GPU性能的迅速提升,性能提高7000倍,而性价比提高5600倍。GPU已经成为加速机器学习工作负载的主要计算平台,在近年来显著促进了人工智能的进步。值得注意的是,在过去5年中,主要的人工智能模型都是在GPU上进行训练的,例如ChatGPT的成功,它是一个为超过1亿用户提供服务的大型语言模型。

GPU在人工智能领域的广阔前景

人工智能对全球经济的预期影响巨大,麦肯锡预测生成式人工智能在各个领域每年可能贡献18.7万亿至31.7万亿。在这个变革的背景下,GPU发挥着优化性能和推动创新的关键作用。

计算机处理器是任何计算系统中至关重要的组件。在这个数字时代,了解CPU、GPU、ASIC和FPGA之间的区别对于优化整体性能至关重要。飞速(FS)将深入探讨CPU、GPU、ASIC和FPGA之间的区别,以增强您的技术知识,并决定如何选择合适的处理器。

CPU, GPU,ASIC,和FPGA对比分析

CPU、GPU、ASIC和FPGA是四种计算机处理器类型,在任何计算系统中都起着至关重要的作用,并且对整体性能有着显著影响。每种处理器类型(CPU、GPU、ASIC和FPGA)都具有其独特的优势,为提供高效和有效的计算解决方案做出了自己的贡献。

CPU(中央处理器)

CPU是应用于设备(如计算机、手机、电视等)中的主要芯片。其主要功能是在集成到主板中的各个组件之间传播指令。技术原理:通过协调和管理计算机系统中的各个元素,CPU执行指令并处理数据,完成各种复杂的计算和任务管理。应用场景:CPU专为各种电子设备设计,包括计算机和智能手机,作为核心计算单元负责执行各种软件和应用任务。此外,它对外部外设(如键盘和鼠标)与设备的交互具有重要控制作用。

区别:CPU是一种通用处理器,能够处理各种任务。然而,这种通用性其性能可能不如其他专用芯片那样专业。

GPU(图形处理器)

GPU,通常被称为显卡,旨在高效处理图形并将其渲染到屏幕上。它是一种高度专业化的工具。随着计算机能力的提升,GPU的应用范围已经从图形扩展到通用计算任务。技术原理:利用其强大的并行处理架构,能够同时执行大量计算,处理大量图像和图形数据,实现快速渲染和处理图形,提供更出色的视觉体验。应用场景:适用于需要图形加速的任务,如游戏、虚拟现实、3D建模等,以提供更流畅和逼真的视觉效果。近年来,GPU在人工智能、计算机视觉和超级计算等领域发挥着重要作用。

区别:GPU具有强大的图形处理能力,能够执行大量简单的计算。由于其架构的限制,它无法取代CPU,但可以与CPU共同工作。

ASIC(专用集成电路)

ASIC是一种专为特定逻辑功能而设计的硅芯片,因此在性能和速度上相对于通用处理器具有优势,但不能快速适应执行其他任务。

技术原理:通过将特定算法和功能转化为硬件,实现高效、高性能、低功耗的计算加速,需要根据具体应用进行硬件设计和优化。

应用场景:适用于对性能和功耗有严格要求的应用,包括数据中心和人工智能推断等领域。

区别:ASIC对于特定任务非常高效,但不能像CPU和GPU那样用于通用计算。ASIC的计算能力消耗较少的功耗、体积较小,且易于安装。

FPGA(现场可编程门阵列)

FPGA也是一种基于硅的半导体,但其架构与其他处理器不同,依靠一组可配置的逻辑块(CLB)通过可编程互连,FPGA可以重新编程以执行多个任务,使同一硬件可以在不同的项目中使用。技术原理:FPGA可以通过可编程逻辑单元和互连实现多种逻辑功能和计算加速。它们具有根据特定要求进行配置和编程的能力,能够适应实际需求。应用场景:FPGA适用于需要灵活性和可重配置性的场景,如通信设备和图像处理,可以快速适应不同的算法和任务需求。

区别:与ASIC相比,FPGA在灵活性方面具有明显优势。然而,由于其增加的复杂性,FPGA通常需求功耗较高,因此不太适合对能源效率或极端便携性要求严格的项目。

怎样选择CPU, GPU,ASIC,和FPGA

在选择满足计算需求的处理器时,有多种选择:

CPU(通常在日常设备中使用的处理器)提供可靠的性能,功耗相对较低。

由于其出色的计算能力,GPU的应用主要集中在大规模扩展计算能力的高性能计算上,未来将深入到人工智能计算(AIGPU)领域。

ASIC表现出色,但专注于单一任务。ASIC在人工智能深度学习领域并没有得到广泛应用。在比特币挖矿领域,它展现了其高计算能力,低功耗,低价格和强大的专用性。谷歌最近发布专门用于人工智能深度学习计算的TPU,实际上也是一种ASIC。

与ASIC相比,FPGA具有更大的灵活性,但需要更高的功耗。GPU专为图形处理而设计,由于其强大的并行处理架构,在通用计算任务中表现出色。

来源:架构师技术联盟

-

gpu

+关注

关注

28文章

4736浏览量

128931 -

AI

+关注

关注

87文章

30851浏览量

269017 -

人工智能

+关注

关注

1791文章

47258浏览量

238418

发布评论请先 登录

相关推荐

GPU是如何训练AI大模型的

绝缘电阻测试的基础以及为什么它如此重要

《算力芯片 高性能 CPUGPUNPU 微架构分析》第3篇阅读心得:GPU革命:从图形引擎到AI加速器的蜕变

GPU服务器AI网络架构设计

Inflection AI转向英特尔Gaudi 3,放弃英伟达GPU

ai开发需要什么配置

AI训练,为什么需要GPU?

国产GPU在AI大模型领域的应用案例一览

为什么GPU对AI如此重要?

为什么GPU对AI如此重要?

评论