5 月 26 日消息,微软近期推出其小语言 AI 模型新成员“Phi-3-vision”,以卓越的“视觉”处理能力著称,能够深度解析图文信息并在移动设备上稳定运行。

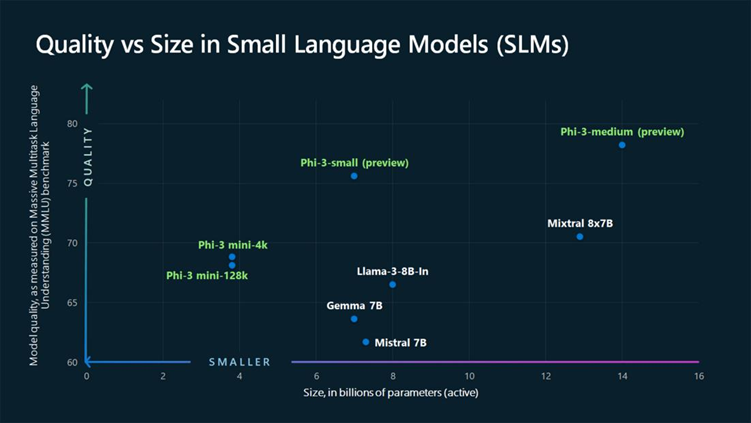

据悉,Phi-3-vision 作为微软 Phi-3 家族的首款多模态模型,继承自 Phi-3-mini 的文本理解能力,兼具轻巧便携特性,适用于移动平台/嵌入式终端;模型参数规模达 42 亿,远超 Phi-3-mini(3.8B),略逊于 Phi-3-small(7B),上下文长度为 128k token,训练时间跨度为 2024 年 2 月至 4 月。

值得关注的是,Phi-3-vision 模型的核心优势在于其强大的“图文识别”功能,能够准确理解现实世界图像的内涵,迅速识别并提取图片中的文字信息。

微软强调,Phi-3-vision 尤其适用于办公场景,开发者针对图表和方块图(Block diagram)识别进行了专门优化,使其能够根据用户输入信息进行推理,并生成一系列决策建议,为企业提供战略参考,被誉为“媲美大型模型”的效果。

在模型训练环节,微软表示 Phi-3-vision 采用了“多元化图片与文字数据”进行训练,涵盖了一系列“精选的公共内容”,如“教科书级”教育素材、代码、图文标注数据、现实世界知识、图表图片、聊天记录等,以保证模型输入内容的丰富性。此外,微软承诺所用训练数据“可追溯”且不含任何个人信息,充分保障用户隐私。

在性能对比方面,微软提供了 Phi-3-vision 与字节跳动 Llama3-Llava-Next(8B)、微软研究院与威斯康星大学、哥伦比亚大学联合研发的 LlaVA-1.6(7B)以及阿里巴巴通义千问 QWEN-VL-Chat 模型等竞品的对比图表,展示了 Phi-3-vision 在多项测试中的优秀表现。

-

微软

+关注

关注

4文章

6590浏览量

104024 -

AI

+关注

关注

87文章

30728浏览量

268886 -

模型

+关注

关注

1文章

3226浏览量

48807

发布评论请先 登录

相关推荐

微软预览版Copilot Vision AI功能上线

用Ollama轻松搞定Llama 3.2 Vision模型本地部署

微软发布Azure AI Foundry,推动云服务增长

在英特尔酷睿Ultra7处理器上优化和部署Phi-3-min模型

聆思CSK6视觉语音大模型AI开发板入门资源合集(硬件资料、大模型语音/多模态交互/英语评测SDK合集)

英特尔机器视觉与AI解决方案助力生产力升级

微软发布视觉型AI新模型:Phi-3-vision

微软发布视觉型AI新模型:Phi-3-vision

评论