电子发烧友网报道(文/李弯弯)万卡集群是指由一万张及以上的加速卡(包括GPU、TPU及其他专用AI加速芯片)组成的高性能计算系统,主要用于加速人工智能模型的训练和推理过程。这种集群的构建旨在解决大模型训练对算力需求的巨大增长问题,尤其是现在模型参数量从百亿级、千亿级迈向万亿级。

国内外企业积极构建万卡集群

目前,在国际上,包括微软、Google、Meta等AI领域的巨头,都已落子超万卡集群的项目部署。如Meta于2022年推出了拥有16000张算卡的超级集群中心;Google于2023年推出了一个拥有2.6万张算卡的Compute Engine A3;而持有OpenAI的微软更是传出正在进行百万规模算卡集群的筹建。

不只是国际厂商,国内厂商也在此前大量采购GPU推进万卡集群建设。尤其在今年以来,三大运营商也相继公布了对超万卡集群的部署。

近日,在中国移动算力网络大会上,中国移动副总经理高同庆宣布,今年将商用哈尔滨、呼和浩特、贵阳的三个万卡集群,总规模近6万张GPU卡,充分满足大模型集中训练的需求。

今年1月,中国电信宣布将在上海规划建设1.5万张卡规模的算力集群,其总算力超4500P,这也将是国内首个超大规模国产算力液冷集群。中国联通表示,在今年内将在上海临港国际云数据中心,建成中国联通首个万卡集群。

除了运营商之外,2023年,蚂蚁集团宣布已建成万卡异构算力集群。此外,包括字节跳动、阿里、百度、华为及科大讯飞等在内的互联网和AI头部企业均在发力万卡集群的建设。

另外,今年5月20日,网宿科技与航锦科技正式签署战略合作协议,双方围绕NVIDIA最新一代万卡集群(L20 cluster AIDC)项目建立战略合作关系,共同开展智算中心建设、相关技术研发、市场拓展等工作,旨在打造高效、智能、绿色的算力基础设施,承载千行百业的大模型训练及推理需求。

网宿科技是全球领先的信息基础设施平台服务提供商,专注于边缘计算、云分发、云安全、云计算、云服务及绿色数据中心业务。航锦科技是由武汉市国资委控股的上市企业,控股子公司超擎数智作为AI算力和网络整体解决方案提供商,是NVIDIA Compute(GPU)、Networking(网络)的双Elite精英级合作伙伴。

构建万卡集群面临的挑战

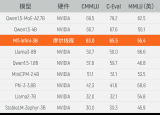

万卡集群的建设和维护面临诸多挑战,首先是GPU的供应,由于全球超万卡集群的建设都处于起步阶段,部署模式都以英伟达GPU及配套设备为主。目前国内在获得英伟达旗舰高性能GPU方面受限,同时,国产AI芯片相比于英伟达GPU在性能上存在一定差距。

其次,在大模型场景下,算力需要大规模集中式训练,单个GPU无法完全容纳整个模型训练,需要采用分布式训练。这会带来GPU之间互联带宽受限或AI服务器之间网络互联带宽有限的问题。此外,卡数量增多后,过热、故障也会一定比例出现,模型训练成本会增加。

当然,目前各企业正在积极解决这些问题。如越来越多国产的AI芯片已经开始在集群的建设中得到使用,包括华为、海光、寒武纪、摩尔线程等公司。

如为了支撑千卡乃至超万卡的大规模算力集群,摩尔线程于2023年推出了首个国内产千卡千亿模型训练平台——夸娥智算集群,该模型深度参与中国移动大模型训练与推理环节,可以为大模型训练提供稳定、高效、高兼容的算力支撑。

摩尔线程相关负责人此前谈到,百卡或更小规模都是实验性的,千卡才是大集群的基本单元,只有千卡及以上才能满足一些基础模型的算力需求,这也是推出夸娥智算集群的目标设定。

另外,浪潮信息董事长彭震日前谈到,芯片算力并非是AI发展不起来的直接原因,更多的其实是系统问题。他认为,对于服务器厂商而言,当前已经不能再局限于提供单一硬件产品,而是要综合性解决方案,这些解决方案可能包括服务器、存储、网络、安全等方面。

浪潮信息希望从算力层提供一个平台,支撑多元算力入驻。对于芯片企业而言,只需要专注在芯片本身而不需要研究互联带宽问题。

据了解,目前不少服务器厂商也在学习英伟达的NVlink,NVlink提供一种高效可扩展的芯片通信间协议,允许所有GPU同时全速实时通信,就好像整个系统是单个GPU一样。在今年4月的GTC大会上,英伟达还宣布NVlink更新到第五代,包括可扩展至576个GPU,能够解决万亿参数混合专家模型通信瓶颈。

新华三集团高级副总裁、云与计算存储产品线总裁徐润安此前也谈到算力互联。在他看来,过去,大家的目标可能是做更强算力的单颗芯片,现在会从另一个角度努力,怎样将芯片做成更大集群,同时使得集群的通信效果更高,集群的处理能力更强。

新华三希望做更加开放的平台,做上游GPU厂商合作伙伴的最佳选择,利用自身网络优势,对网络通信的理解,帮助更多GPU厂商,将算力互联互通实现得更好。新华三提供的科学计算算力调度平台傲飞3.0,实现了跨集群统一管理,将训练任务进行切分,将合适的子任务放在合适的近端或远端模块集群实现。

写在最后

当前,万卡集群式应对大模型背景下算力需求的重要解决方案之一,对于推动人工智能技术的发展和应用具有重要意义。可以看到,国内外都在积极推进万卡集群的建设。然而,在国内,万卡集群的建设并不容易,首先是AI芯片性能及软件生态存在差距,其次是万卡集群建设存在芯片间、卡之间、集群间的互联问题,这些都还需要持续去解决。

-

算力

+关注

关注

1文章

1012浏览量

14932 -

大模型

+关注

关注

2文章

2544浏览量

3069

发布评论请先 登录

相关推荐

国产千卡GPU集群完成大模型训练测试,极具高兼容性和稳定性

弘信电子旗下安联通加入万卡智算集群服务推进方阵

国产智算集群黑马!曦源一号SADA算力集群综合评测表现优异

【「大模型时代的基础架构」阅读体验】+ 未知领域的感受

名单公布!【书籍评测活动NO.41】大模型时代的基础架构:大模型算力中心建设指南

摩尔线程张建中:以国产算力助力数智世界,满足大模型算力需求

中国移动将商用三个自主可控万卡集群

北京:规划建设支撑万亿级参数大模型训练需求的超大规模智算集群

万卡集群解决大模型训算力需求,建设面临哪些挑战

万卡集群解决大模型训算力需求,建设面临哪些挑战

评论