电子发烧友网报道(文/吴子鹏)近日,斯坦福大学AI团队主导的Llama3-V开源模型被证实套壳抄袭国内清华与面壁智能的开源模型“小钢炮”MiniCPM-Llama3-V 2.5。该事件引起了业界的广泛关注,也让大家对于开源大模型的规范使用更加担忧。

斯坦福Llama3V模型被证实抄袭

5月29日,斯坦福大学的一个AI团队在Github等平台发布了一款大模型,名为Llama3V,该模型的亮点是据称只需要500美元就可以训练出一个 SOTA多模态模型,模型效果可比肩GPT-4V、Gemini Ultra等大模型。

由于模型团队来自斯坦福,且效果描述非常吸引眼球,因此该模型很快在社交平台发酵,推特上相关话题的浏览量超过了30万,迅速冲到了Hugging Face首页。

不过,有用户很快发现,Llama3-V大模型实际上是套壳面壁智能的MiniCPM-Llama3-V 2.5,但Llama3-V在发布信息中并没有体现这一点,且称只是使用了MiniCPM-Llama3-V 2.5的tokenizer。但这一说法让用户很难认同,随后有用户在Github页面上指出了套壳的问题,但相关言论很快被斯坦福团队删除。

该用户非常不满随后到MiniCPM-Llama3-V 2.5页面下重述了这一问题,并提醒面壁智能重视此事。面壁团队通过测试发现,Llama3V与MiniCPM-Llama3-V 2.5在“胎记”般案例上的表现100%雷同,做实了斯坦福团队的抄袭行为。随后,这一事件在国外媒体迅速发酵。

随后不久,斯坦福Llama3-V团队承认抄袭,斯坦福本科生Siddharth Sharma和Aksh Garg发布了道歉声明,不过据称是主要责任人的Mustafa Aljadery并没有出现在道歉声明中,这名学生来自南加利福尼亚大学,目前处于失踪的状态,是这一事件的主要过错方。

Aksh Garg在道歉声明中表示,“首先,我们要向MiniCPM原作者道歉。我、Siddharth Sharma,以及Mustafa一起发布了Llama3-V,Mustafa为这个项目编写了代码,但从昨天起就无法联系他。我与Siddharth Sharma主要负责帮助Mustafa进行模型推广。我们俩查看了最新的论文,以验证这项工作的新颖性,但并未被告知或意识到OpenBMB(清华团队支持发起的大规模预训练语言模型库与相关工具)之前的任何工作。我们向作者道歉,并对自己没有努力验证这项工作的原创性感到失望。我们对所发生的事情承担全部责任,并已撤下Llama3-V,再次致歉。”

6月3日,面壁智能CEO李大海与联合创始人刘知远先后发文,回应开源模型被斯坦福大学AI团队抄袭一事。李大海表示:“我们对这件事深表遗憾。一方面感慨这也是一种受到国际团队认可的方式,另一方面呼吁大家共建开放、合作、有信任的社区环境。”“我们希望团队的好工作被更多人关注与认可,但不是以这种方式。”

据介绍,MiniCPM-Llama3-V 2.5是MiniCPM-V系列的最新版本模型,基于SigLip-400M和Llama3-8B-Instruct构建,共参数规模为8B,相较于MiniCPM-V 2.0性能取得较大幅度提升。MiniCPM-Llama3-V 2.5在综合了11个主流多模态大模型评测基准的OpenCompass榜单上平均得分65.1的成绩,超越了GPT-4o、GPT-4V、Gemini Pro、Qwen-VL-Max等商用闭源模型。

开源大模型规范使用值得关注

开源大模型是指一种基于开源技术和大规模数据集构建的人工智能模型,具有开放性和可扩展性的特点。开源大模型与传统的商业人工智能模型不同,其最大的特点在于开放性和可扩展性。这种模型的构建需要利用大量的开源工具和资源,包括开源的深度学习框架、开源的数据集和开源的算法等。

开源大模型是AI大模型发展的重要分支,拥有LLaMA、Grok-1、Stable Code Instruct-3B、Mistral 8x7B和零一万物的Yi-34B等代表产品,这些大模型的发布和发展,不仅显著增强了数据的安全性和隐私保护,更为用户节省了大量成本,减少了对外部依赖的需求。

不过,由于是开源的,因此开源大模型一直以来都面临着被抄袭的风险。实际上,上述提到的零一万物的Yi-34B在去年也是深陷抄袭的漩涡里。2023年11月14日,一位国外开发者在Hugging Face开源主页上评论称,创新工场董事长兼CEO、零一万物CEO李开复旗下 AI 公司“零一万物”开源大模型Yi-34B,完全使用Meta研发的LIama开源模型架构,而只对两个张量(Tensor)名称进行修改。

根据零一万物的说明,零一万物在训练模型过程中,沿用了GPT/LLaMA的基本架构,由于LLaMA社区的开源贡献,让零一万物可以快速起步。零一万物还在声明中称,模型结构仅是模型训练其中一部分。Yi 开源模型在其他方面的精力,比如数据工程、训练方法、baby sitting(训练过程监测)的技巧、hyperparameter设置、评估方法以及对评估指标的本质理解深度、对模型泛化能力的原理的研究深度、行业顶尖的AI infra能力等。

实际上,在更早的2022年,智源研究院的大模型研究中心就被爆出了抄袭的问题,一篇拥有100位作者署名的综述研究《A Roadmap for Big Model》被质疑抄袭了多篇论文内容,引发国内外学者和社区的广泛关注与讨论。另外,商汤、谷歌等公司都曾被指出存在抄袭问题。

目前,AI大模型在防止抄袭、版权归属等问题方面还存在很大的漏洞,行业法规明显不健全,关于大模型使用已有作品进行训练是否构成侵权,以及大模型生成物是否可以享有版权,这类事件也已经有案件发生。相信随着行业的进一步发展,杜绝抄袭和版权归属将逐渐有法可依,这样会更有利于大模型的发展。

结语

斯坦福团队开源大模型抄袭事件暴露了开源大模型的滥用和监管问题,同时AI大模型也还有更深层次的数据和作品版权归属问题,因此不难看出AI大模型尚处于野蛮生长的阶段,未来还需要逐步健全行业法规。

-

大模型

+关注

关注

2文章

2321浏览量

2466

发布评论请先 登录

相关推荐

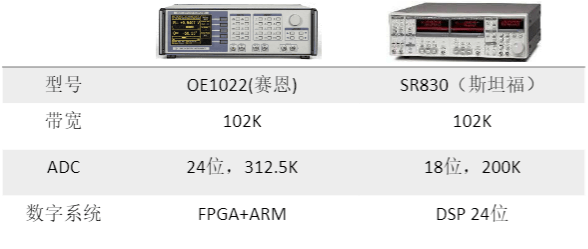

STANFORD斯坦福SR830 锁相放大器

国产仪器崛起:斯坦福替代方案来了!

斯坦福大学研发全新AI辅助全息成像技术

斯坦福发布《2024 AI指数报告》

斯坦福、伯克利大神教授创业给机器人造大脑,OpenAI红杉抢着投5亿

MCSDK 5.2电机启动后经常导致串口失联的原因有哪些?

英伟达CEO黄仁勋建议应届毕业生降低期望

斯坦福继Flash Attention V1和V2又推出Flash Decoding

英伟达CEO黄仁勋:竞争对手的芯片免费也难以比肩英伟达GPU

NVIDIA首席科学家Bill Dally:深度学习硬件趋势

安波福国产系统级芯片舱行泊融合系统亮相CES 2024

维修斯坦福SR560可编程滤波器烧了overload

斯坦福团队抄袭国产大模型,主要责任人失联

斯坦福团队抄袭国产大模型,主要责任人失联

评论