Firefly开源团队推出了 Llama3 部署包,提供简易且完善的部署教程,过程无需联网,简单快捷完成本地化部署。

Step.1

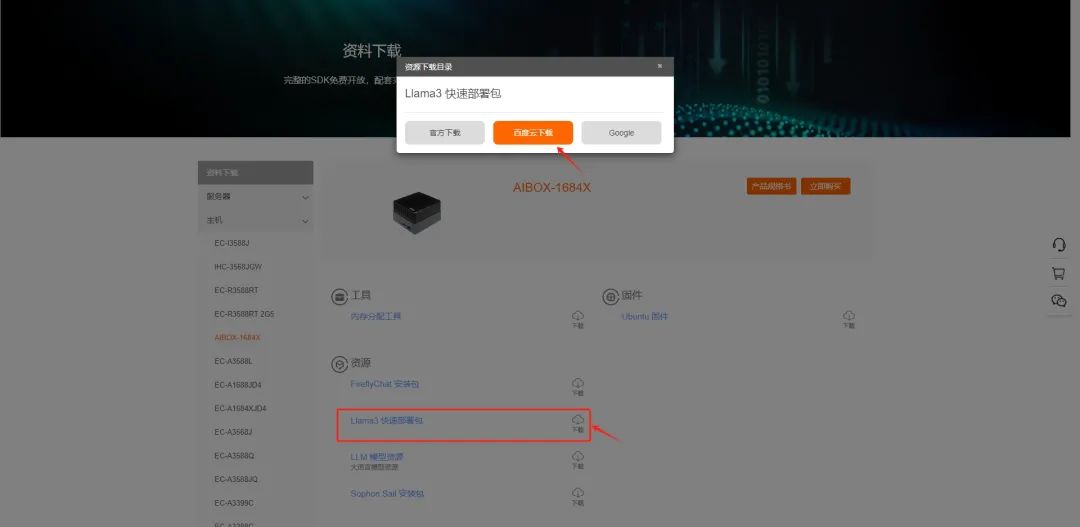

准备部署包

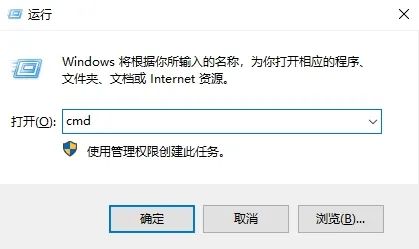

在电脑上以管理员身份打开cmd:

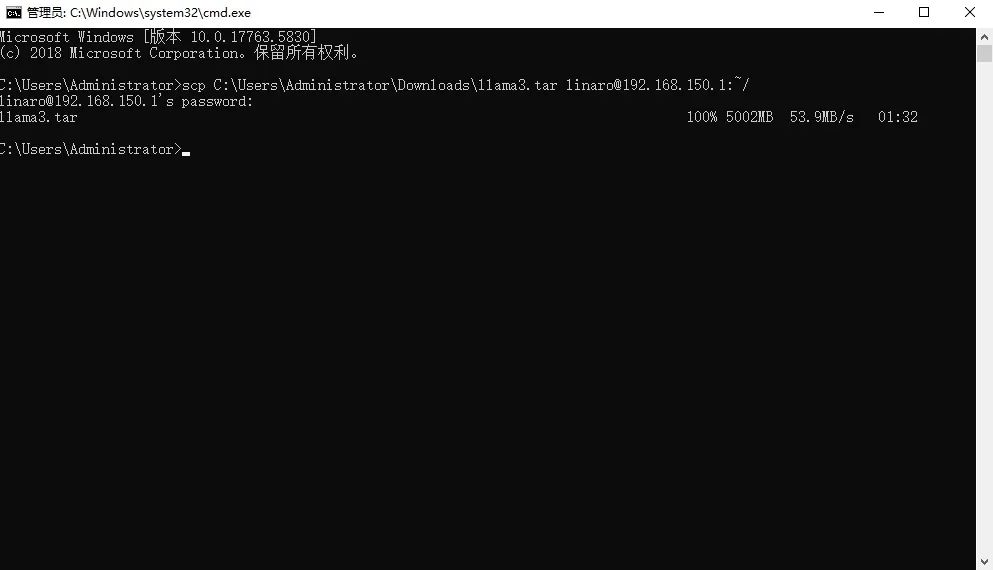

执行 scp 命令传输部署包至AIBOX,并输入密码 linaro 获取访问权限。

scpllama3.tarlinaro@:~/

其中为模型实际的文件路径, 是 AIBOX-BM1684X 的 IP 地址

例:scp C:\Users\Administrator\Downloads\llama3.tar linaro@192.168.150.1:~/

Step.2

部署Llama3

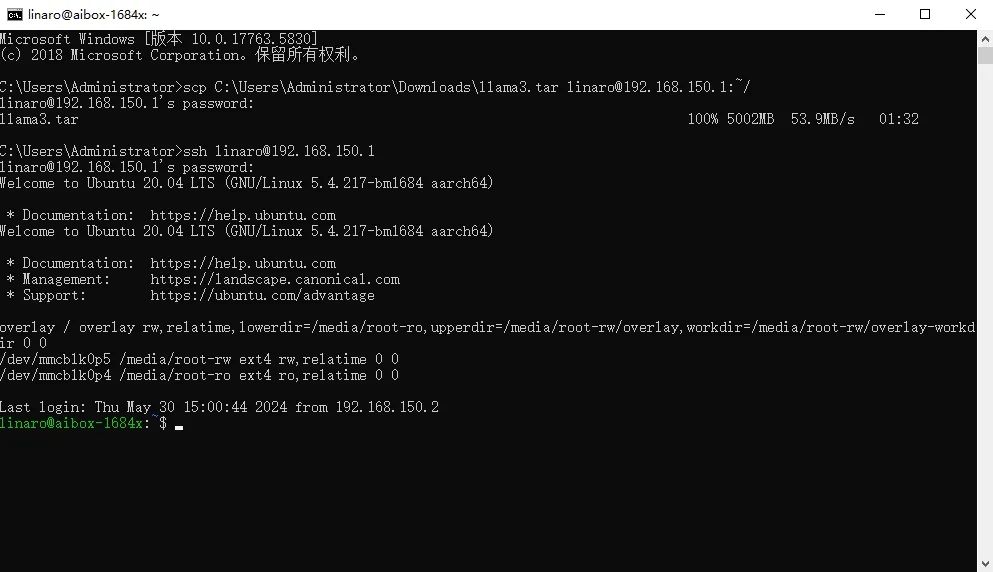

完成部署包的传输后,执行登录命令,连接 AIBOX,并输入密码 linaro。

sshlinaro@192.168.150.1

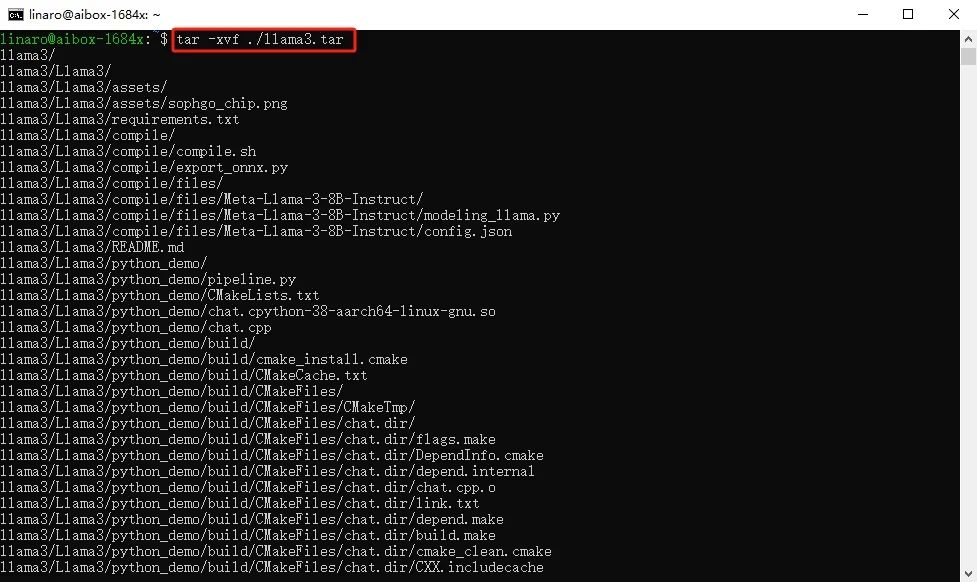

执行以下解压命令,解压部署包,等到解压完成。

tar-xvf./llama3.tar

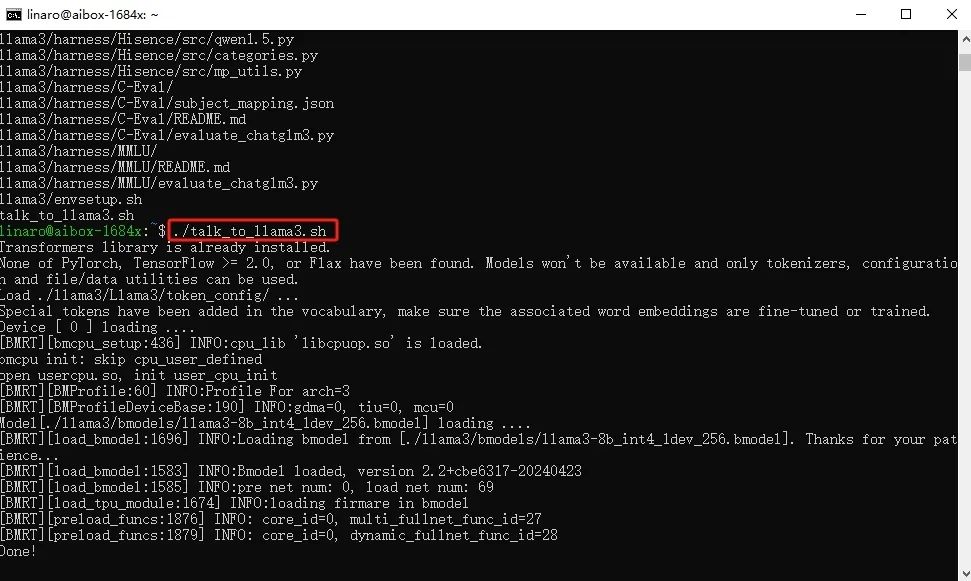

解压完成后,执行部署脚本,等待部署完成。

./talk_to_llama3.sh

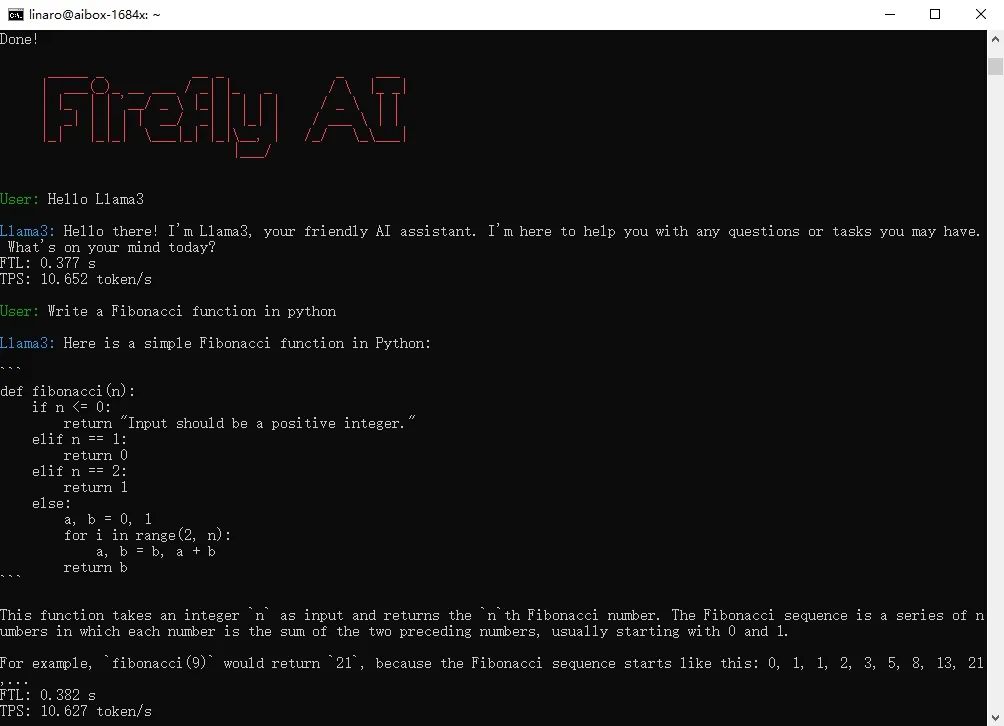

使用Llama3

部署完成后,即可使用 Llama3。

Tip:部署过程中无需联网,首次部署 Llama3 需要花费较长时间进行相应的软件安装(3-5min),请耐心等待。

-

软件

+关注

关注

69文章

5060浏览量

88414 -

Firefly

+关注

关注

2文章

539浏览量

7203

发布评论请先 登录

相关推荐

用Ollama轻松搞定Llama 3.2 Vision模型本地部署

Llama 3 的未来发展趋势

Llama 3 性能评测与分析

Llama 3 适合的行业应用

Llama 3 语言模型应用

使用OpenVINO 2024.4在算力魔方上部署Llama-3.2-1B-Instruct模型

[技术] 【飞凌嵌入式OK3576-C开发板体验】llama2.c部署

源2.0-M32大模型发布量化版 运行显存仅需23GB 性能可媲美LLaMA3

【算能RADXA微服务器试用体验】+ GPT语音与视觉交互:1,LLM部署

使用OpenVINO™在你的本地设备上离线运行Llama3之快手指南

Llama 3 王者归来,Airbox 率先支持部署

【AIBOX上手指南】快速部署Llama3

【AIBOX上手指南】快速部署Llama3

评论