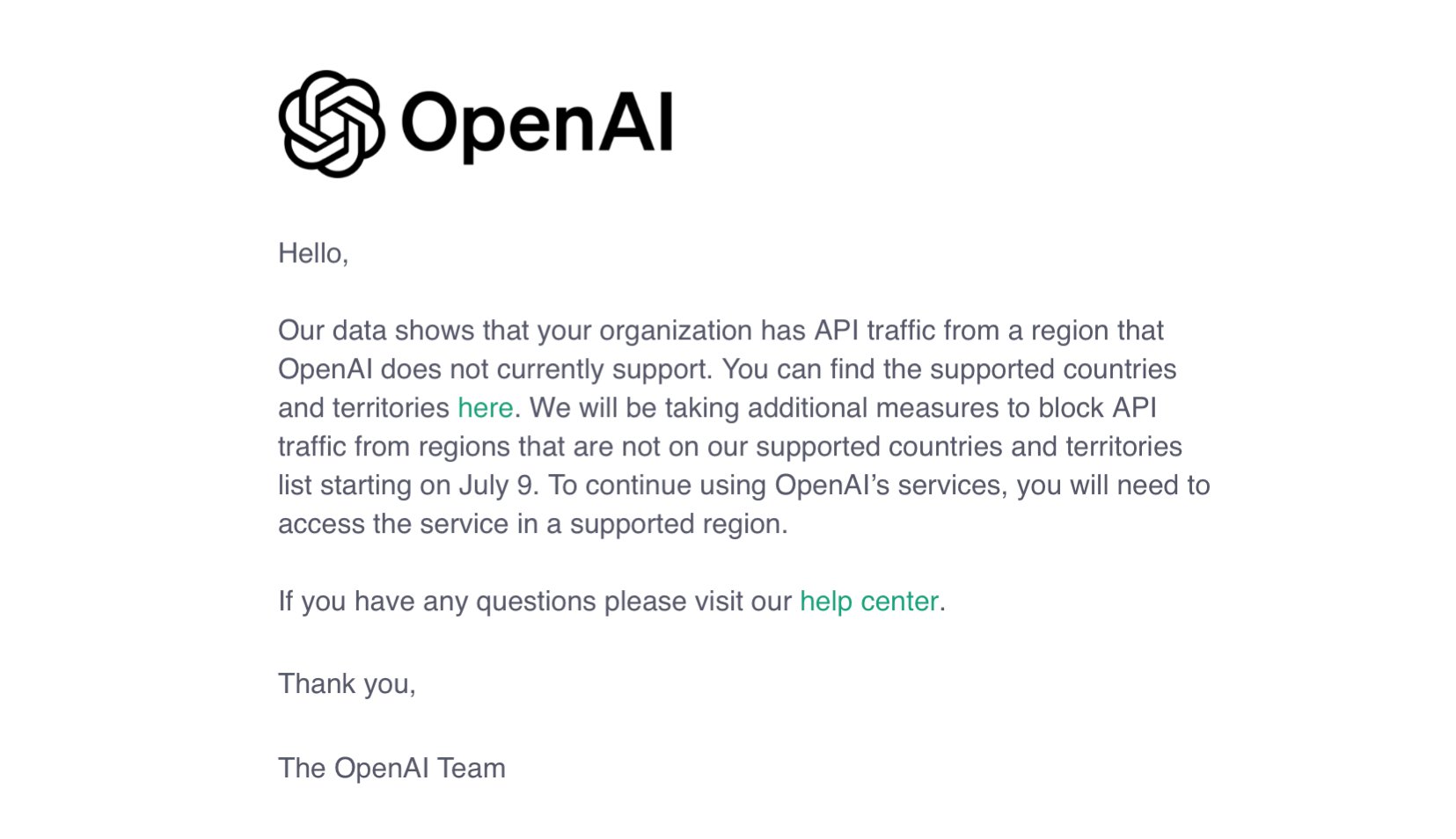

电子发烧友网报道(文/李弯弯)日前,不少国内API开发者收到了来自OpenAI的邮件。邮件称,从7月9日起采取额外措施,阻止来自非支持国家和地区列表中的地区的API流量。根据OpenAI官网,支持访问API服务的国家和地区列表中总计188个国家和地区,不包括中国内地与中国香港。

这意味着,OpenAI宣布终止对中国开发者提供API服务。OpenAI终止对中国提供API服务,对一些通过接入OpenAI API做大模型或应用的企业会有影响,不过这对国产大模型的长远发展却也有积极意义,它反而促进国产大模型的自主研发,并带来更多应用机会。

国产大模型纷纷推出替代方案

随着OpenAI停止对中国提供API服务,国内大模型公司纷纷行动,上线“迁移计划”。如智谱,该公司第一时间在官微宣布,面向OpenAI API用户提供特别搬家计划,帮助用户切换至国产大模型,其 GLM 大模型号称全面对标 OpenAI 产品体系,且全链路技术自研、安全可控。

具体来看,智谱为开发者提供1.5亿Token(5000万 GLM-4 + 1亿 GLM-4-Air),从OpenAI 到 GLM 的系列迁移培训。对于高用量客户,智谱提供与OpenAI使用规模对等的Token赠送计划(不设上限),以及与 OpenAI 对等的并发规模,匹配高等级会员政策,专属搬家顾问及5人天技术专家支持,备案培训和辅助。

百度智能云千帆推出大模型普惠计划,称让用户0成本切换至国内调用量第一的大模型平台,场景更丰富、模型更全面、工具链更完整易用、更安全可靠。

具体来看,即日起为新注册企业用户提供0元调用服务:文心旗舰模型首次免费,赠送ERNIE3.5旗舰模型5000万Tokens包,主力模型ERNIE Speed/ERNIE Lite和轻量模型ERNIE Tiny持续免费 ;针对OpenAI迁移用户额外赠送与OpenAI使用规模对等的ERNIE3.5旗舰模型Tokens包。

同时,该计划还支持0元训练、0元迁移、0元服务。0 元训练:免费模型精调训练服务 0 元迁移:零成本 SDK 迁移工具;0 元服务:专家服务(迁移 & 使用指导)。

腾讯云宣布,即日起至2024年7月31日24时,将为新迁移企业用户免费赠送1亿腾讯混元大模型tokens(标记),并提供免费专属迁移工具和服务。目前,腾讯云提供混元Pro、Standard、Lite等多个不同版本和尺寸的模型,用户可任意选择。

阿里云百炼宣布,将为OpenAI API用户提供最具性价比的中国大模型替代方案,并为中国开发者提供2200万免费tokens和专属迁移服务。根据斯坦福最新公布的大模型测评榜单HELM MMLU,Qwen2-72B得分为0.824,与GPT-4并列全球第四。通义千问GPT4级主力模型Qwen-plus在阿里云百炼上的调用价格为0.004元/千tokens,仅为GPT-4的50分之一。

由李开复创立的AI大模型独角兽公司零一万物也发起“Yi API二折平替计划”,面向OpenAI用户推出平滑迁移至Yi系列大模型的服务。据介绍,目前注册使用Yi API的新客户,零一万物立即赠送100元额度,帮助用户完成平稳过渡;平台充值还将赠送50%到账额度,上不封顶。此外,零一万物API还将提供Prompt兼容调优服务支持。

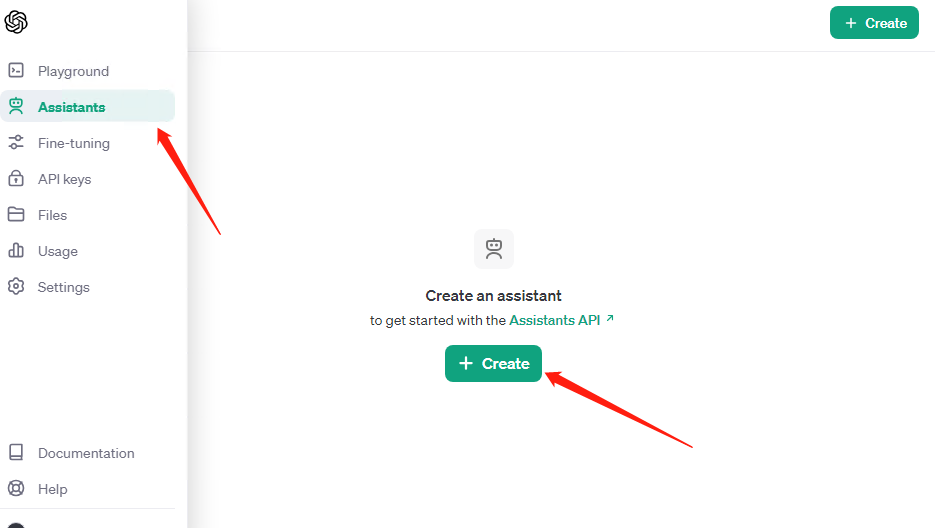

百川智能宣布特别推出OpenAI 零成本迁移计划,将为参与用户免费赠送1 千万 token,同时宣布Assitants API 免费使用。据介绍,目前百川智能开放平台接口已完全兼容OpenAI API,支持零成本迁移,功能更丰富。借助百川技术专家随时答疑,开发者五分钟即可完成Api迁移。

少不了算力芯片的支持

国产大模型纷纷推出替代方案,这背后少不了需要算力芯片的支持。目前国内大模型训练基本使用英伟达GPU,英伟达的GPU因其强大的并行处理能力和高效的计算性能,被广泛应用于深度学习、机器学习等需要大量计算资源的领域。

如阿里通义千问大模型,它包含多个不同规模的版本,Qwen-1.8B、Qwen-7B、Qwen-14B和Qwen-72B等,据了解,阿里通义千问大模型主要使用英伟达Tesla A100、Tesla A800、Tesla H100等GPU芯片,这些GPU具有较大的显存和强大的计算能力,能够满足大模型训练的需求。

百度文心一言主要基于英伟达的A100 GPU完成其高效的深度学习计算任务。A100 GPU采用了NVIDIA最新的Ampere架构,被广泛应用在各种AI模型和高性能计算场景中。A100 GPU在文心一言的构建和运行过程中,执行大规模并行处理任务,特别是在语义理解、语境关联及文本生成等领域内。

除此之外,百度也兼容其他公司的GPU,在英伟达A100、H100等训练AI用GPU遭遇进口管制的情况下,百度采用了将来自不同供应商的GPU集成到统一的计算集群中的策略,以训练大语言模型。

字节跳动大模型在训练过程中也是主要使用英伟达的GPU。据悉,字节跳动在2023年向英伟达订购了超过10亿美元的GPU产品,目前已经采购了10万块A100与H800加速卡,这两款GPU均属于英伟达的高性能计算产品线,非常适合用于深度学习、大模型训练等任务。

另外,像智谱、百川智能等也主要使用英伟达的GPU。智谱AI通过与优刻得等公司的合作,利用英伟达GPU构建超千卡规模的推理集群,以满足其大模型在文本、图片、视频等多场景下的大规模实时推理需求。

百川智能与鸿博股份的全资子公司英博数科合作,后者向百川智能提供的智算服务器,其单台所提供的算力规模和性能不低于英伟达H系列8卡智算服务器所有的同等算力。这意味着百川智能大模型的训练过程中,将直接使用到英伟达高性能的GPU资源。

除了使用英伟达GPU之外,一些国产大模型的训练和运行也使用国内的算力芯片,如华为、科大讯飞、月之暗面等。同时,海光信息、天数智芯、摩尔线程、沐曦、景嘉微等都已经推出和搭建可以支持大模型训练和推理的芯片、系统和智算集群。

写在最后

总的来说,OpenAI停止对中国开发者提供API服务,对于目前一些调用通过接入OpenAI API做大模型和AI应用的企业来说有所影响,不过,国内不少大模型厂商已经纷纷推出替代方案,虽然目前国产大模型较OpenAI有一定差距,不过随着更多的被使用,长远来看国产大模型将会逐步实现突破。

-

API

+关注

关注

2文章

1503浏览量

62137 -

OpenAI

+关注

关注

9文章

1097浏览量

6567 -

大模型

+关注

关注

2文章

2477浏览量

2834

发布评论请先 登录

相关推荐

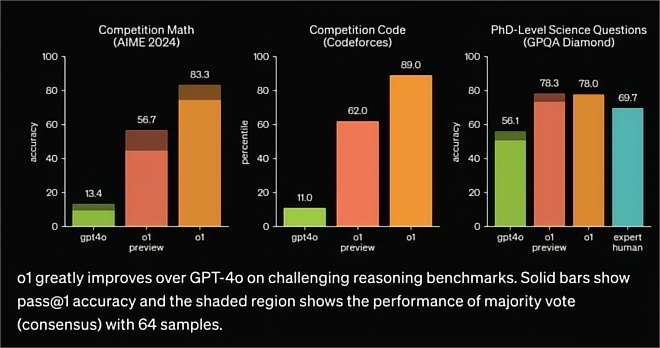

OpenAI发布o1大模型,数理化水平比肩人类博士,国产云端推理芯片的新蓝海?

OpenAI宣布API恢复运行,ChatGPT正在逐步回归

微软寻求在365 Copilot中引入非OpenAI模型

OpenAI 发了一个支持 ESP32 的 Realtime API SDK

OpenAI暂不推出Sora视频生成模型API

OpenAI发布o1模型API,成本大幅下降60%

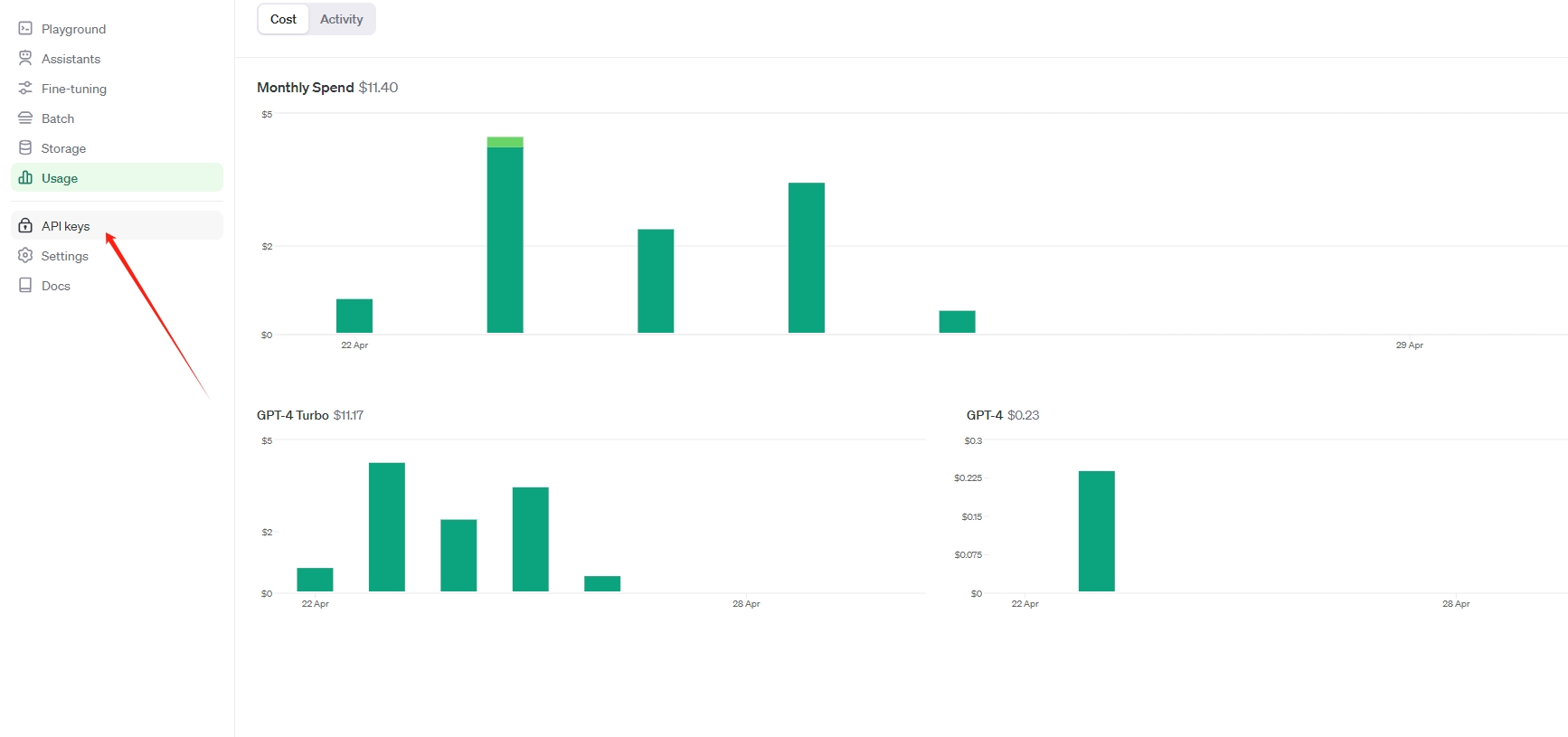

OpenAI api key获取并可调用GPT-4.0、GPT-4o、GPT-4omini

OpenAI发出警告信:多国开发者面临API封锁 OpenAI API解决方案

OpenAI API Key获取:开发人员申请GPT-4 API Key教程

高性能、低成本的无线模块完美替代SX1278

OpenAI 深夜抛出王炸 “ChatGPT- 4o”, “她” 来了

智谱AI正在研发国产文生视频模型,对标OpenAI Sora

OpenAI API Key获取与充值教程:助开发者解锁GPT-4.0 API

OpenAI断供API,国产大模型替代方案低成本迁移

OpenAI断供API,国产大模型替代方案低成本迁移

评论