人工神经网络(Artificial Neural Network,简称ANN)是一种模仿人脑神经网络结构和功能的数学模型,它由大量的神经元(或称为节点、单元)通过复杂的连接关系组成。人工神经网络具有强大的学习能力和适应性,被广泛应用于各种领域,如图像识别、语音识别、自然语言处理、推荐系统等。本文将详细介绍人工神经网络的基本原理,包括神经元模型、网络结构、学习规则和训练算法等。

- 神经元模型

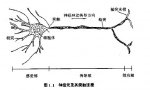

人工神经网络的基本单元是神经元,它模仿了生物神经系统中的神经元。一个神经元通常包含以下几个部分:

1.1 输入(Input):神经元接收来自其他神经元的输入信号,这些信号可以是数值、图像像素值、音频信号等。

1.2 权重(Weight):每个输入信号都有一个与之对应的权重,权重决定了输入信号对神经元输出的影响程度。权重是可训练的参数,可以通过学习过程不断调整。

1.3 偏置(Bias):偏置是神经元的另一个可训练参数,它为神经元提供了一个基准值,使得神经元的输出可以在不同的范围内变化。

1.4 激活函数(Activation Function):激活函数是神经元的核心部分,它将输入信号经过加权求和和偏置调整后的值转换为神经元的输出。常见的激活函数有Sigmoid函数、Tanh函数、ReLU函数等。

1.5 输出(Output):神经元的输出是激活函数的计算结果,它可以作为其他神经元的输入信号,也可以作为神经网络的最终输出。

- 网络结构

人工神经网络由多个神经元按照一定的拓扑结构连接而成。根据神经元之间的连接方式,神经网络可以分为以下几种类型:

2.1 多层感知器(Multilayer Perceptron,简称MLP):MLP是最基本的神经网络结构,由输入层、隐藏层和输出层组成。输入层接收外部信号,隐藏层对输入信号进行非线性变换,输出层产生最终的输出结果。

2.2 卷积神经网络(Convolutional Neural Network,简称CNN):CNN是一种适用于图像处理的神经网络结构,它通过卷积层提取图像的局部特征,然后通过池化层降低特征的空间维度,最后通过全连接层产生最终的输出结果。

2.3 循环神经网络(Recurrent Neural Network,简称RNN):RNN是一种具有时间序列处理能力的神经网络结构,它通过循环连接将神经元的输出反馈到输入,从而实现对时间序列数据的建模。

2.4 生成对抗网络(Generative Adversarial Network,简称GAN):GAN由生成器和判别器两部分组成,生成器负责生成数据,判别器负责区分生成数据和真实数据。两者相互竞争,不断优化,最终达到生成高质量数据的目的。

- 学习规则

人工神经网络的学习过程是通过调整神经元之间的连接权重来实现的。学习规则是指导权重调整的方法,常见的学习规则有:

3.1 误差反向传播(Error Backpropagation):误差反向传播是一种监督学习算法,它通过计算输出误差,然后逆向传播到网络的每一层,逐层调整权重,以最小化误差。

3.2 梯度下降(Gradient Descent):梯度下降是一种优化算法,它通过计算损失函数关于权重的梯度,然后沿着梯度的反方向更新权重,以寻找损失函数的最小值。

3.3 动量(Momentum):动量是一种加速梯度下降的方法,它通过在权重更新时加入前一次更新的动量,使得权重更新更加平滑,避免陷入局部最小值。

3.4 AdaGrad:AdaGrad是一种自适应学习率的优化算法,它根据每个权重的更新历史调整学习率,使得不同权重的学习速度自适应调整。

- 训练算法

训练算法是实现学习规则的具体方法,常见的训练算法有:

4.1 批量梯度下降(Batch Gradient Descent):批量梯度下降是一种使用整个训练数据集计算梯度的方法,它在每次迭代时更新一次权重,适用于大规模数据集。

4.2 随机梯度下降(Stochastic Gradient Descent,简称SGD):随机梯度下降是一种使用单个训练样本计算梯度的方法,它在每次迭代时更新权重,适用于在线学习和小规模数据集。

4.3 小批量梯度下降(Mini-batch Gradient Descent):小批量梯度下降是一种折中的方法,它使用一个小批量的训练样本计算梯度,然后在每次迭代时更新权重,既考虑了计算效率,又考虑了更新的稳定性。

4.4 深度学习框架:随着深度学习的发展,出现了许多深度学习框架,如TensorFlow、PyTorch、Keras等,它们提供了丰富的训练算法和工具,方便用户快速实现和训练神经网络。

-

人工神经网络

+关注

关注

1文章

119浏览量

14624 -

数学模型

+关注

关注

0文章

83浏览量

11933 -

神经元

+关注

关注

1文章

363浏览量

18450 -

网络模型

+关注

关注

0文章

44浏览量

8429

发布评论请先 登录

相关推荐

卷积神经网络模型发展及应用

人工神经网络基础描述详解

阐述人工神经网络模型的基本原理

阐述人工神经网络模型的基本原理

评论