神经网络是一种强大的机器学习模型,广泛应用于各种分类任务。在本文中,我们将详细介绍几种适合分类任务的神经网络模型,包括前馈神经网络、卷积神经网络、循环神经网络、深度信念网络和长短期记忆网络等。

- 前馈神经网络(Feedforward Neural Networks)

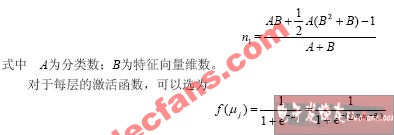

前馈神经网络是一种最基本的神经网络结构,由输入层、隐藏层和输出层组成。每个神经元接收前一层神经元的输出作为输入,并通过激活函数生成输出,传递给下一层神经元。前馈神经网络的训练过程通常使用反向传播算法和梯度下降法。

前馈神经网络的优点是结构简单,易于实现和训练。然而,它在处理复杂的分类任务时可能表现不佳,因为它不能很好地捕捉数据的非线性特征。

1.1 多层感知器(Multilayer Perceptron, MLP)

多层感知器是一种包含多个隐藏层的前馈神经网络。通过增加隐藏层的数量,多层感知器可以更好地捕捉数据的非线性特征,提高分类性能。然而,过多的隐藏层可能导致过拟合问题。

1.2 径向基函数神经网络(Radial Basis Function Neural Networks, RBFNN)

径向基函数神经网络是一种特殊的前馈神经网络,其隐藏层神经元使用径向基函数作为激活函数。径向基函数可以捕捉数据的局部特征,使得RBFNN在处理高维数据时具有较好的泛化能力。

- 卷积神经网络(Convolutional Neural Networks, CNN)

卷积神经网络是一种针对图像数据设计的神经网络结构,由卷积层、池化层和全连接层组成。卷积层通过卷积操作提取图像的局部特征,池化层对特征进行降维处理,全连接层则用于分类任务。

卷积神经网络的优点是可以自动学习图像的局部特征,减少参数数量,提高计算效率。此外,卷积神经网络在图像分类任务中表现出色,已成为图像识别领域的主流模型。

2.1 AlexNet

AlexNet是一种深度卷积神经网络,由5个卷积层和3个全连接层组成。AlexNet在2012年的ImageNet竞赛中取得了突破性的成绩,开启了深度学习在计算机视觉领域的应用。

2.2 VGGNet

VGGNet是一种使用更小的卷积核和更深的网络结构的卷积神经网络。VGGNet通过重复使用3x3的卷积核和2x2的池化操作,实现了更深的网络结构,提高了分类性能。

2.3 ResNet

ResNet是一种引入残差连接的卷积神经网络,可以解决深度网络训练中的梯度消失问题。ResNet通过添加跳跃连接,使得网络可以学习到更深层次的特征,提高了分类性能。

- 循环神经网络(Recurrent Neural Networks, RNN)

循环神经网络是一种适合处理序列数据的神经网络结构,由循环单元组成。循环单元可以存储和传递前一个时间步的信息,使得RNN可以捕捉序列数据的时间依赖性。

循环神经网络的优点是可以处理序列数据,适用于自然语言处理、语音识别等领域。然而,RNN在处理长序列数据时可能遇到梯度消失或梯度爆炸的问题。

3.1 长短期记忆网络(Long Short-Term Memory, LSTM)

长短期记忆网络是一种改进的循环神经网络,通过引入门控机制解决了梯度消失问题。LSTM通过输入门、遗忘门和输出门控制信息的流动,使得网络可以学习到长序列数据的特征。

3.2 门控循环单元(Gated Recurrent Unit, GRU)

门控循环单元是一种与LSTM类似的循环神经网络,通过引入更新门和重置门控制信息的流动。GRU的结构相对简单,但在某些任务中可以与LSTM相媲美。

- 深度信念网络(Deep Belief Networks, DBN)

深度信念网络是一种由多层受限玻尔兹曼机(RBM)堆叠而成的神经网络结构。DBN可以通过无监督预训练的方式学习数据的层次特征,然后通过有监督微调的方式进行分类任务。

深度信念网络的优点是可以通过无监督预训练提高模型的泛化能力,适用于数据量较小的任务。然而,DBN的训练过程较为复杂,且在某些任务中可能不如其他神经网络模型。

- 长短期记忆网络(Long Short-Term Memory, LSTM)

长短期记忆网络是一种特殊的循环神经网络,通过引入门控机制解决了梯度消失问题。LSTM在处理序列数据时具有较好的性能,已被广泛应用于自然语言处理、语音识别等领域。

-

非线性

+关注

关注

1文章

214浏览量

23292 -

函数

+关注

关注

3文章

4360浏览量

63554 -

神经网络模型

+关注

关注

0文章

24浏览量

5692 -

神经元

+关注

关注

1文章

368浏览量

18648

发布评论请先 登录

相关推荐

什么神经网络模型适合做分类

什么神经网络模型适合做分类

评论