PyTorch是一个广泛使用的深度学习框架,它以其灵活性、易用性和强大的动态图特性而闻名。在训练深度学习模型时,数据集是不可或缺的组成部分。然而,很多时候,我们可能需要使用自己的数据集而不是现成的数据集。本文将深入解读如何使用PyTorch训练自己的数据集,包括数据准备、模型定义、训练过程以及优化和评估等方面。

一、数据准备

1.1 数据集整理

在训练自己的数据集之前,首先需要将数据集整理成模型可以识别的格式。这通常包括以下几个步骤:

- 数据收集 :收集与任务相关的数据,如图像、文本、音频等。

- 数据清洗 :去除噪声、错误或重复的数据,确保数据质量。

- 数据标注 :对于监督学习任务,需要对数据进行标注,如分类标签、回归值等。

- 数据划分 :将数据集划分为训练集、验证集和测试集,通常的比例为70%、15%和15%。这一步是为了在训练过程中能够评估模型的性能,避免过拟合。

1.2 数据加载

在PyTorch中,可以使用torch.utils.data.Dataset和torch.utils.data.DataLoader来加载数据。如果使用的是自定义数据集,需要继承Dataset类并实现__getitem__和__len__方法。

- ** getitem (self, index)** :根据索引返回单个样本及其标签。

- ** len (self)** :返回数据集中样本的总数。

例如,如果有一个图像分类任务的数据集,可以将图像路径和标签保存在一个文本文件中,然后编写一个类来读取这个文件并返回图像和标签。

1.3 数据预处理

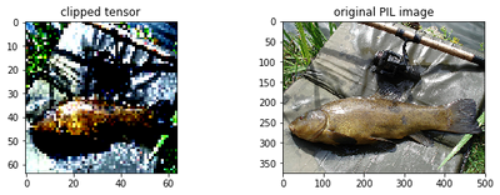

数据预处理是提高模型性能的关键步骤。在PyTorch中,可以使用torchvision.transforms模块来定义各种图像变换操作,如缩放、裁剪、翻转、归一化等。这些变换可以在加载数据时进行应用,以提高模型的泛化能力。

二、模型定义

在PyTorch中,可以使用torch.nn.Module来定义自己的模型。模型通常包括多个层(如卷积层、池化层、全连接层等),这些层定义了数据的变换方式。

2.1 层定义

在定义模型时,首先需要定义所需的层。PyTorch提供了丰富的层定义,如nn.Conv2d(卷积层)、nn.MaxPool2d(最大池化层)、nn.Linear(全连接层)等。通过组合这些层,可以构建出复杂的神经网络结构。

2.2 前向传播

在定义模型时,需要实现forward方法,该方法定义了数据通过模型的前向传播过程。在forward方法中,可以调用之前定义的层,并按照一定的顺序将它们组合起来。

2.3 示例

以下是一个简单的卷积神经网络(CNN)模型的定义示例:

import torch

import torch.nn as nn

class SimpleCNN(nn.Module):

def __init__(self, num_classes=10):

super(SimpleCNN, self).__init__()

self.conv1 = nn.Conv2d(3, 16, kernel_size=3, padding=1) # 输入通道3,输出通道16,卷积核大小3x3,padding=1

self.relu = nn.ReLU()

self.pool = nn.MaxPool2d(kernel_size=2, stride=2)

self.fc = nn.Linear(16 * 5 * 5, num_classes) # 假设输入图像大小为32x32,经过两次池化后大小为8x8,然后展平为16*5*5

def forward(self, x):

x = self.conv1(x)

x = self.relu(x)

x = self.pool(x)

x = x.view(-1, 16 * 5 * 5) # 展平操作

x = self.fc(x)

return x

三、训练过程

在定义了模型和数据集之后,就可以开始训练过程了。训练过程通常包括以下几个步骤:

3.1 初始化模型和优化器

首先,需要实例化模型并定义优化器。优化器用于调整模型的参数以最小化损失函数。PyTorch提供了多种优化器,如SGD、Adam等。

3.2 训练循环

训练过程是一个迭代过程,每个迭代称为一个epoch。在每个epoch中,需要遍历整个训练集,并对每个批次的数据进行前向传播、计算损失、反向传播和参数更新。

3.3 前向传播

在每个批次的数据上,将输入数据通过模型进行前向传播,得到预测值。这个过程中,模型会根据当前参数计算输出。

3.4 计算损失

使用损失函数计算预测值与实际值之间的差异。损失函数的选择取决于任务类型,如分类任务常用交叉熵损失,回归任务常用均方误差损失等。

3.5 反向传播

通过调用损失函数的.backward()方法,计算损失函数关于模型参数的梯度。这个过程中,PyTorch会自动进行链式法则的计算,将梯度传播回网络的每一层。

3.6 参数更新

使用优化器根据梯度更新模型的参数。在调用optimizer.step()之前,需要先用optimizer.zero_grad()清除之前累积的梯度,防止梯度累加导致更新方向偏离。

3.7 验证与测试

在每个epoch或每几个epoch后,可以在验证集或测试集上评估模型的性能。这有助于监控模型的训练过程,防止过拟合,并确定最佳的停止训练时间。

四、优化与调试

在训练过程中,可能需要对模型进行优化和调试,以提高其性能。以下是一些常见的优化和调试技巧:

4.1 学习率调整

学习率是优化过程中的一个重要超参数。如果学习率过高,可能会导致模型无法收敛;如果学习率过低,则训练过程会非常缓慢。可以使用学习率调度器(如ReduceLROnPlateau、CosineAnnealingLR等)来动态调整学习率。

4.2 权重初始化

权重初始化对模型的训练效果有很大影响。不恰当的初始化可能会导致梯度消失或爆炸等问题。PyTorch提供了多种权重初始化方法(如Xavier、Kaiming等),可以根据具体情况选择合适的初始化方式。

4.3 批量归一化

批量归一化(Batch Normalization, BN)是一种常用的加速深度网络训练的技术。通过在每个小批量数据上进行归一化操作,BN可以加快收敛速度,提高训练稳定性,并且有助于解决内部协变量偏移问题。

4.4 过拟合处理

过拟合是深度学习中常见的问题之一。为了防止过拟合,可以采取多种策略,如增加数据集的多样性、使用正则化技术(如L1、L2正则化)、采用dropout等。

4.5 调试与可视化

在训练过程中,可以使用PyTorch的调试工具和可视化库(如TensorBoard)来监控模型的训练状态。这有助于及时发现并解决问题,如梯度消失、梯度爆炸、学习率不合适等。

五、实际应用

PyTorch的灵活性和易用性使得它在许多领域都有广泛的应用,如计算机视觉、自然语言处理、强化学习等。在训练自己的数据集时,可以根据具体任务的需求选择合适的模型结构、损失函数和优化器,并进行充分的实验和调优。

此外,随着PyTorch生态的不断发展,越来越多的工具和库被开发出来,如torchvision、torchtext、torchaudio等,为开发者提供了更加便捷和高效的解决方案。这些工具和库不仅包含了预训练模型和常用数据集,还提供了丰富的API和文档支持,极大地降低了开发门槛和成本。

总之,使用PyTorch训练自己的数据集是一个涉及多个步骤和技巧的过程。通过深入理解PyTorch的基本概念、数据准备、模型定义、训练过程以及优化和调试等方面的知识,可以更加高效地构建和训练深度学习模型,并将其应用于实际问题的解决中。

-

数据集

+关注

关注

4文章

1208浏览量

24683 -

深度学习

+关注

关注

73文章

5497浏览量

121094 -

pytorch

+关注

关注

2文章

806浏览量

13191

发布评论请先 登录

相关推荐

Pytorch模型训练实用PDF教程【中文】

怎样使用PyTorch Hub去加载YOLOv5模型

利用 Python 和 PyTorch 处理面向对象的数据集(2)) :创建数据集对象

PyTorch如何训练自己的数据集

PyTorch如何训练自己的数据集

评论