卷积神经网络(Convolutional Neural Networks, CNNs)是深度学习中一种重要的神经网络结构,广泛应用于图像识别、语音识别、自然语言处理等领域。在卷积神经网络中,激活函数起着至关重要的作用,它们可以增加网络的非线性,提高网络的表达能力,使网络能够学习到更加复杂的特征。本文将详细介绍卷积神经网络中激活函数的作用、常见激活函数及其特点,以及激活函数在网络优化中的应用。

一、激活函数的作用

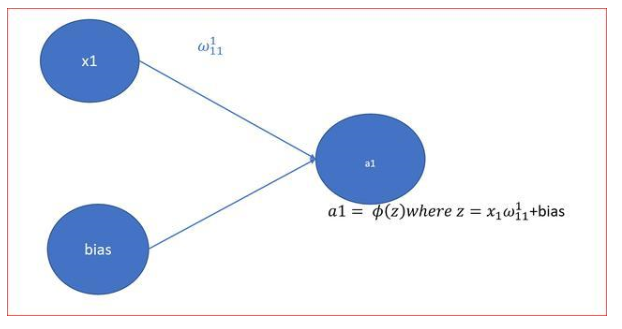

- 引入非线性 :激活函数的主要作用是引入非线性,使得神经网络能够学习到复杂的函数映射。如果没有激活函数,无论网络有多少层,最终都可以被简化为一个线性函数,这将大大限制网络的表达能力。

- 增加网络的表达能力 :通过激活函数,网络可以学习到更加复杂的特征,从而提高模型的性能。例如,在图像识别任务中,激活函数可以帮助网络学习到图像中的边缘、纹理等特征。

- 防止梯度消失或爆炸 :在训练过程中,如果梯度过小或过大,都会导致网络难以收敛。激活函数可以帮助缓解这个问题,例如ReLU激活函数可以避免梯度消失的问题。

- 提高模型的泛化能力 :激活函数可以帮助模型更好地泛化到新的数据上。例如,Sigmoid激活函数可以将输出压缩到0和1之间,使得模型的输出更加稳定。

二、常见激活函数及其特点

- Sigmoid函数 :

- 公式:

σ(x) = 1 / (1 + exp(-x)) - 特点:Sigmoid函数可以将输入压缩到0和1之间,具有S形曲线。但是,Sigmoid函数存在梯度消失的问题,即当输入非常大或非常小时,梯度接近0。

- Tanh函数 :

- 公式:

tanh(x) = (exp(x) - exp(-x)) / (exp(x) + exp(-x)) - 特点:Tanh函数将输入压缩到-1和1之间,具有双曲正切曲线。与Sigmoid函数相比,Tanh函数的输出中心化,可以加快收敛速度。但是,Tanh函数同样存在梯度消失的问题。

- ReLU函数 :

- 公式:

ReLU(x) = max(0, x) - 特点:ReLU函数在x大于0时输出x,小于0时输出0。ReLU函数可以有效地缓解梯度消失的问题,并且计算速度快。但是,ReLU函数存在死亡ReLU问题,即当输入小于0时,梯度为0,导致部分神经元不再更新。

- Leaky ReLU函数 :

- 公式:

LeakyReLU(x) = max(αx, x) - 特点:Leaky ReLU函数是ReLU函数的改进版本,当输入小于0时,以一个较小的正斜率输出。这样可以避免死亡ReLU问题,但是引入了一个超参数α,需要调整。

- Parametric ReLU(PReLU) :

- 公式:

PReLU(x) = max(α * x, x) - 特点:PReLU函数是Leaky ReLU函数的泛化,其中α是一个可学习的参数。这样可以使得模型自动学习α的最优值,提高模型的表达能力。

- Exponential Linear Unit(ELU) :

- 公式:

ELU(x) = x if x > 0 else α * (exp(x) - 1) - 特点:ELU函数在正数区域与ReLU函数相同,但是在负数区域,ELU函数的输出是负的,并且随着输入的减小而减小。这样可以使得负数区域的输出更加平滑,有助于缓解梯度消失的问题。

- Scaled Exponential Linear Unit(SELU) :

- 公式:

SELU(x) = λ * ELU(x) - 特点:SELU函数是ELU函数的自归一化版本,其中λ是一个常数。SELU函数具有自归一化的特性,可以保证网络的输出在训练过程中保持稳定。

- Softmax函数 :

- 公式:

Softmax(x_i) = exp(x_i) / Σ_j exp(x_j) - 特点:Softmax函数通常用于多分类问题中,将输入的向量转换为概率分布。Softmax函数可以将输入的任意实数值转换为0到1之间的概率值,并且所有概率值的和为1。

声明:本文内容及配图由入驻作者撰写或者入驻合作网站授权转载。文章观点仅代表作者本人,不代表电子发烧友网立场。文章及其配图仅供工程师学习之用,如有内容侵权或者其他违规问题,请联系本站处理。

举报投诉

-

神经网络

+关注

关注

42文章

4785浏览量

101281 -

非线性

+关注

关注

1文章

213浏览量

23158 -

函数

+关注

关注

3文章

4350浏览量

63062 -

卷积神经网络

+关注

关注

4文章

368浏览量

11935

发布评论请先 登录

相关推荐

【PYNQ-Z2申请】基于PYNQ的卷积神经网络加速

,得到训练参数2、利用开发板arm与FPGA联合的特性,在arm端实现图像预处理已经卷积核神经网络的池化、激活函数和全连接,在FPGA端实现卷积

发表于 12-19 11:37

卷积神经网络如何使用

卷积神经网络(CNN)究竟是什么,鉴于神经网络在工程上经历了曲折的历史,您为什么还会在意它呢? 对于这些非常中肯的问题,我们似乎可以给出相对简明的答案。

发表于 07-17 07:21

卷积神经网络模型发展及应用

卷积神经网络模型发展及应用转载****地址:http://fcst.ceaj.org/CN/abstract/abstract2521.shtml深度学习是机器学习和人工智能研究的最新趋势,作为一个

发表于 08-02 10:39

卷积神经网络简介:什么是机器学习?

,用于描述网络的方程中也有 32 个偏差和 32 个权重。CIFAR神经网络是一种广泛用于图像识别任务的CNN。它由两种主要类型的层组成:卷积层和池化层,它们在神经网络的训练中都发挥了

发表于 02-23 20:11

卷积神经网络结构

Learning)的应用,通过运用多层卷积神经网络结构,可以自动地进行特征提取和学习,进而实现图像分类、物体识别、目标检测、语音识别和自然语言翻译等任务。 卷积神经网络的结构包括:输

神经网络中激活函数的定义及类型

引言 神经网络是一种模拟人脑神经元结构的计算模型,广泛应用于图像识别、自然语言处理、语音识别等领域。在神经网络中,激活函数起着至关重要的

卷积神经网络的原理是什么

基本概念、结构、训练过程以及应用场景。 卷积神经网络的基本概念 1.1 神经网络 神经网络是一种受人脑神经元结构启发的数学模型,由大量的节点

bp神经网络和卷积神经网络区别是什么

结构、原理、应用场景等方面都存在一定的差异。以下是对这两种神经网络的比较: 基本结构 BP神经网络是一种多层前馈神经网络,由输入层、隐藏层和输出层组成。每个神经元之间通过权重连接,并通

卷积神经网络激活函数的作用

卷积神经网络激活函数的作用

评论