卷积神经网络(Convolutional Neural Network, CNN)是一种深度学习模型,广泛应用于图像识别、视频分析、自然语言处理等领域。本文将详细介绍卷积神经网络的计算过程和步骤。

- 卷积层(Convolutional Layer)

卷积层是卷积神经网络的核心组成部分,它通过卷积操作提取输入数据的特征。卷积操作是一种数学运算,用于计算输入数据与卷积核(或滤波器)之间的局部相关性。卷积层的计算过程如下:

1.1 初始化卷积核

在卷积层中,卷积核是一个小的矩阵,用于在输入数据上滑动以提取特征。卷积核的数量通常与输出通道的数量相同。每个卷积核负责提取输入数据的一种特征。

1.2 卷积操作

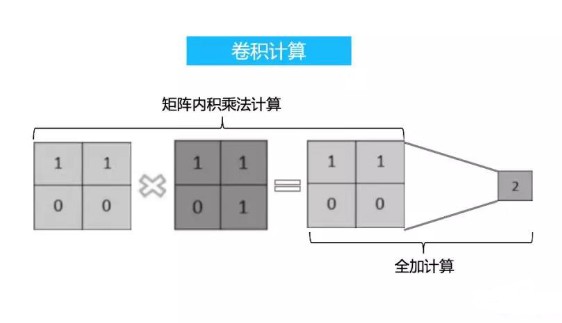

卷积操作包括以下步骤:

a. 将卷积核滑动到输入数据的第一个位置。

b. 计算卷积核与输入数据的局部区域之间的点积。

c. 将结果存储在输出特征图的一个位置。

d. 将卷积核向右滑动一个像素,重复步骤b和c,直到覆盖整个输入数据的宽度。

e. 将卷积核向下滑动一个像素,重复步骤a至d,直到覆盖整个输入数据的高度。

1.3 激活函数

在卷积操作之后,通常会应用一个非线性激活函数,如ReLU(Rectified Linear Unit),以引入非线性特性,增强模型的表达能力。

- 池化层(Pooling Layer)

池化层用于降低特征图的空间维度,减少参数数量,防止过拟合。常见的池化操作有最大池化(Max Pooling)和平均池化(Average Pooling)。

2.1 最大池化

最大池化操作是选择输入特征图的局部区域内的最大值作为输出。这有助于保留最重要的特征,同时减少数据量。

2.2 平均池化

平均池化操作是计算输入特征图的局部区域内所有值的平均值作为输出。这有助于平滑特征图,减少噪声。

- 全连接层(Fully Connected Layer)

全连接层是卷积神经网络的最后一层或接近最后一层,用于将特征图转换为最终的输出。在全连接层中,每个输入神经元都与每个输出神经元相连。

3.1 权重初始化

在全连接层中,权重矩阵需要进行初始化。常用的初始化方法有随机初始化、Xavier初始化和He初始化。

3.2 前向传播

在前向传播过程中,输入特征图通过权重矩阵和偏置向量进行线性变换,然后应用激活函数。

3.3 激活函数

常用的激活函数有Sigmoid、Tanh和ReLU。ReLU因其计算简单和训练速度快而被广泛使用。

- 损失函数(Loss Function)

损失函数用于衡量模型预测值与真实值之间的差异。常见的损失函数有均方误差(Mean Squared Error, MSE)、交叉熵(Cross-Entropy)等。

4.1 均方误差

均方误差是预测值与真实值之差的平方的平均值。它适用于回归问题。

4.2 交叉熵

交叉熵是预测概率分布与真实概率分布之间的差异度量。它适用于分类问题。

- 反向传播(Backpropagation)

反向传播是卷积神经网络训练过程中的关键步骤,用于计算损失函数关于网络参数的梯度。反向传播的过程如下:

5.1 计算梯度

从损失函数开始,逐层向上计算每个参数的梯度。

5.2 应用链式法则

在计算梯度时,使用链式法则将梯度从下一层传递到上一层。

5.3 更新参数

使用梯度下降或更高级的优化算法(如Adam、RMSprop等)更新网络参数。

- 正则化(Regularization)

正则化是防止模型过拟合的技术。常见的正则化方法有L1正则化、L2正则化和Dropout。

6.1 L1正则化

L1正则化通过在损失函数中添加参数的绝对值之和来惩罚大的参数值。

6.2 L2正则化

L2正则化通过在损失函数中添加参数的平方和来惩罚大的参数值。

6.3 Dropout

Dropout是一种随机丢弃网络中一部分神经元的技术,以防止网络对训练数据过度拟合。

-

图像识别

+关注

关注

9文章

520浏览量

38292 -

模型

+关注

关注

1文章

3268浏览量

48926 -

深度学习

+关注

关注

73文章

5507浏览量

121298 -

卷积神经网络

+关注

关注

4文章

367浏览量

11882

发布评论请先 登录

相关推荐

卷积神经网络计算过程和步骤

卷积神经网络计算过程和步骤

评论