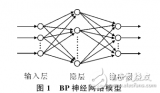

BP神经网络算法,即反向传播(Backpropagation)神经网络算法,是一种多层前馈神经网络,通过反向传播误差来训练网络权重。BP神经网络算法在许多领域都有广泛的应用,如图像识别、语音识别、自然语言处理等。本文将详细介绍BP神经网络算法的基本流程,包括网络结构、激活函数、前向传播、反向传播、权重更新和训练过程等。

- 网络结构

BP神经网络由输入层、隐藏层和输出层组成。输入层接收外部输入信号,隐藏层对输入信号进行非线性变换,输出层产生最终的输出结果。每个层由多个神经元组成,神经元之间的连接权重需要通过训练学习得到。

1.1 输入层

输入层的神经元数量与问题的特征维度相同。输入层的主要作用是将原始数据传递给隐藏层。

1.2 隐藏层

隐藏层是BP神经网络的核心部分,可以有多个。隐藏层的神经元数量可以根据问题的复杂性进行调整。隐藏层的主要作用是对输入信号进行非线性变换,提取特征信息。

1.3 输出层

输出层的神经元数量与问题的输出维度相同。输出层的主要作用是将隐藏层的输出结果转换为最终的输出结果。

- 激活函数

激活函数是BP神经网络中的关键组成部分,用于引入非线性特性,使网络能够学习复杂的函数映射。常见的激活函数有Sigmoid函数、Tanh函数和ReLU函数等。

2.1 Sigmoid函数

Sigmoid函数的数学表达式为:f(x) = 1 / (1 + e^(-x))。Sigmoid函数的输出范围在(0, 1)之间,具有平滑的曲线和连续的导数。

2.2 Tanh函数

Tanh函数的数学表达式为:f(x) = (e^x - e^(-x)) / (e^x + e^(-x))。Tanh函数的输出范围在(-1, 1)之间,具有零中心的特性。

2.3 ReLU函数

ReLU函数的数学表达式为:f(x) = max(0, x)。ReLU函数在x大于0时输出x,小于0时输出0。ReLU函数具有计算简单、训练速度快的优点。

- 前向传播

前向传播是BP神经网络算法的核心过程,包括输入信号的传递、激活函数的计算和输出结果的生成。

3.1 输入信号传递

输入信号首先传递到输入层,然后通过权重矩阵与输入层神经元的连接传递到隐藏层。

3.2 激活函数计算

隐藏层和输出层的神经元接收到输入信号后,通过激活函数进行非线性变换。激活函数的选择取决于问题的特点和网络结构。

3.3 输出结果生成

输出层的神经元接收到隐藏层的输出信号后,生成最终的输出结果。输出结果可以是分类标签、回归值或其他形式。

- 反向传播

反向传播是BP神经网络算法的关键步骤,用于计算网络误差并更新权重。

4.1 误差计算

首先,需要计算网络输出与真实值之间的误差。误差的计算方法取决于问题类型,如均方误差、交叉熵误差等。

4.2 误差反向传播

将误差从输出层反向传播到隐藏层,计算每个神经元的误差梯度。误差梯度的计算依赖于激活函数的导数。

4.3 权重更新

根据误差梯度和学习率,更新网络中所有连接的权重。权重更新的目的是最小化网络误差,提高预测精度。

- 权重更新方法

权重更新是BP神经网络算法的核心,常用的权重更新方法有梯度下降法、动量法和自适应学习率法等。

5.1 梯度下降法

梯度下降法是最基本的权重更新方法,通过计算误差梯度并乘以学习率来更新权重。梯度下降法简单易实现,但容易陷入局部最优解。

5.2 动量法

动量法在梯度下降法的基础上引入了动量项,可以加速权重的更新速度并减少震荡。动量法在训练过程中具有更好的收敛性能。

5.3 自适应学习率法

自适应学习率法根据网络的训练情况动态调整学习率,如AdaGrad、RMSProp和Adam等。自适应学习率法可以提高训练效率并避免陷入局部最优解。

-

图像识别

+关注

关注

9文章

520浏览量

38282 -

BP神经网络

+关注

关注

2文章

115浏览量

30560 -

语音识别

+关注

关注

38文章

1742浏览量

112697 -

输入信号

+关注

关注

0文章

458浏览量

12575

发布评论请先 登录

相关推荐

BP神经网络算法的基本流程包括

BP神经网络算法的基本流程包括

评论