循环神经网络(Recurrent Neural Network,简称RNN)是一种具有循环结构的神经网络,其核心思想是将前一个时间步的输出作为下一个时间步的输入,从而实现对序列数据的建模。本文将从循环神经网络的基本概念、循环机制、长短时记忆网络(LSTM)、门控循环单元(GRU)等方面进行介绍。

- 循环神经网络的基本概念

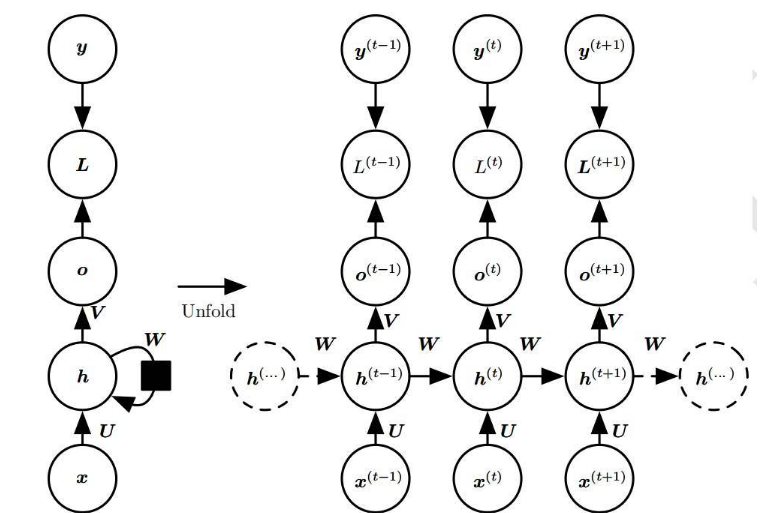

循环神经网络是一种时间序列模型,其基本思想是将序列数据中的每个元素(例如,单词、时间点等)作为输入,通过循环结构将前一个时间步的输出作为下一个时间步的输入,从而实现对序列数据的建模。循环神经网络的循环结构使得其能够捕捉序列数据中的长期依赖关系,从而在自然语言处理、语音识别等领域取得了广泛的应用。

1.1 循环神经网络的结构

循环神经网络的基本结构包括输入层、隐藏层和输出层。输入层负责接收序列数据中的每个元素,隐藏层负责对输入数据进行处理和传递,输出层负责生成最终的预测结果。循环神经网络的循环结构主要体现在隐藏层,隐藏层的神经元之间存在连接,使得前一个时间步的输出可以作为下一个时间步的输入。

1.2 循环神经网络的参数

循环神经网络的参数主要包括权重矩阵W、偏置向量b和激活函数。权重矩阵W用于将输入数据和前一个时间步的输出进行线性组合,偏置向量b用于对线性组合的结果进行平移,激活函数用于引入非线性,使得循环神经网络能够捕捉更复杂的序列数据特征。

- 循环机制

循环神经网络的循环机制是指将前一个时间步的输出作为下一个时间步的输入,从而实现对序列数据的建模。循环机制的实现主要依赖于隐藏层的循环结构和权重矩阵W。

2.1 隐藏层的循环结构

隐藏层的循环结构是指隐藏层的神经元之间存在连接,使得前一个时间步的输出可以作为下一个时间步的输入。这种循环结构使得循环神经网络能够捕捉序列数据中的长期依赖关系。

2.2 权重矩阵W

权重矩阵W用于将输入数据和前一个时间步的输出进行线性组合。在每个时间步,循环神经网络都会计算当前时间步的输入和前一个时间步的输出的线性组合,然后通过激活函数生成当前时间步的输出。权重矩阵W的引入使得循环神经网络能够学习序列数据中的模式和规律。

- 长短时记忆网络(LSTM)

长短时记忆网络(Long Short-Term Memory,简称LSTM)是一种特殊的循环神经网络,其核心思想是通过引入三个门(输入门、遗忘门和输出门)来控制信息的流动,从而解决传统循环神经网络在处理长序列数据时的梯度消失问题。

3.1 输入门

输入门负责控制当前时间步的输入数据进入细胞状态的程度。输入门的计算公式为:

it = σ(Wi * [ht-1, xt] + bi)

其中,σ表示sigmoid激活函数,Wi表示输入门的权重矩阵,ht-1表示前一个时间步的输出,xt表示当前时间步的输入,bi表示输入门的偏置。

3.2 遗忘门

遗忘门负责控制前一个时间步的细胞状态在当前时间步的保留程度。遗忘门的计算公式为:

ft = σ(Wf * [ht-1, xt] + bf)

其中,Wf表示遗忘门的权重矩阵,bf表示遗忘门的偏置。

3.3 细胞状态

细胞状态是LSTM的核心,用于存储和传递序列数据中的长期依赖信息。细胞状态的更新公式为:

ct = ft * ct-1 + it * tanh(Wc * [ht-1, xt] + bc)

其中,ct-1表示前一个时间步的细胞状态,Wc表示细胞状态的权重矩阵,bc表示细胞状态的偏置,tanh表示双曲正切激活函数。

3.4 输出门

输出门负责控制当前时间步的输出。输出门的计算公式为:

ot = σ(Wo * [ht-1, xt] + bo)

其中,Wo表示输出门的权重矩阵,bo表示输出门的偏置。

3.5 当前时间步的输出

当前时间步的输出计算公式为:

ht = ot * tanh(ct)

-

数据

+关注

关注

8文章

7048浏览量

89068 -

模型

+关注

关注

1文章

3248浏览量

48859 -

循环神经网络

+关注

关注

0文章

38浏览量

2971 -

自然语言处理

+关注

关注

1文章

618浏览量

13562

发布评论请先 登录

相关推荐

循环神经网络的基本概念

循环神经网络的基本概念

评论