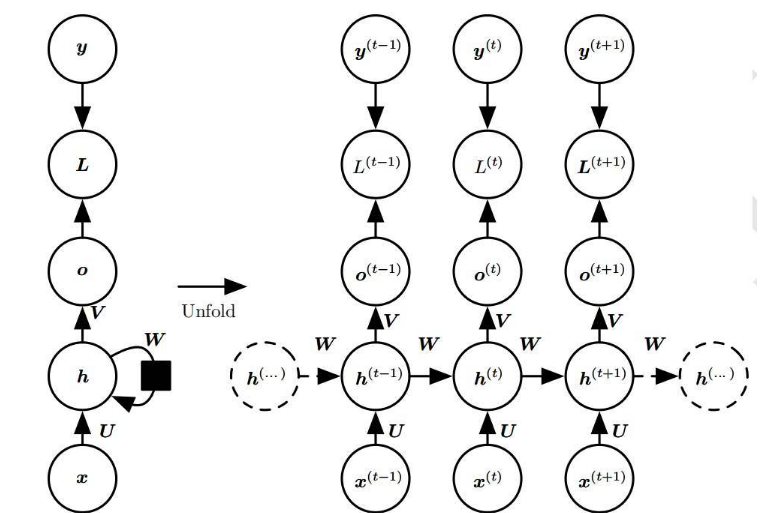

循环神经网络(Recurrent Neural Networks,简称RNN)是一种具有记忆功能的神经网络,它能够处理序列数据,如文本、语音和时间序列等。

- 梯度消失和梯度爆炸问题

RNN在训练过程中,由于其循环结构,梯度在反向传播时会经过多次乘法操作。这可能导致梯度在某些情况下变得非常小,即梯度消失问题,或者变得非常大,即梯度爆炸问题。这些问题会导致RNN的训练过程变得非常困难,甚至无法收敛。

- 长期依赖问题

RNN的一个重要特点是能够捕捉长距离的依赖关系。然而,在实际应用中,RNN往往难以捕捉超过一定时间步的依赖关系。这是因为在反向传播过程中,梯度会随着时间步的增加而逐渐衰减,导致RNN对长期依赖关系的学习能力受限。

- 参数数量较多

RNN的每个时间步都有一个权重矩阵,这导致其参数数量随着时间步的增加而线性增长。这不仅增加了模型的复杂度,而且也增加了训练的难度。此外,大量的参数也容易导致模型的过拟合问题。

- 训练速度较慢

由于RNN需要在每个时间步进行前向传播和反向传播,因此其训练速度相对较慢。特别是在处理长序列数据时,RNN的训练过程可能需要花费大量的时间。这限制了RNN在实时应用中的可行性。

- 难以并行计算

RNN的循环结构使得其在每个时间步的计算都依赖于前一个时间步的输出。这导致RNN难以实现并行计算,从而限制了其在大规模数据集上的应用。相比之下,卷积神经网络(Convolutional Neural Networks,简称CNN)等其他类型的神经网络可以更容易地实现并行计算。

- 难以捕捉局部特征

RNN的主要优势在于捕捉序列数据中的全局特征,但在捕捉局部特征方面表现不佳。这导致RNN在处理具有复杂局部结构的数据时,如图像和音频信号等,可能不如其他类型的神经网络,如CNN和循环卷积神经网络(Recurrent Convolutional Neural Networks,简称RCNN)等。

- 难以处理不规则序列

RNN通常假设输入序列具有固定的长度,但在实际应用中,很多序列数据的长度是不规则的。这使得RNN在处理这类数据时面临一定的困难。虽然可以通过填充(padding)和截断(truncation)等方法来处理不规则序列,但这些方法可能会影响模型的性能。

- 难以适应新的数据分布

RNN在训练完成后,其参数和权重矩阵是固定的。当面临新的数据分布时,RNN可能无法很好地适应这些变化。这导致RNN在实际应用中可能需要不断地进行重新训练,以适应新的数据分布。

- 难以解释和可视化

RNN的循环结构和大量的参数使得其模型的解释性和可视化变得非常困难。这限制了RNN在需要模型解释性的应用场景中的使用,如医疗诊断和金融风控等。

- 难以实现端到端的训练

RNN在某些任务中,如语音识别和机器翻译等,需要与其他模型(如声学模型和语言模型等)结合使用。这导致RNN难以实现端到端的训练,从而增加了模型的复杂性和训练难度。

总之,尽管RNN在处理序列数据方面具有独特的优势,但它仍然存在许多问题,如梯度消失和梯度爆炸、长期依赖问题、参数数量较多、训练速度较慢等。为了克服这些问题,研究人员提出了许多改进的RNN模型,如长短时记忆网络(Long Short-Term Memory,简称LSTM)和门控循环单元(Gated Recurrent Unit,简称GRU)等。

-

数据

+关注

关注

8文章

7017浏览量

89005 -

参数

+关注

关注

11文章

1833浏览量

32209 -

语音识别

+关注

关注

38文章

1739浏览量

112651 -

循环神经网络

+关注

关注

0文章

38浏览量

2969

发布评论请先 登录

相关推荐

循环神经网络的缺点是存在什么问题

循环神经网络的缺点是存在什么问题

评论