Keras是一个高级深度学习库,它提供了一个易于使用的接口来构建和训练深度学习模型。Keras是基于TensorFlow、Theano或CNTK等底层计算库构建的。以下是Keras的模块结构的介绍:

- 简介

Keras是一个开源的深度学习库,由François Chollet于2015年创建。Keras的目标是提供一个简单、灵活且易于使用的接口,以便用户可以快速构建和训练深度学习模型。Keras支持多种深度学习框架,如TensorFlow、Theano和CNTK。

- 安装

要使用Keras,首先需要安装它。Keras可以通过pip或conda进行安装。以下是安装Keras的步骤:

- 安装Python:Keras需要Python 3.5-3.8版本。

- 安装TensorFlow或Theano:Keras需要一个后端计算库。TensorFlow是推荐的选择。

- 安装Keras:使用pip或conda安装Keras。

- 核心概念

在使用Keras之前,需要了解一些核心概念,包括:

- 模型(Model):模型是Keras中的基本单元,用于定义和训练深度学习模型。

- 层(Layer):层是模型的构建块,用于定义模型中的单个操作。

- 激活函数(Activation Function):激活函数用于在神经网络中引入非线性。

- 损失函数(Loss Function):损失函数用于衡量模型预测与真实标签之间的差异。

- 优化器(Optimizer):优化器用于更新模型的权重,以最小化损失函数。

- 模型构建

Keras提供了两种模型构建方式:顺序模型(Sequential Model)和函数式API(Functional API)。

- 顺序模型:顺序模型是一种线性堆叠的模型构建方式,适用于简单的神经网络结构。

- 函数式API:函数式API提供了更灵活的模型构建方式,适用于复杂的神经网络结构。

- 层

Keras提供了多种类型的层,包括:

- 密集层(Dense Layer):用于构建全连接的神经网络层。

- 卷积层(Convolutional Layer):用于处理图像数据的卷积操作。

- 池化层(Pooling Layer):用于降低特征图的维度,减少计算量。

- 循环层(Recurrent Layer):用于处理序列数据的循环神经网络层。

- 归一化层(Normalization Layer):用于对输入数据进行归一化处理。

- 激活函数

Keras提供了多种激活函数,包括:

- ReLU(Rectified Linear Unit):一种常用的激活函数,用于引入非线性。

- Sigmoid:用于二分类问题的激活函数。

- Tanh:双曲正切激活函数,用于引入非线性。

- Softmax:用于多分类问题的激活函数。

- 损失函数

Keras提供了多种损失函数,包括:

- 均方误差(Mean Squared Error):用于回归问题。

- 交叉熵(Categorical Crossentropy):用于多分类问题。

- 二元交叉熵(Binary Crossentropy):用于二分类问题。

- 优化器

Keras提供了多种优化器,包括:

Keras提供了多种回调函数,用于在训练过程中执行特定的操作,如保存模型、提前停止训练等。常见的回调函数包括:

- ModelCheckpoint:用于在训练过程中保存模型。

- EarlyStopping:用于提前停止训练,以防止过拟合。

- ReduceLROnPlateau:在训练过程中减少学习率。

- 数据预处理

Keras提供了数据预处理工具,用于对输入数据进行预处理,包括:

- ImageDataGenerator:用于图像数据的预处理。

- Sequence:用于序列数据的预处理。

- 模型评估与预测

Keras提供了模型评估和预测的方法,包括:

- evaluate:用于评估模型的性能。

- predict:用于对新数据进行预测。

- 模型保存与加载

Keras提供了模型保存和加载的方法,以便在训练完成后保存模型,并在需要时加载模型进行预测或继续训练。

以下是一个使用Keras构建和训练简单神经网络的示例:

from keras.models import Sequential

from keras.layers import Dense

# 创建顺序模型

model = Sequential()

# 添加层

model.add(Dense(64, activation='relu', input_shape=(100,)))

model.add

-

模块

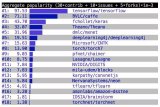

+关注

关注

7文章

2716浏览量

47543 -

接口

+关注

关注

33文章

8620浏览量

151321 -

深度学习

+关注

关注

73文章

5504浏览量

121247 -

keras

+关注

关注

2文章

20浏览量

6087

发布评论请先 登录

相关推荐

Keras之ML~P:基于Keras中建立的回归预测的神经网络模型

Keras之ML~P:基于Keras中建立的简单的二分类问题的神经网络模型

为什么无法加载keras模型?

keras常用的损失函数Losses与评价函数Metrics介绍

keras顺序模型与函数式模型

keras可视化介绍

到底该选择TensorFlow还是Keras深度学习框架选型指南

基于Keras搭建的深度学习网络示例

Keras和TensorFlow究竟哪个会更好?

TensorFlow和Keras哪个更好用?

基于TensorFlow和Keras的图像识别

keras的模块结构介绍

keras的模块结构介绍

评论