引言

自然语言处理(Natural Language Processing, NLP)作为人工智能领域的一个重要分支,旨在让计算机能够理解和处理人类语言。随着深度学习技术的兴起,前馈神经网络(Feedforward Neural Networks, FNN)作为深度学习的一种基本形式,在NLP中发挥着越来越重要的作用。本文将从前馈神经网络的基本原理、结构特点出发,详细探讨其在NLP中的应用场景、优势以及面临的挑战,并展望其未来的发展方向。

一、前馈神经网络的基本原理与结构特点

前馈神经网络是一种最基本的神经网络结构,其信息流只能从输入层到输出层单向传播,不能在网络中形成闭环。FNN通常由输入层、一个或多个隐藏层以及输出层组成。信息在FNN中从输入层经过隐藏层逐层向前传播,最终到达输出层。在每个神经元中,输入的加权和经过激活函数后得到输出,作为下一层的输入。

FNN的核心在于其强大的特征学习和表示能力。通过多层神经元的非线性变换和特征提取,FNN能够自动学习输入数据的复杂特征,并将其映射到输出层,实现对未知数据的预测和分类。此外,FNN还具有计算速度快、易于实现和训练等优点,适用于处理高维数据,如文本数据。

二、前馈神经网络在自然语言处理中的应用场景

- 文本分类

文本分类是NLP中的一项基础任务,旨在将文本数据划分为预定义的类别。FNN在文本分类中发挥着重要作用,特别是在情感分析、主题分类等领域。通过将文本数据转换为向量表示,FNN能够学习文本数据的特征,并将其映射到不同的类别中。例如,在情感分析中,FNN可以学习文本的词向量表示和语义信息,自动将文本分类为正面、负面或中性情感倾向。 - 命名实体识别(Named Entity Recognition, NER)

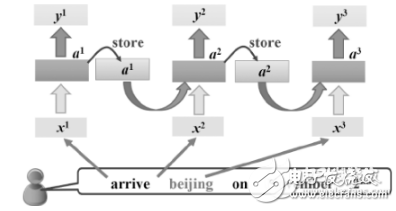

NER是NLP中的另一项重要任务,旨在从文本中识别出具有特定意义的实体,如人名、地名、机构名等。FNN在NER任务中同样表现出色。通过学习文本中的实体边界和类型信息,FNN能够准确识别出文本中的实体,为后续的NLP任务提供有力支持。 - 机器翻译

虽然FNN在机器翻译任务中不如循环神经网络(RNN)和变压器(Transformer)等模型表现突出,但在某些特定的翻译任务中,FNN仍然可以发挥一定的作用。通过学习源语言和目标语言之间的映射关系,FNN能够实现简单的翻译任务,为更复杂的翻译模型提供基础。 - 问答系统

问答系统是NLP中的一个高级应用,旨在回答用户提出的问题。FNN在问答系统中可以用于理解用户的问题,并从大量文本数据中提取相关信息来生成答案。通过学习问题的语义和上下文信息,FNN能够更准确地理解用户意图,并生成更相关的答案。 - 文本生成

文本生成是NLP中的一个挑战性任务,旨在生成符合语法和语义规则的文本。FNN在文本生成中也有一定的应用,如生成式对抗网络(GAN)中的生成器部分就可以采用FNN结构。通过学习大量文本数据的特征,FNN能够生成与输入文本相似或具有特定风格的文本。

三、前馈神经网络在自然语言处理中的优势

- 强大的特征学习和表示能力

FNN通过多层神经元的非线性变换和特征提取,能够自动学习输入数据的复杂特征,并将其表示为向量形式。这种向量表示不仅便于计算,而且能够捕捉文本之间的相似性和差异性,为后续的NLP任务提供有力的支持。 - 计算速度快

由于FNN的信息流是单向传播的,没有反馈机制,因此其计算速度相对较快。这使得FNN适用于处理大规模文本数据,特别是在实时应用场景中表现出色。 - 易于实现和训练

FNN的结构相对简单,易于实现和训练。这使得研究者可以更快地搭建和测试模型,加速NLP领域的研究进展。

四、前馈神经网络在自然语言处理中面临的挑战

- 无法捕捉序列中的时间依赖关系

FNN在处理序列数据(如文本)时,无法捕捉序列中的时间依赖关系。这意味着FNN在处理长文本或具有复杂结构的文本时可能会表现不佳。为了克服这一局限性,研究者们提出了循环神经网络(RNN)和变压器(Transformer)等模型来更好地处理序列数据。 - 对文本数据的长度和结构敏感

FNN对文本数据的长度和结构较为敏感。当文本数据的长度或结构发生变化时,FNN的性能可能会受到影响。因此,在使用FNN处理文本数据时,需要对文本数据进行适当的预处理和标准化操作。 - 需要大量标注数据进行监督学习

FNN在处理文本数据时通常需要大量的标注数据进行监督学习。然而,在实际应用中,高质量的标注数据往往难以获得,这限制了FNN在某些场景下的应用。为了缓解这一问题,研究者们探索了半监督学习、无监督学习以及迁移学习等方法,以减少对标注数据的依赖。

五、前馈神经网络在自然语言处理中的创新与发展

尽管FNN在NLP中面临一些挑战,但研究者们通过不断的创新与发展,提出了多种改进方法,以增强FNN在NLP任务中的表现。

- 结合卷积神经网络(CNN)

为了克服FNN在捕捉文本局部特征方面的不足,研究者们将卷积神经网络(CNN)与前馈神经网络相结合。CNN通过卷积和池化操作,能够有效地提取文本中的局部特征,如n-gram特征、词嵌入特征等。将CNN的输出作为FNN的输入,可以充分利用CNN的局部特征提取能力和FNN的全局特征学习能力,提升模型在文本分类、情感分析等任务中的性能。 - 注意力机制

注意力机制是一种模拟人类注意力行为的技术,它允许模型在处理文本时自动关注重要的部分,忽略不重要的部分。将注意力机制引入FNN中,可以使模型更加关注与任务相关的关键信息,提高模型的准确性和鲁棒性。例如,在文本分类任务中,注意力机制可以帮助FNN更加关注文本中的关键词或句子,从而做出更准确的分类决策。 - 预训练模型

随着计算能力的提升和大数据的积累,预训练模型在NLP中变得越来越流行。预训练模型通过在大规模语料库上进行无监督学习,获得了丰富的语言知识和表示能力。将预训练模型的输出作为FNN的输入或嵌入层,可以显著提升FNN在NLP任务中的表现。例如,BERT、GPT等预训练模型已经成为许多NLP任务中的基础工具,它们为FNN等模型提供了强大的语言表示能力。 - 混合模型

为了充分利用不同模型的优点,研究者们还提出了混合模型的概念。混合模型通过组合不同类型的神经网络(如FNN、RNN、CNN等),以及引入额外的机制(如注意力机制、记忆网络等),来实现更复杂的NLP任务。混合模型可以综合不同模型的特长,提高整体性能。例如,在机器翻译任务中,可以结合FNN的局部特征提取能力和RNN的序列建模能力,构建出性能更优的翻译模型。

六、未来展望

随着深度学习技术的不断发展,前馈神经网络在NLP中的应用前景将更加广阔。未来,我们可以期待以下几个方面的进展:

- 更高效的模型架构 :研究者们将继续探索更加高效、紧凑的模型架构,以减少计算资源的需求,提高模型的运行效率。

- 更丰富的语言表示 :随着预训练模型的不断发展,我们将能够获得更加丰富、细致的语言表示,为NLP任务提供更加有力的支持。

- 更广泛的应用场景 :随着NLP技术的普及和深入应用,FNN等深度学习模型将在更多领域发挥重要作用,如智能客服、智能写作、智能医疗等。

- 更强大的跨模态处理能力 :未来,FNN等深度学习模型将不仅仅局限于文本处理,还将与图像、语音等其他模态的数据进行融合,实现跨模态的理解和生成。

总之,前馈神经网络作为深度学习的一种基本形式,在NLP中发挥着重要作用。通过不断的创新与发展,FNN将在更多领域展现其独特的魅力和价值。

-

神经网络

+关注

关注

42文章

4762浏览量

100535 -

人工智能

+关注

关注

1791文章

46845浏览量

237537 -

自然语言处理

+关注

关注

1文章

612浏览量

13504

发布评论请先 登录

相关推荐

RNN在自然语言处理中的应用

前馈神经网络在自然语言处理中的应用

前馈神经网络在自然语言处理中的应用

评论