在深度学习的广阔领域中,模型训练的核心目标之一是实现对未知数据的准确预测。然而,在实际应用中,我们经常会遇到一个问题——过拟合(Overfitting)。过拟合是指模型在训练数据上表现优异,但在测试数据或新数据上表现不佳的现象。为了解决这个问题,正则化(Regularization)技术应运而生,成为深度学习中不可或缺的一部分。本文将从过拟合的原因、表现、正则化的原理、方法及其在深度学习中的应用等方面展开详细论述。

一、过拟合的原因与表现

1.1 过拟合的原因

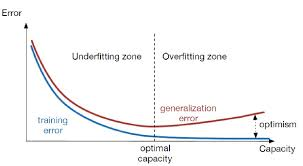

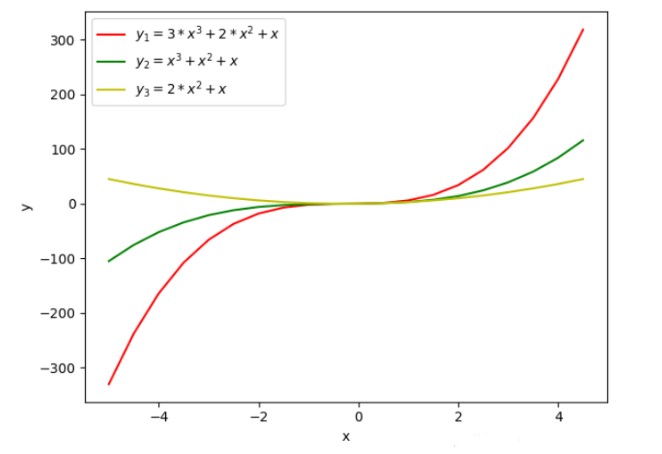

过拟合的主要原因可以归结为模型复杂度与数据复杂度之间的不匹配。当模型复杂度远高于数据复杂度时,模型会过度拟合训练数据中的噪声和细节,而忽略了数据的真实分布规律。具体来说,过拟合的原因包括但不限于以下几点:

- 训练数据不足 :当训练数据量较少时,模型容易学习到训练数据的特有特征而非泛化特征。

- 模型参数过多 :模型参数过多会导致模型具有过强的拟合能力,容易捕捉到训练数据中的噪声。

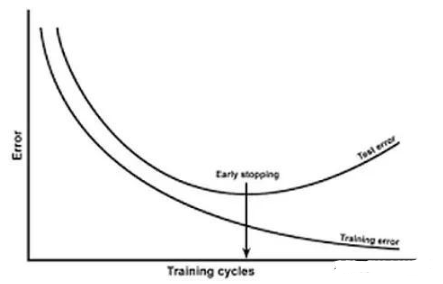

- 学习时间过长 :在训练过程中,如果迭代次数过多,模型可能会过度拟合训练数据。

- 特征选择不当 :选择了一些对模型预测没有实质性帮助的特征,增加了模型的复杂度。

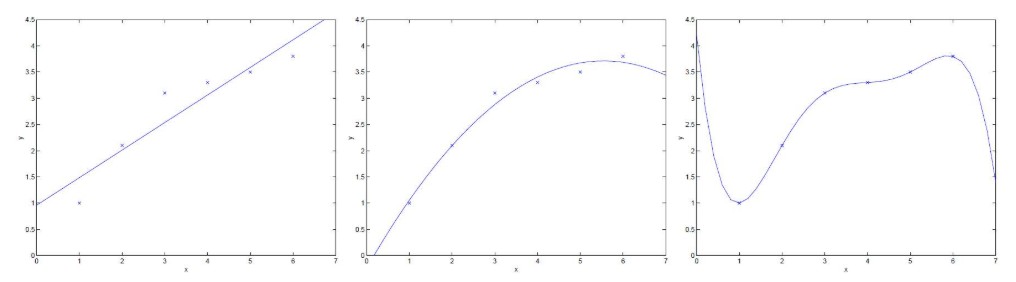

1.2 过拟合的表现

过拟合的直观表现是模型在训练集上的准确率非常高,甚至接近100%,但在测试集或新数据上的准确率却大幅下降。这表明模型已经记住了训练数据的细节,而无法泛化到新的数据上。此外,过拟合的模型通常具有复杂的决策边界,这些边界能够精确划分训练数据,但在实际应用中却缺乏鲁棒性。

二、正则化的原理与方法

2.1 正则化的原理

正则化的基本思想是在损失函数中加入一个与模型复杂度相关的正则项,从而控制模型的复杂度,防止其过度拟合训练数据。正则项通常是对模型参数的一种约束,旨在使模型参数在训练过程中保持较小的值。这样,即使模型在训练数据上有所波动,也不会对整体预测结果产生太大影响,从而提高模型的泛化能力。

2.2 正则化的方法

正则化的方法多种多样,根据正则项的不同可以分为L1正则化、L2正则化、Dropout等。

- L1正则化 :L1正则化通过在损失函数中加入模型参数的绝对值之和作为正则项来约束模型复杂度。L1正则化倾向于产生稀疏的权值矩阵,即许多参数会变为0,这有助于减少模型的复杂度并提高泛化能力。此外,L1正则化还具有特征选择的作用,可以自动剔除对模型预测没有实质性帮助的特征。

- L2正则化 :L2正则化通过在损失函数中加入模型参数的平方和作为正则项来约束模型复杂度。与L1正则化不同,L2正则化不会使参数变为0,而是使参数值趋于接近0。这有助于减少模型的过拟合风险,同时保持模型的平滑性。L2正则化在深度学习中应用广泛,特别是在卷积神经网络(CNN)和全连接网络(FCN)中。

- Dropout :Dropout是一种特殊的正则化方法,它通过在训练过程中随机丢弃神经网络中的一部分神经元来防止过拟合。具体来说,在每次迭代中,以一定的概率将神经网络中的某些神经元置为0(即丢弃这些神经元),然后仅使用剩余的神经元进行前向传播和反向传播。这种方法可以减少神经元之间的共适应(co-adaptation),即避免某些神经元过度依赖其他神经元的信息,从而提高模型的泛化能力。Dropout在深度学习领域的应用非常广泛,特别是在深度神经网络(DNN)和循环神经网络(RNN)中。

三、正则化在深度学习中的应用

3.1 在卷积神经网络中的应用

在卷积神经网络(CNN)中,正则化方法的应用尤为重要。由于CNN通常包含大量的卷积层和全连接层,模型参数数量庞大,容易出现过拟合现象。因此,在训练CNN时,通常会采用L2正则化、Dropout等方法来防止过拟合。此外,数据增强(如图像旋转、缩放、裁剪等)也是一种有效的正则化手段,可以增加训练数据的多样性,提高模型的泛化能力。

3.2 在循环神经网络中的应用

在循环神经网络(RNN)中,过拟合问题同样不容忽视。由于RNN在处理序列数据时容易学习到数据中的长期依赖关系,因此也容易受到噪声和异常值的影响。为了解决这个问题,研究者们提出了多种正则化方法,如L2正则化、Dropout等。特别是在长短期记忆网络(LSTM)和门控循环单元(GRU)等改进的RNN模型中,正则化方法的应用更加广泛。

3.3 Dropout的应用细节

在Dropout的应用中,有几个关键点需要注意。首先,Dropout通常应用于全连接层(Dense层),而在卷积层(Convolutional层)中则较少使用,因为卷积层中的参数数量相对较少,且卷积操作本身具有一定的正则化效果。其次,Dropout的比例(即丢弃神经元的概率)是一个重要的超参数,需要根据具体情况进行调整。一般来说,较大的Dropout比例可以更有效地防止过拟合,但也可能导致模型欠拟合;反之,较小的Dropout比例则可能无法充分抑制过拟合。因此,在实际应用中,通常需要通过交叉验证等方法来确定最佳的Dropout比例。

3.4 正则化与模型优化的结合

正则化不仅仅是防止过拟合的一种手段,还可以与模型优化算法相结合,进一步提高模型的性能。例如,在训练深度学习模型时,通常会采用梯度下降(Gradient Descent)或其变种(如Adam、RMSprop等)作为优化算法。这些算法通过不断迭代更新模型的参数来最小化损失函数。在这个过程中,正则化项可以被视为损失函数的一部分,通过调整正则化项的权重来平衡模型在训练集上的表现和在测试集上的泛化能力。因此,正则化与模型优化的结合是深度学习模型训练过程中不可或缺的一部分。

四、过拟合与正则化的挑战与未来展望

4.1 挑战

尽管正则化技术在防止过拟合方面取得了显著成效,但在实际应用中仍面临一些挑战。首先,正则化方法的选择和参数设置需要依赖大量的实验和经验积累,缺乏统一的标准和理论指导。其次,随着深度学习模型的复杂度和规模的不断增加,正则化方法的效果可能会受到限制。例如,在极大规模的神经网络中,简单的L2正则化或Dropout可能无法有效防止过拟合。此外,正则化方法的选择和参数设置也可能受到计算资源和时间成本的限制。

4.2 未来展望

为了应对这些挑战并进一步提高深度学习模型的性能,研究者们正在不断探索新的正则化方法和策略。一方面,研究者们致力于开发更加高效、自适应的正则化方法,以更好地适应不同场景和任务的需求。例如,一些研究者提出了自适应Dropout(Adaptive Dropout)等方法,可以根据模型训练过程中的表现动态调整Dropout的比例。另一方面,研究者们也在探索将正则化方法与深度学习模型的其他方面相结合的新途径。例如,将正则化方法与深度学习模型的架构搜索(Architecture Search)相结合,通过自动化地搜索最优的模型架构和正则化策略来进一步提高模型的性能。

五、结论

过拟合是深度学习中一个常见且重要的问题,它限制了模型在实际应用中的泛化能力。正则化作为防止过拟合的一种有效手段,在深度学习模型的训练过程中发挥着重要作用。通过合理选择和调整正则化方法及其参数设置,可以显著降低模型的过拟合风险并提高其泛化能力。然而,正则化方法的选择和参数设置仍面临一些挑战和限制。未来随着深度学习技术的不断发展和完善,我们期待看到更多高效、自适应的正则化方法和策略的出现,以进一步推动深度学习技术的发展和应用。

-

模型

+关注

关注

1文章

3032浏览量

48359 -

深度学习

+关注

关注

73文章

5422浏览量

120592

发布评论请先 登录

相关推荐

机器学习基础知识 包括评估问题,理解过拟合、欠拟合以及解决问题的技巧

深度学习中过拟合/欠拟合的问题及解决方案

过拟合的概念和用几种用于解决过拟合问题的正则化方法

深度学习中过拟合、欠拟合问题及解决方案

深度学习模型中的过拟合与正则化

深度学习模型中的过拟合与正则化

评论