引言

在自然语言处理(NLP)领域,Transformer模型以其卓越的性能和广泛的应用前景,成为了近年来最引人注目的技术之一。Transformer模型由谷歌在2017年提出,并首次应用于神经机器翻译任务,随后迅速扩展到其他NLP任务中,如文本生成、语言理解、问答系统等。本文将详细介绍Transformer语言模型的原理、特点、优势以及实现过程。

一、Transformer模型原理

1.1 模型结构

Transformer模型是一种基于自注意力机制的编码器-解码器(Encoder-Decoder)结构。它完全摒弃了传统的循环神经网络(RNN)和卷积神经网络(CNN)中的序列依赖性,通过自注意力机制实现了对序列数据的全局建模。Transformer模型由多个编码器(Encoder)和解码器(Decoder)堆叠而成,每个编码器和解码器又由多个Transformer Block组成。

1.2 编码器(Encoder)

编码器的主要功能是将输入序列转换为一系列隐藏状态,这些隐藏状态将作为解码器的输入。每个编码器包含两个子层:自注意力层(Self-Attention Layer)和前馈神经网络层(Feed Forward Neural Network Layer)。自注意力层用于计算序列中每个位置与其他位置的关系,使得模型能够捕捉到序列内部的依赖关系。前馈神经网络层则用于对自注意力层的输出进行进一步处理,并引入非线性变换。

1.3 解码器(Decoder)

解码器负责根据编码器的输出生成目标序列。与编码器类似,解码器也包含自注意力层和前馈神经网络层,但增加了一个额外的注意力层——编码器-解码器注意力层(Encoder-Decoder Attention Layer)。这个层用于计算解码器当前位置与编码器所有位置之间的关系,从而帮助解码器在生成目标序列时参考输入序列的信息。

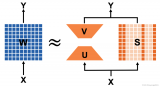

1.4 自注意力机制(Self-Attention Mechanism)

自注意力机制是Transformer模型的核心。它通过计算序列中每个位置与其他位置之间的注意力权重,来捕捉序列内部的依赖关系。具体来说,自注意力机制首先计算查询(Query)、键(Key)和值(Value)三个矩阵,然后通过缩放点积注意力(Scaled Dot-Product Attention)机制计算注意力权重,并将这些权重应用于值矩阵上,得到加权和作为输出。

二、Transformer模型的优点

2.1 并行性

相比于RNN,Transformer模型能够在所有位置同时计算,充分利用了GPU的并行计算能力,从而加速了模型的训练和推理过程。

2.2 长距离依赖

传统的RNN模型在处理长序列时容易出现梯度消失和梯度爆炸的问题,难以捕捉长距离依赖关系。而Transformer模型通过自注意力机制能够同时考虑所有位置的信息,从而更好地处理长序列。

2.3 性能表现

在自然语言处理领域中,Transformer模型已经取得了许多重要的研究成果。它在机器翻译、文本生成、语言模型等任务中都取得了很好的效果,并在多项基准测试中刷新了记录。

三、Transformer模型的实现过程

3.1 数据预处理

在训练Transformer模型之前,需要对输入数据进行预处理。这通常包括分词(Tokenization)、构建词汇表(Vocabulary)、添加位置编码(Positional Encoding)等步骤。分词是将文本转换为一系列单词或子词单元的过程;词汇表则用于将单词或子词单元映射为唯一的索引;位置编码则是为了向模型提供单词在序列中的位置信息。

3.2 模型构建

模型构建是Transformer模型实现的核心部分。它通常包括以下几个步骤:

- 初始化参数 :设置模型的超参数,如编码器和解码器的层数、隐藏层的大小、注意力头的数量等。

- 构建编码器 :根据设定的超参数构建编码器层,每个编码器层包含自注意力层、前馈神经网络层以及残差连接和层归一化(Layer Normalization)操作。

- 构建解码器 :解码器的构建过程与编码器类似,但增加了编码器-解码器注意力层。

- 嵌入层 :将分词后的单词转换为嵌入向量,并与位置编码相加,得到模型的输入。

3.3 训练过程

训练Transformer模型通常采用无监督的方式进行预训练,然后再进行有监督的微调。在预训练过程中,通常使用自编码器(Autoencoder)或掩码语言模型(Masked Language Model)等方式进行训练,目标是学习输入序列的表示。在微调过程中,则使用有监督的数据集进行训练,例如在机器翻译任务中,使用平行语料库进行训练,学习将输入序列映射到目标序列的映射关系。

训练过程通常包括以下几个步骤:

- 前向传播 :将输入数据送入模型,计算模型的输出。

- 计算损失 :根据输出和真实标签计算损失函数,如交叉熵损失。

- 反向传播 :通过链式法则计算损失函数对模型参数的梯度。在Transformer模型中,由于自注意力机制和前馈神经网络的复杂性,梯度的计算也相应变得复杂,需要仔细设计以保证计算的高效和准确。

- 参数更新 :利用梯度下降(或其变体,如Adam优化器)更新模型的参数,以最小化损失函数。在训练过程中,通常会采用学习率衰减、梯度裁剪等技术来稳定训练过程,防止模型过拟合或梯度爆炸。

3.4 模型评估与调优

在训练完成后,需要对模型进行评估以验证其性能。评估通常包括在测试集上计算各种性能指标,如准确率、召回率、F1分数等。此外,还可以通过可视化技术(如注意力权重可视化)来深入理解模型的工作机制,发现潜在的问题并进行调优。

调优是一个迭代的过程,可能包括调整模型的超参数(如学习率、隐藏层大小、注意力头数量等)、修改模型结构(如增加或减少层数)、使用不同的优化算法等。通过不断尝试和调整,可以逐步提升模型的性能。

四、Transformer模型的应用

Transformer模型因其强大的表示能力和广泛的应用前景,在NLP领域得到了广泛的关注和应用。以下是一些典型的应用场景:

- 机器翻译 :Transformer模型最初就是为解决机器翻译问题而设计的,并在多个翻译任务中取得了优异的性能。

- 文本生成 :利用Transformer模型可以生成连贯、流畅的文本,如文章摘要、诗歌创作、对话生成等。

- 语言理解 :Transformer模型在情感分析、命名实体识别、问答系统等语言理解任务中也表现出色。

- 多模态任务 :通过将Transformer模型与图像、音频等其他模态的数据结合,可以实现跨模态的任务,如图像描述生成、视频字幕生成等。

五、结论与展望

Transformer模型作为NLP领域的一项重大突破,以其独特的自注意力机制和高效的并行计算能力,为自然语言处理任务提供了强大的支持。随着技术的不断发展和应用的深入拓展,Transformer模型将在更多领域发挥重要作用,并推动人工智能技术的进一步发展。

未来,我们可以期待Transformer模型在以下几个方面取得更多的进展:

- 模型优化 :通过改进模型结构、优化训练算法等方式,进一步提升Transformer模型的性能和效率。

- 多模态融合 :加强Transformer模型与其他模态数据的融合能力,实现更加全面的多模态理解和生成。

- 可解释性增强 :提升Transformer模型的可解释性,使得其决策过程更加透明和可理解,从而增强用户对其的信任度。

- 低资源语言处理 :探索如何在低资源语言环境下有效训练和应用Transformer模型,以推动自然语言处理技术的全球化普及。

总之,Transformer模型作为自然语言处理领域的重要基石,将继续引领着技术的发展和应用的拓展。我们期待着未来更多的创新和突破,为人类社会带来更加智能和便捷的服务。

-

语言模型

+关注

关注

0文章

527浏览量

10287 -

Transformer

+关注

关注

0文章

143浏览量

6017 -

自然语言处理

+关注

关注

1文章

618浏览量

13573

发布评论请先 登录

相关推荐

如何计算transformer模型的参数量

大语言模型背后的Transformer,与CNN和RNN有何不同

【大语言模型:原理与工程实践】探索《大语言模型原理与工程实践》

【大语言模型:原理与工程实践】大语言模型的基础技术

大语言模型:原理与工程时间+小白初识大语言模型

如何更改ABBYY PDF Transformer+界面语言

超大Transformer语言模型的分布式训练框架

基于Transformer的大型语言模型(LLM)的内部机制

transformer模型详解:Transformer 模型的压缩方法

Transformer语言模型简介与实现过程

Transformer语言模型简介与实现过程

评论