AI一天,人间一年。

现在不论是大模型本身,亦或是AI应用的更新速度简直令人直呼跟不上——

Sora、Suno、Udio、Luma……重磅应用一个接一个问世。

也正如来自InfoQ的调查数据显示的那般,虽然AIGC目前还处于起步阶段,但市场规模已初具雏形:

行业整体迅速发展固然是好事,但具体到每个的应用或者大模型的落地来说,面临的竞争也越发激烈了。

例如前不久各个大模型厂商之间展开的非常激烈的“价格战”,主打一个比谁更便宜,甚至直接把大模型价格推向“厘时代”。

加上最近OpenAI的“断供”事件,更是让国内厂商们在打出“轻松搬家”计划的同时,再加码Tokens送送送的力度。

究其原因,也是与当下应用为王,尤其是以尽量低的成本把业务快速落地的这一大趋势紧密相关。

那么问题来了,大模型玩家们何以在又快又好又省之间做到平衡?

这就回到了那个避不开,同时又是成本里占绝对大头的因素——算力。

现在提及大模型的训练和推理,很多人的第一反应或许就是想到了GPU。

诚然GPU在高性能上占据着一定的优势,但它所存在“硬伤”也是比较明显,那便是供应不足、价格昂贵。

何以破局?国产大模型第一梯队玩家百度智能云千帆大模型平台,就给出了自己的一个更具“效价比”的解法:

具体到算力的部署上,百度智能云AI与大模型平台总经理忻舟认为:

一言蔽之,在大模型时代,CPU甚至比以往更加重要了,而且是能让大模型和应用做到“快好省”落地的关键因素之一。

那么具体“上岗”效果又是如何,我们继续往下看。

国产头部大模型玩家,pick了CPU

国内AIGC应用爆发,这其中,百度智能云千帆大模型平台功不可没。

作为企业使用大模型的”一站式”服务平台,千帆大模型平台自去年3月发布以来已有超12万客户使用,累计调优模型2万个,孵化应用4.2万个。

这些应用覆盖教育、金融、办公、医疗等众多场景,为行业数字化转型提供了有力支撑。

在教育领域,千帆大模型平台赋能了试题生成、在线批改、题目解析等应用,大大提升了教学和备考效率。

例如用户可以提供参考材料,设定题型和难度,平台就能自动生成高质量的试题。而交互式的题目解析,则可以针对每位学生的薄弱环节,提供个性化的学习指导。

在办公场景,千帆大模型平台与业内头部企业合作,共同打造了智能写作助手等创新应用,能够根据用户输入的关键词,快速生成招聘文案、营销方案、数据报告等专业文档。

还可以专注于各类写作场景,可以智能生成论文大纲、项目汇报、品牌宣传稿等,大大提升了行政和营销人员的工作效率。

医疗健康是千帆大模型平台的另一大应用赛道。基于医疗知识库训练的模型,可以自动生成体检报告解读,用通俗易懂的语言向用户解释各项指标,并给出个性化的健康指导。

这让普通大众也能更好地了解自己的身体状况,实现”健康自主管理”。

可以看到,千帆大模型平台在多个领域实现了AI模型的”最后一公里”落地。

那么千帆大模型平台是怎么支撑如此多AI应用的呢?

答案是:让CPU成为客户的选择之一,让“效价比”的红利普惠千行百业。

之所以如此,百度智能云所给出的解释是:

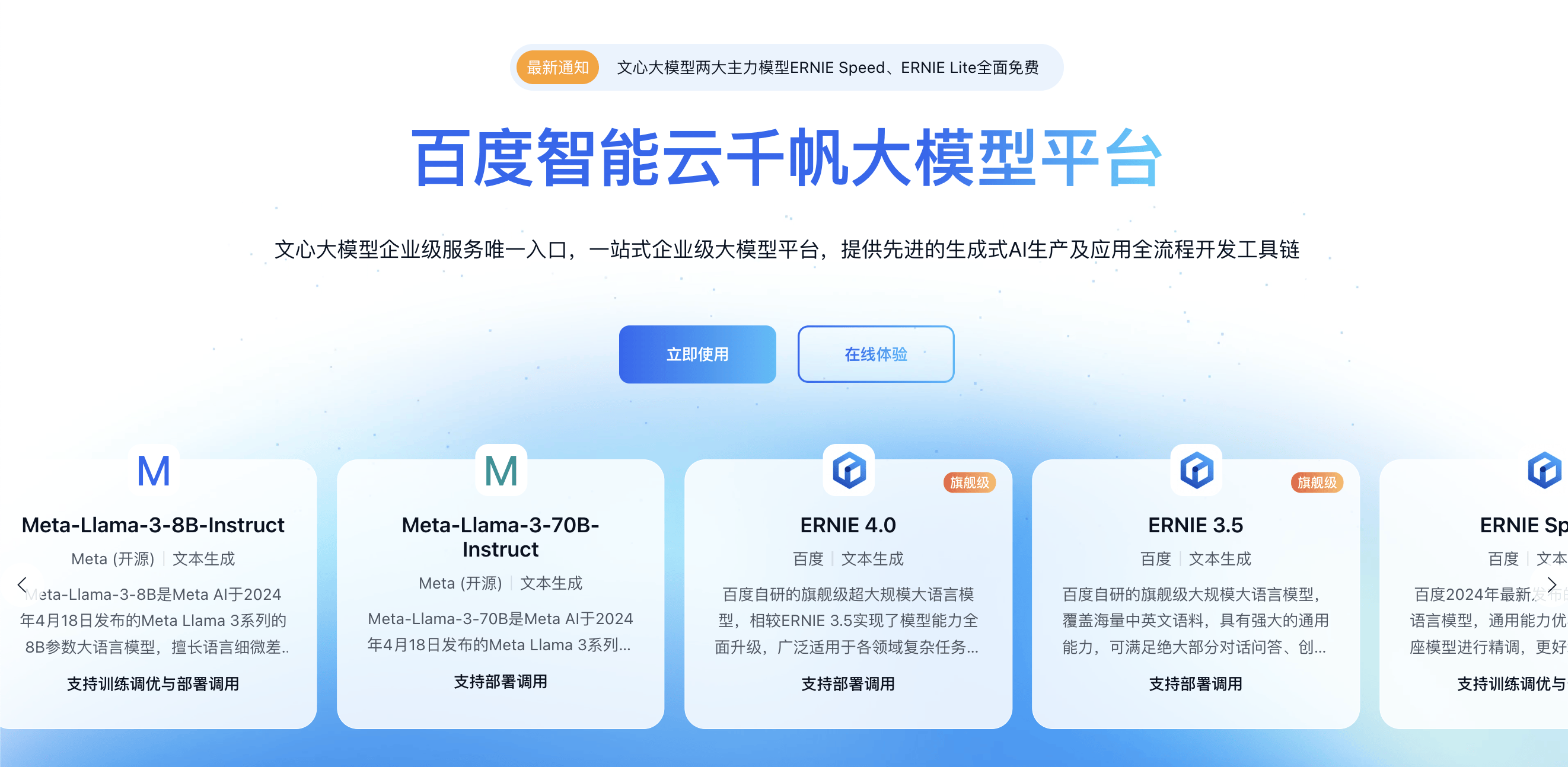

至于效果,以Llama-2-7B为例,在第四代英特尔® 至强® 可扩展处理器上输出 Token 吞吐可达 100 TPS 以上,相比第三代提升了60%。

△Llama-2-7b模型输出Token吞吐

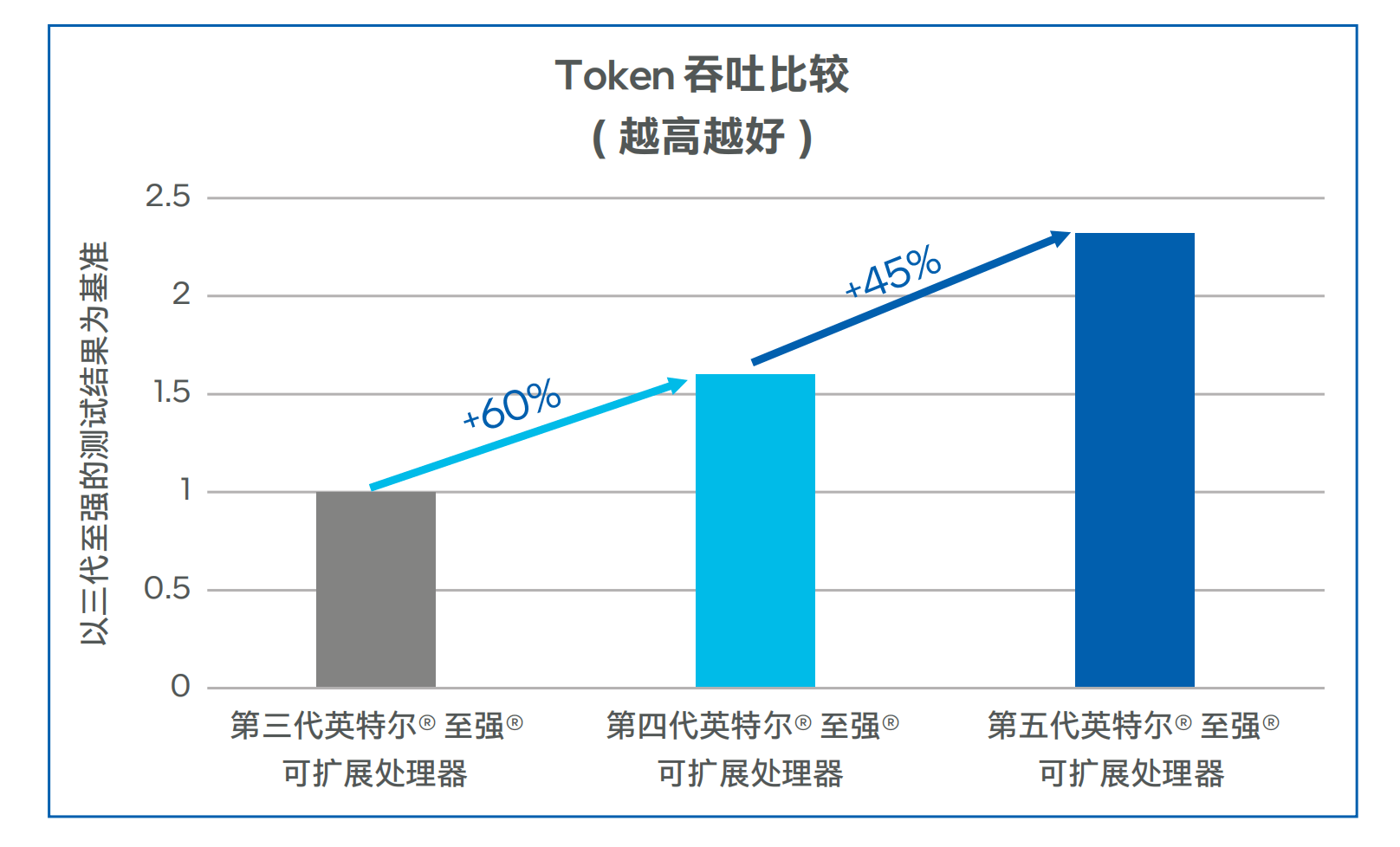

在低延迟的场景,同等并发下,第四代至强® 可扩展处理器的首Token时延比第三代至强® 可降低50%以上。

在将处理器升级为第五代至强® 可扩展处理器之后,较上代的吞吐可提升45%左右,首 Token 时延下降50%左右。

△Llama-2-7b模型首Token时延

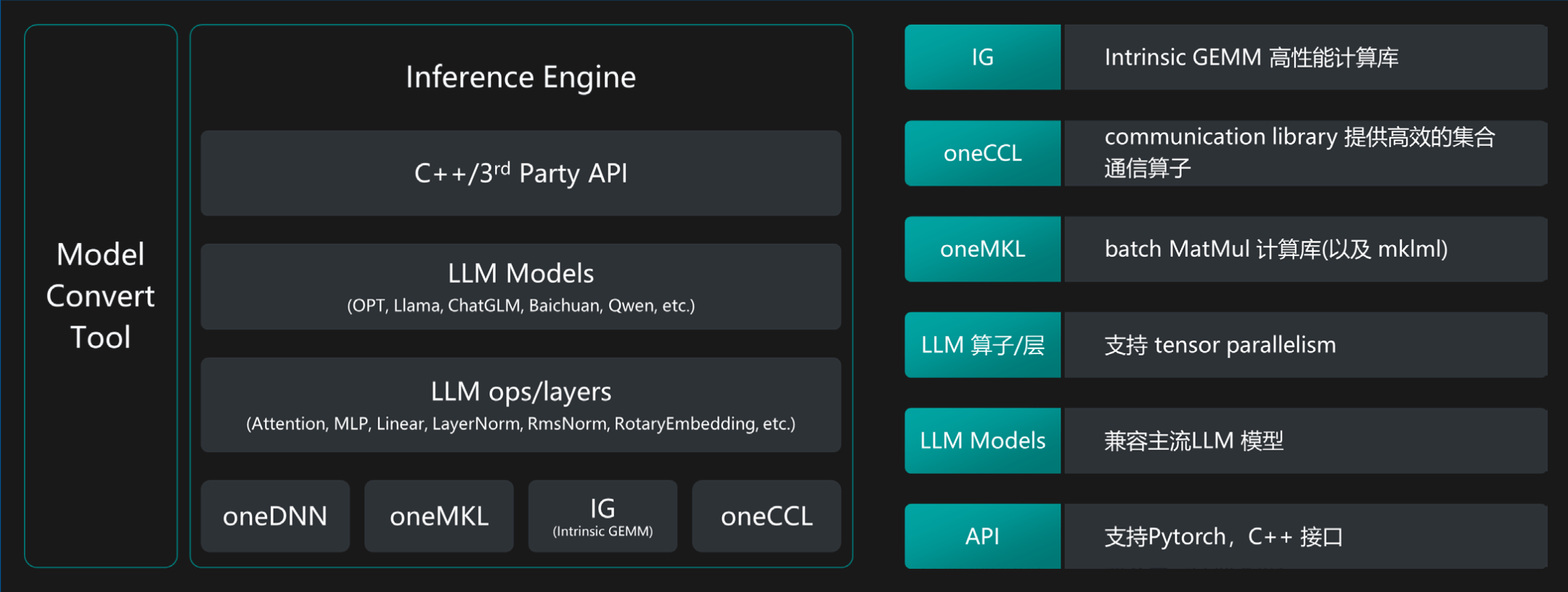

并且千帆大模型平台团队根据实践经验还表示:

不仅如此,利用充足的CPU资源,降低对于AI加速卡的需求,从而降低 LLM 推理服务的总体拥有成本 (TCO),特别是在离线的 LLM 推理场景中表现出色。

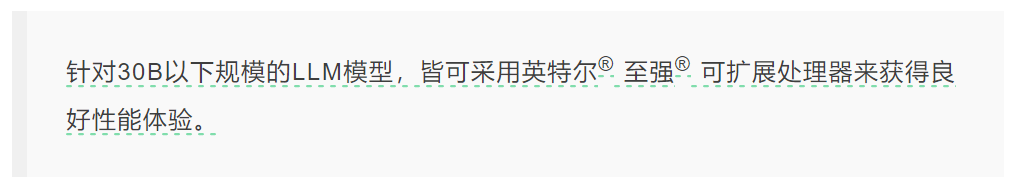

而且在千帆大模型平台上,可不止是有自家的ERNIE,还有很多主流的大模型都集成于此。

这也在一定程度上从侧面印证了第五代英特尔® 至强® 可扩展处理器在性能上的过关。

英特尔第五代至强,如何让性能和效率变得Pro Max?

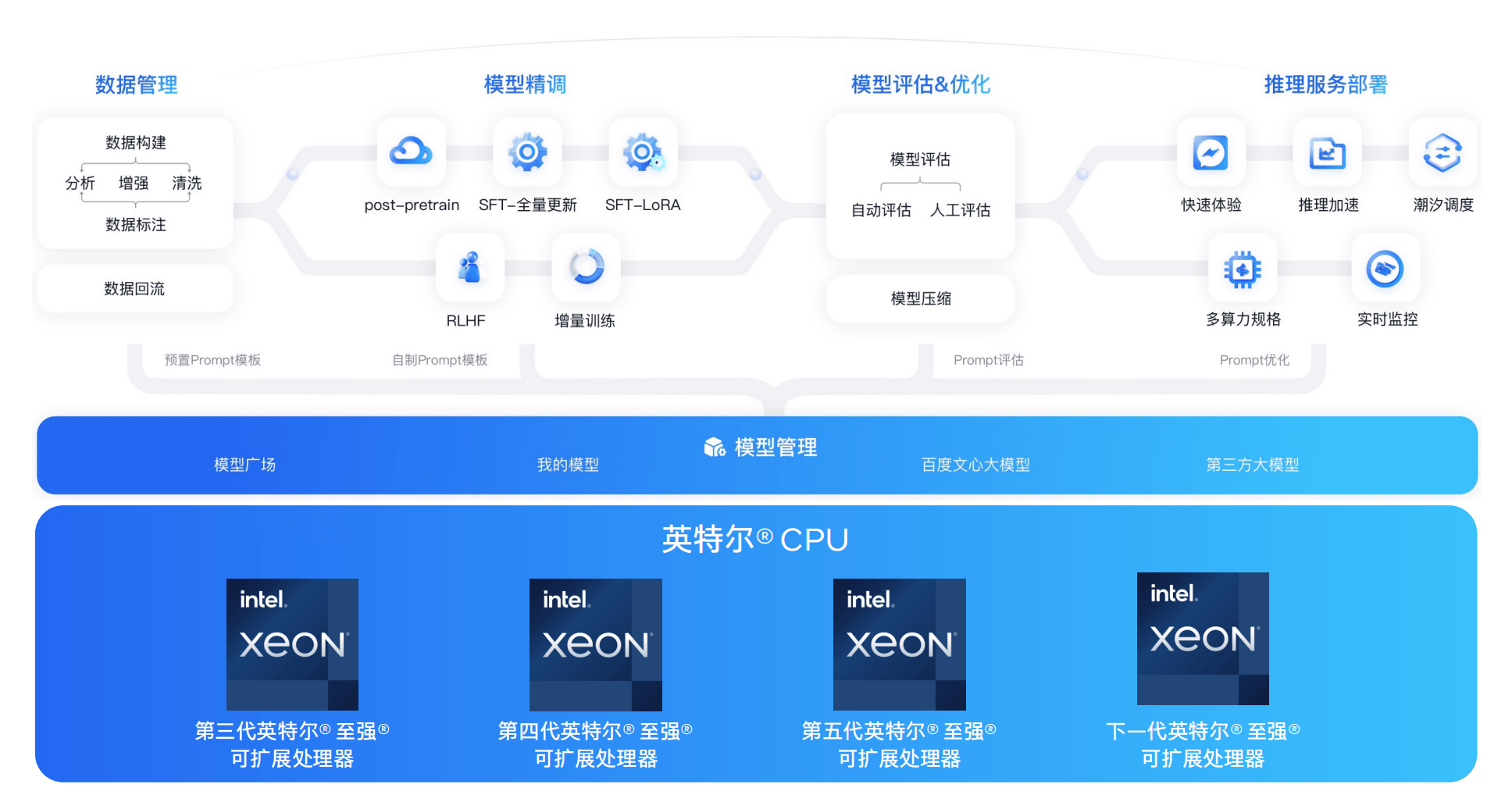

百度智能云千帆大模型平台,不止需要大模型推理一种工作负载,它其实是一个覆盖大模型全生命周期的平台。

具体来说,千帆大模型平台提供数据标注,模型训练与评估,推理服务与应用集成的全面功能服务,以及快速应用编排与插件集成,助力大模型多场景落地应用。这样一来,比起专为大模型推理部署专用加速器,充分利用平台已广泛部署的CPU资源,就是更划算的选择了。

对于千帆大模型平台上存在的大量离线大模型应用需求来说,如生成文章总结、摘要、评估多个模型的效果等,这类需求对推理的时延要求其实不高,但内存容易成为瓶颈。

采用CPU来做,扩展内存更方便,还可以利用起平台闲时的算力资源,进一步提高资源利用率,起到降低总拥有成本的作用。

在这个大背景下,第五代英特尔® 至强® 可扩展处理器中的性能密集型通用计算应用负载(类似P Core性能核)的设计就尤为关键了。

与E Core(能效核)相比,P Core采用了追求性能最大化的设计,能承载非常重的负载,同时还兼顾了AI推理加速。

采用此设计的第五代至强® 可扩展处理器,在兼顾AI推理加速这一点上可不是说说而已,而是软硬件协同优化,各方面都考虑到位了。

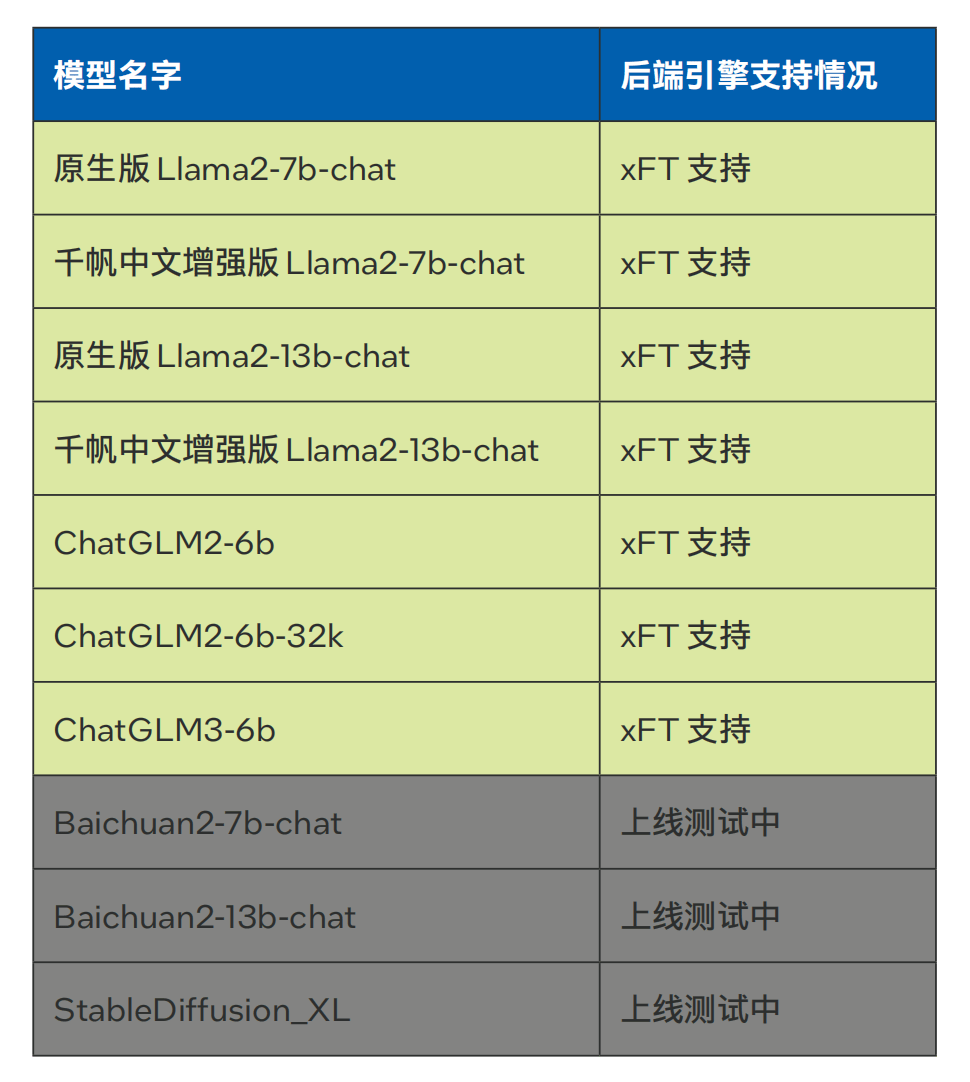

硬件方面,英特尔® AMX(高级矩阵扩展)技术,正是为大模型推理重深度学习中大量的矩阵乘法运算专门优化的,可以理解成”CPU 里的 Tensor Core”。

有了英特尔® AMX,处理器每个时钟周期可完成高达2048个INT8运算,比上一代AVX512_VNNI指令提升8倍之多。

更重要的是,英特尔® AMX加速器是内置在CPU核心里的,让矩阵存储和运算更近,这一特性应用在大模型推理上,能够降低处理下一个Token的时延,让终端用户的体验更好。

△英特尔® AMX 可以更高效的实现 AI 加速

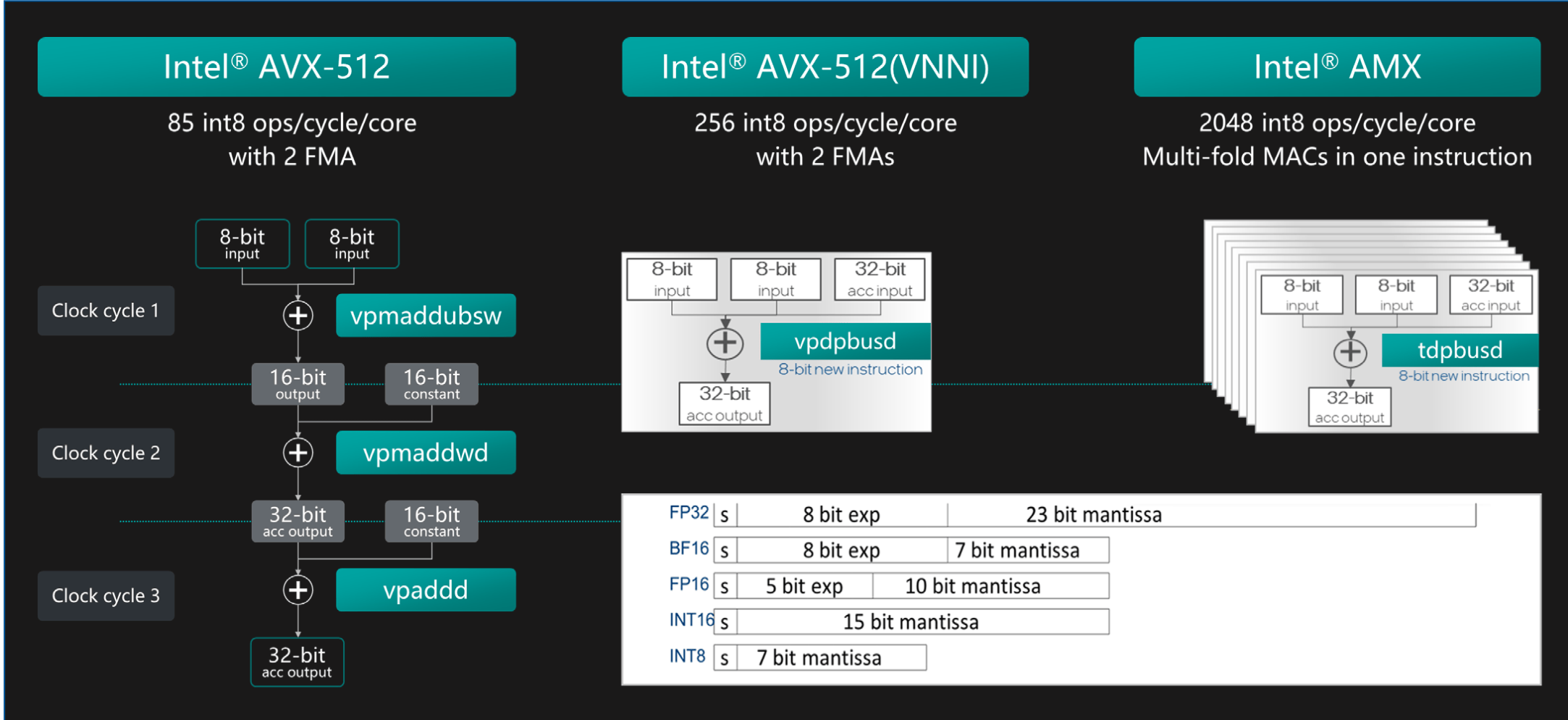

软件方面,百度智能云千帆大模型平台已经引入了针对英特尔® 至强® 可扩展平台深度优化的大模型推理软件解决方案xFasterTransformer (xFT),并将其作为后端推理引擎。主要优化策略如下:

- 充分利用 AMX/AVX512 等指令集,高效实现核心算子如 Flash Attention 等

- 采用低精度量化,降低数据访存量,发挥 INT8/BF16 运算的优势

- 支持超大规模模型的多机多卡并行推理

△英特尔® 至强® 可扩展处理器 LLM 推理软件解决方案

最后还要补充的一点是,要知道选择一种硬件平台,不止关乎于设备本身的采购价格,还会影响到后续的维护成本,甚至人才储备成本。

所以正如百度智能云所言,高性价比的算力基础设施,与先进的大模型算法和平台软件相辅相成,让上层的开发者们能够更加平滑地应用,构建他们的业务,才能最大化云计算平台的商业价值。

大模型时代,CPU大有可为

纵观当下,大模型正从实验室走向产业,从少数人的“玩具”变为大众可用的“工具”。

这意味着,大模型服务不仅要有优秀的性能表现,还要做到价格亲民、部署便捷。一言以蔽之,“快好省”成了大模型商业化的关键一环。

而要实现“快好省”,算力基础设施的选择至关重要。

传统观点认为,专用加速器才是AI的“标配”。但在供应紧张、成本高企的背景下,专用加速器的优势正在减弱。

相比之下,优化良好的高端 CPU 不仅能提供足够应对大模型推理的算力,而且具有更广泛的部署基础和更成熟的软件生态、以及更好的安全保障,开始受到越来越多业界玩家的青睐。

以英特尔® 至强® 系列为代表的x86架构CPU,拥有成熟完善的软件生态和广泛的应用基础。数以百万计的开发者可以利用现有工具和框架,快速构建和优化AI应用,而无需额外学习专门的加速器软件栈,大大降低了开发难度和迁移成本。

同时,企业级用户还可以利用CPU内置的多层次安全技术,实现从硬件到软件的全栈保护,充分保障数据安全和隐私。这些优势,是当前专用加速器难以比拟的。

由此可见,充分利用CPU进行推理,让AI从“烧钱游戏”变为“普惠科技”,正是AIGC产业应对算力门槛,推动规模化应用落地的关键一招。未来,随着技术创新和生态完善,这一模式还将为更多企业创造价值,为产业发展注入新的动力。

除了直接加速推理任务外,CPU在完整的端到端AI管线中还能高效完成数据预处理、特征工程等AI全流程中的关键步骤。而支持机器学习和图分析的各类数据库,也主要是构建在CPU之上的。以至强® 可扩展处理器为例,除了英特尔® AMX之外,还有诸如英特尔® 数据保护与压缩加速技术(英特尔® QAT)、英特尔® 存内分析加速器(英特尔® IAA)等一系列数据分析引擎内置于处理器中,通过卸载特定任务使CPU得到更好的利用,从而提升工作负载整体性能,实现数据分析加速。

由此可见,构建“快、准、稳”的 AI 应用,既要靠专用加速器强大的算力,也离不开CPU超强的通用计算能力去释放整个系统的潜力。

为了科普CPU在AI推理新时代的玩法,量子位开设了《最“in”AI》专栏,将从技术科普、行业案例、实战优化等多个角度全面解读。

我们希望通过这个专栏,让更多的人了解CPU在AI推理加速,甚至是整个AI平台或全流程加速上的实践成果,重点就是如何更好地利用CPU来提升大模型应用的性能和效率。

-

cpu

+关注

关注

68文章

10870浏览量

211874 -

AI

+关注

关注

87文章

30946浏览量

269186 -

大模型

+关注

关注

2文章

2465浏览量

2750

发布评论请先 登录

相关推荐

商汤科技位列GenAI IaaS领域第一梯队

东风日产与Momenta合作推出高阶智驾方案

2024安防行业前三季度报出炉:谁在争先,谁在叹气?

RISC-V拥有巨大市场潜力的原因

云知声山海大模型位居全球大模型第一梯队

GenAI IaaS增速惊人,商汤科技跻身第一梯队

曝华为Mate 70将迎重大突破,性能重回第一梯队!

第三代“香山”RISC-V 开源高性能处理器核性能进入全球第一梯队

发布行业首款AI大模型三摄智能锁,全系列产品AI加持,萤石2024春季新品发布会很AI

无意发展至10nm以下,第二梯队晶圆代工厂的成熟工艺现状

工业无人机产业发展现状

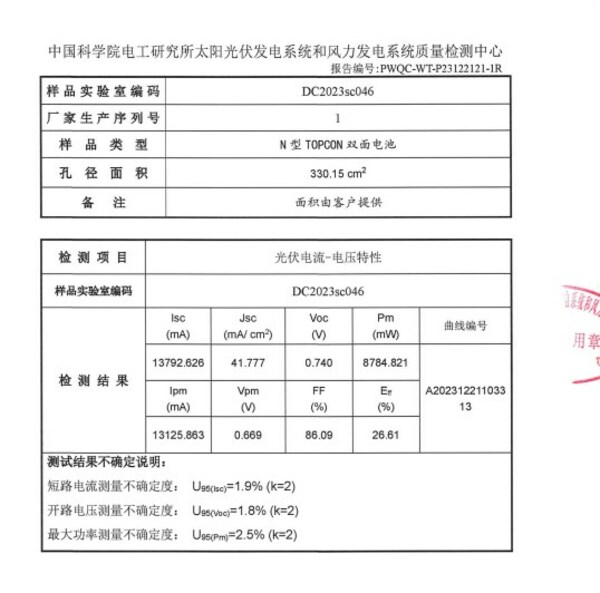

英发睿能N型TOPCon电池测试效率达26.61%,行业第一梯队

国产大模型第一梯队玩家,为什么pick了CPU?

国产大模型第一梯队玩家,为什么pick了CPU?

评论