以下是使用PyCharm进行Python爬虫的步骤:

- 安装PyCharm和Python

首先,您需要安装PyCharm和Python。PyCharm是一个流行的Python集成开发环境(IDE),它提供了许多有用的功能,如代码自动完成、调试和版本控制等。您可以从JetBrains的官方网站下载PyCharm,并根据您的需求选择免费社区版或付费专业版。

- 创建一个新的Python项目

打开PyCharm,然后点击“Create New Project”创建一个新的Python项目。选择一个合适的项目名称和位置,然后选择Python解释器。如果您还没有安装Python,PyCharm会自动提示您安装。

- 安装所需的库

在开始编写爬虫代码之前,您需要安装一些常用的Python库,如requests、BeautifulSoup、Scrapy等。您可以使用PyCharm的内置终端或命令行工具pip来安装这些库。例如,要安装requests库,您可以在终端中输入以下命令:

pip install requests

- 编写爬虫代码

在PyCharm中,您可以创建一个新的Python文件,然后开始编写爬虫代码。以下是一些基本的步骤:

a. 导入所需的库

在代码的开头,导入您需要使用的库。例如:

import requests

from bs4 import BeautifulSoup

b. 发送HTTP请求

使用requests库发送HTTP请求以获取网页内容。例如:

url = 'https://www.example.com'

response = requests.get(url)

c. 解析网页内容

使用BeautifulSoup或其他解析库解析网页内容。例如:

soup = BeautifulSoup(response.text, 'html.parser')

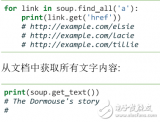

d. 提取所需数据

根据您需要的数据类型,使用BeautifulSoup或其他解析库提取数据。例如,如果您需要提取所有的链接,可以使用以下代码:

links = soup.find_all('a')

for link in links:

print(link.get('href'))

e. 存储数据

将提取的数据存储到文件或数据库中。例如,您可以将数据存储到CSV文件中:

import csv

with open('data.csv', 'w', newline='', encoding='utf-8') as file:

writer = csv.writer(file)

writer.writerow(['URL', 'Title'])

for link in links:

writer.writerow([link.get('href'), link.text])

- 处理异常和错误

在编写爬虫代码时,您可能会遇到各种异常和错误,如网络错误、解析错误等。为了使您的爬虫更加健壮,您需要处理这些异常和错误。例如,您可以使用try-except语句来捕获和处理异常:

try:

response = requests.get(url)

response.raise_for_status() # 如果响应状态不是200,将引发异常

except requests.RequestException as e:

print(f"Error: {e}")

- 遵守robots.txt协议

在编写爬虫时,您需要遵守目标网站的robots.txt协议,以避免对网站造成不必要的负担。您可以使用robotparser库来解析robots.txt文件:

from urllib.robotparser import RobotFileParser

rp = RobotFileParser()

rp.set_url('https://www.example.com/robots.txt')

rp.read()

if rp.can_fetch('*', url):

response = requests.get(url)

else:

print("Access denied by robots.txt")

- 使用代理和用户代理

为了防止您的IP地址被封禁,您可以使用代理和用户代理来模拟不同的用户。例如,您可以使用以下代码设置用户代理:

headers = {

'User-Agent': 'Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/58.0.3029.110 Safari/537.36'

}

response = requests.get(url, headers=headers)

- 处理JavaScript渲染的网页

有些网页使用JavaScript动态加载内容,这可能导致使用requests和BeautifulSoup无法获取完整的网页内容。在这种情况下,您可以使用Selenium库来模拟浏览器行为:

from selenium import webdriver

driver = webdriver.Chrome()

driver.get(url)

soup = BeautifulSoup(driver.page_source, 'html.parser')

driver.quit()

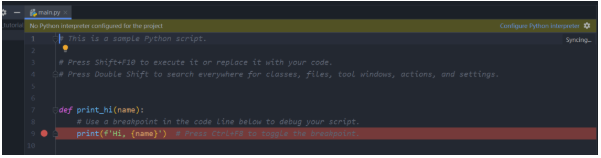

- 测试和调试

在编写爬虫代码时,您需要不断测试和调试以确保代码的正确性。PyCharm提供了许多调试功能,如设置断点、单步执行和查看变量值等。

-

终端

+关注

关注

1文章

1170浏览量

30252 -

代码

+关注

关注

30文章

4858浏览量

69624 -

python

+关注

关注

56文章

4814浏览量

85367 -

爬虫

+关注

关注

0文章

82浏览量

7156

发布评论请先 登录

相关推荐

用pycharm进行python爬虫的步骤

用pycharm进行python爬虫的步骤

评论