BP神经网络(Backpropagation Neural Network)是一种多层前馈神经网络,通过反向传播算法进行训练。它在许多领域,如模式识别、数据挖掘、预测分析等,都有广泛的应用。本文将介绍如何使用Python实现BP神经网络进行数据预测。

1. 神经网络基础

1.1 神经元模型

神经元是神经网络的基本单元,它接收输入信号,通过激活函数转换,输出信号。一个神经元的数学模型如下:

[ y = f(sum_{i=1}^{n} w_i x_i + b) ]

其中,( x_i ) 是输入信号,( w_i ) 是权重,( b ) 是偏置,( f ) 是激活函数。

1.2 激活函数

激活函数用于引入非线性,使得神经网络能够学习和模拟复杂的函数映射。常见的激活函数包括:

- Sigmoid函数:( f(x) = frac{1}{1 + e^{-x}} )

- Tanh函数:( f(x) = tanh(x) )

- ReLU函数:( f(x) = max(0, x) )

1.3 损失函数

损失函数用于衡量模型预测值与实际值之间的差异。常见的损失函数包括:

- 均方误差(MSE):( L = frac{1}{n} sum_{i=1}^{n} (y_i - hat{y}_i)^2 )

- 交叉熵损失:常用于分类问题。

2. BP神经网络结构

BP神经网络由输入层、隐藏层和输出层组成。数据从输入层进入,通过隐藏层的非线性变换,最终在输出层得到预测结果。

2.1 输入层

输入层的神经元数量与问题的特征维度相同。

2.2 隐藏层

隐藏层可以有多个,每个隐藏层可以包含不同数量的神经元。隐藏层的数量和神经元数量需要根据具体问题进行调整。

2.3 输出层

输出层的神经元数量取决于问题的输出维度。对于回归问题,输出层通常只有一个神经元;对于分类问题,输出层的神经元数量等于类别数。

3. 反向传播算法

反向传播算法是BP神经网络的核心,用于通过梯度下降法最小化损失函数。

3.1 前向传播

数据从输入层逐层传递到输出层,每层的输出作为下一层的输入。

3.2 计算损失

使用损失函数计算模型预测值与实际值之间的差异。

3.3 反向传播

从输出层开始,逐层计算梯度,更新权重和偏置。

4. Python实现BP神经网络

4.1 导入库

import numpy as np

4.2 初始化网络参数

def initialize_parameters(layers):

params = {}

for i in range(1, len(layers)):

params['W' + str(i)] = np.random.randn(layers[i], layers[i-1]) * 0.01

params['b' + str(i)] = np.zeros((layers[i], 1))

return params

4.3 激活函数及其导数

def sigmoid(x):

return 1 / (1 + np.exp(-x))

def sigmoid_derivative(x):

return x * (1 - x)

4.4 前向传播

def forward_propagation(X, parameters):

caches = {}

A = X

for i in range(1, len(parameters) // 2 + 1):

W = parameters['W' + str(i)]

b = parameters['b' + str(i)]

Z = np.dot(W, A) + b

A = sigmoid(Z)

caches['A' + str(i)] = A

caches['Z' + str(i)] = Z

return A, caches

4.5 计算损失

def compute_cost(A3, Y):

m = Y.shape[1]

cost = (1 / m) * np.sum((A3 - Y) ** 2)

return cost

4.6 反向传播

def backward_propagation(parameters, caches, X, Y):

grads = {}

m = X.shape[1]

A3 = caches['A3']

dA3 = - (np.divide(Y, A3) - np.divide(

-

数据

+关注

关注

8文章

7222浏览量

90143 -

BP神经网络

+关注

关注

2文章

127浏览量

30655 -

python

+关注

关注

56文章

4812浏览量

85283 -

输入信号

+关注

关注

0文章

470浏览量

12672

发布评论请先 登录

相关推荐

用matlab编程进行BP神经网络预测时如何确定最合适的,BP模型

labview BP神经网络的实现

如何设计BP神经网络图像压缩算法?

基于BP神经网络的PID控制

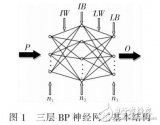

BP神经网络的税收预测

python做bp神经网络预测数据

python做bp神经网络预测数据

评论