在PyTorch中实现LeNet-5网络是一个涉及深度学习基础知识、PyTorch框架使用以及网络架构设计的综合性任务。LeNet-5是卷积神经网络(CNN)的早期代表之一,由Yann LeCun等人提出,主要用于手写数字识别任务(如MNIST数据集)。下面,我将详细阐述如何在PyTorch中从头开始实现LeNet-5网络,包括网络架构设计、参数初始化、前向传播、损失函数选择、优化器配置以及训练流程等方面。

一、引言

LeNet-5网络以其简洁而有效的结构,在深度学习发展史上占有重要地位。它主要由卷积层、池化层、全连接层等构成,通过堆叠这些层来提取图像中的特征,并最终进行分类。在PyTorch中实现LeNet-5,不仅可以帮助我们理解CNN的基本原理,还能为更复杂网络的设计和实现打下基础。

二、PyTorch环境准备

在开始编写代码之前,请确保已安装PyTorch及其依赖库。可以通过PyTorch官网提供的安装指令进行安装。此外,还需要安装NumPy、Matplotlib等库,用于数据处理和结果可视化。

三、LeNet-5网络架构设计

LeNet-5网络结构通常包括两个卷积层、两个池化层、两个全连接层以及一个输出层。下面是在PyTorch中定义LeNet-5结构的代码示例:

import torch

import torch.nn as nn

import torch.nn.functional as F

class LeNet5(nn.Module):

def __init__(self, num_classes=10):

super(LeNet5, self).__init__()

self.conv1 = nn.Conv2d(1, 6, kernel_size=5, stride=1, padding=2)

self.relu1 = nn.ReLU(inplace=True)

self.pool1 = nn.MaxPool2d(kernel_size=2, stride=2)

self.conv2 = nn.Conv2d(6, 16, kernel_size=5, stride=1)

self.relu2 = nn.ReLU(inplace=True)

self.pool2 = nn.MaxPool2d(kernel_size=2, stride=2)

self.fc1 = nn.Linear(16 * 5 * 5, 120) # 假设输入图像大小为32x32

self.relu3 = nn.ReLU(inplace=True)

self.fc2 = nn.Linear(120, 84)

self.relu4 = nn.ReLU(inplace=True)

self.fc3 = nn.Linear(84, num_classes)

def forward(self, x):

x = self.pool1(self.relu1(self.conv1(x)))

x = self.pool2(self.relu2(self.conv2(x)))

x = x.view(-1, 16 * 5 * 5) # 展平

x = self.relu3(self.fc1(x))

x = self.relu4(self.fc2(x))

x = self.fc3(x)

return x

四、参数初始化

在PyTorch中,模型参数(如权重和偏置)的初始化对模型的性能有很大影响。LeNet-5的权重通常使用随机初始化方法,如正态分布或均匀分布。PyTorch的nn.Module在初始化时会自动调用reset_parameters()方法(如果定义了的话),用于初始化所有可学习的参数。但在上面的LeNet5类中,我们没有重写reset_parameters()方法,因为nn.Conv2d和nn.Linear已经提供了合理的默认初始化策略。

五、前向传播

在forward方法中,我们定义了数据通过网络的前向传播路径。输入数据x首先经过两个卷积层和两个池化层,提取图像特征,然后将特征图展平为一维向量,最后通过两个全连接层进行分类。

六、损失函数与优化器

在训练过程中,我们需要定义损失函数和优化器。对于分类任务,常用的损失函数是交叉熵损失(CrossEntropyLoss)。优化器则用于更新模型的参数,以最小化损失函数。常用的优化器包括SGD、Adam等。

criterion = nn.CrossEntropyLoss()

optimizer = torch.optim.Adam(model.parameters(), lr=0.001)

七、训练流程

训练流程通常包括以下几个步骤:

- 数据加载 :使用PyTorch的`DataLoader来加载和预处理训练集和验证集(或测试集)。

- 模型实例化 :创建LeNet-5模型的实例。

- 训练循环 :在训练集中迭代,对每个批次的数据执行前向传播、计算损失、执行反向传播并更新模型参数。

- 验证/测试 :在每个epoch结束时,使用验证集(或测试集)评估模型的性能,以便监控训练过程中的过拟合情况或评估最终模型的性能。

- 保存模型 :在训练完成后,保存模型以便将来使用。

下面是训练流程的代码示例:

# 假设已有DataLoader实例 train_loader, val_loader

# 实例化模型

model = LeNet5(num_classes=10) # 假设是10分类问题

# 损失函数和优化器

criterion = nn.CrossEntropyLoss()

optimizer = torch.optim.Adam(model.parameters(), lr=0.001)

# 训练模型

num_epochs = 10

for epoch in range(num_epochs):

model.train() # 设置模型为训练模式

total_loss = 0

for images, labels in train_loader:

# 将数据转移到GPU(如果可用)

images, labels = images.to(device), labels.to(device)

# 前向传播

outputs = model(images)

loss = criterion(outputs, labels)

# 反向传播和优化

optimizer.zero_grad() # 清除之前的梯度

loss.backward() # 反向传播计算梯度

optimizer.step() # 更新权重

# 累加损失

total_loss += loss.item()

# 在验证集上评估模型

model.eval() # 设置模型为评估模式

val_loss = 0

correct = 0

with torch.no_grad(): # 评估时不计算梯度

for images, labels in val_loader:

images, labels = images.to(device), labels.to(device)

outputs = model(images)

_, predicted = torch.max(outputs.data, 1)

val_loss += criterion(outputs, labels).item()

correct += (predicted == labels).sum().item()

# 打印训练和验证结果

print(f'Epoch {epoch+1}, Train Loss: {total_loss/len(train_loader)}, Val Loss: {val_loss/len(val_loader)}, Val Accuracy: {correct/len(val_loader.dataset)*100:.2f}%')

# 保存模型

torch.save(model.state_dict(), 'lenet5_model.pth')

八、模型评估与测试

在训练完成后,我们通常会在一个独立的测试集上评估模型的性能,以确保模型在未见过的数据上也能表现良好。评估过程与验证过程类似,但通常不会用于调整模型参数。

九、模型部署

训练好的模型可以部署到各种环境中,如边缘设备、服务器或云端。部署时,需要确保模型与目标平台的兼容性,并进行适当的优化以提高性能。

十、结论

在PyTorch中实现LeNet-5网络是一个理解卷积神经网络基本结构和训练流程的好方法。通过实践,我们可以掌握PyTorch框架的使用方法,了解如何设计网络架构、选择损失函数和优化器、编写训练循环等关键步骤。此外,通过调整网络参数、优化训练过程和使用不同的数据集,我们可以进一步提高模型的性能,并探索深度学习在更多领域的应用。

-

网络

+关注

关注

14文章

7545浏览量

88719 -

深度学习

+关注

关注

73文章

5497浏览量

121094 -

pytorch

+关注

关注

2文章

806浏览量

13191

发布评论请先 登录

相关推荐

FPGA实现LeNet-5卷积神经网络

一文读懂物体分类AI算法:LeNet-5 AlexNet VGG Inception ResNet MobileNet

【NanoPi K1 Plus试用体验】深度学习---实现Lenet

STM32网络的三大件

STM32网络控制器的SMI接口

如何在PyTorch上学习和创建网络模型呢?

IPv6网络中基于域名的通用用户标识系统

R4网络中的关键技术

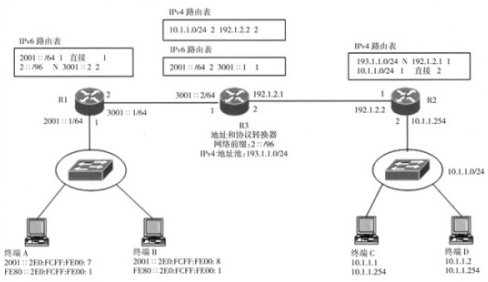

基于网络地址和协议转换实现IPv4网络和IPv6网络互连

如何在RS-485网络中使用MSP430和MSP432 eUSCI和USCI模块

如何在PyTorch中实现LeNet-5网络

如何在PyTorch中实现LeNet-5网络

评论