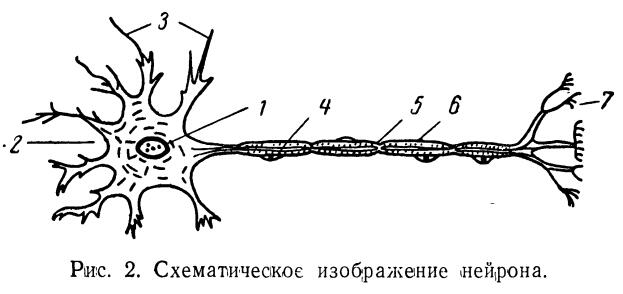

人工神经元模型是人工智能领域中的一个重要概念,它模仿了生物神经元的工作方式,为机器学习和深度学习提供了基础。本文将介绍人工神经元模型的基本构成要素。

- 神经元的基本概念

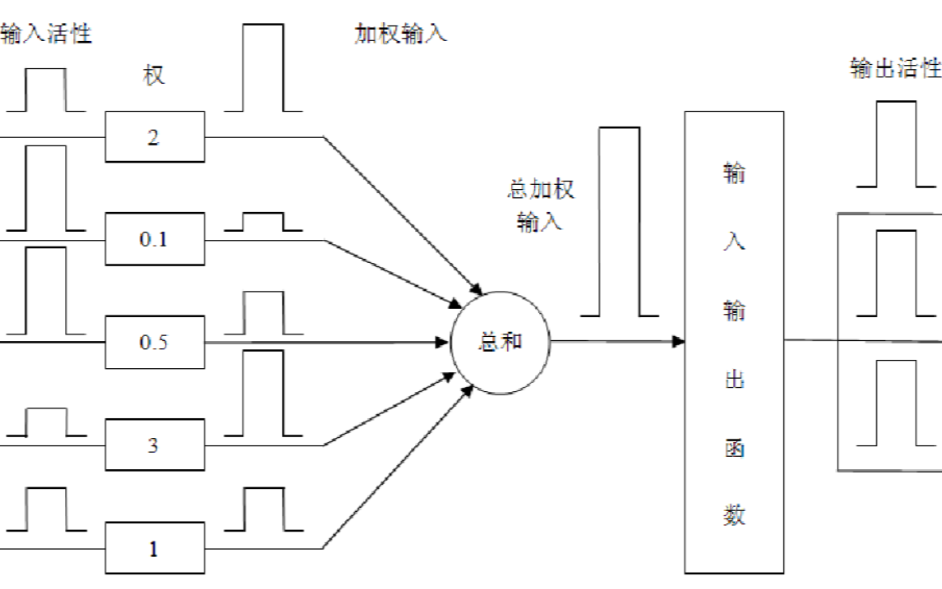

神经元是神经系统的基本单元,它能够接收、处理和传递信息。在人工神经元模型中,神经元的基本结构包括输入、输出和激活函数。

1.1 输入

神经元的输入是一组数值,通常用向量表示。这些数值可以是特征值、像素值等,它们代表了神经元接收到的信息。

1.2 输出

神经元的输出是一个数值,它是输入经过处理后的结果。输出可以是连续值,也可以是离散值,取决于激活函数的类型。

1.3 激活函数

激活函数是神经元的核心部分,它决定了神经元如何处理输入并生成输出。激活函数的选择对神经网络的性能有很大的影响。

- 激活函数

激活函数是神经元中用于引入非线性的关键部分。以下是一些常用的激活函数:

2.1 Sigmoid函数

Sigmoid函数是一种常见的激活函数,它的数学表达式为:

f(x) = 1 / (1 + exp(-x))

Sigmoid函数的输出范围在0到1之间,它可以将输入压缩到这个范围内。Sigmoid函数在二分类问题中非常常用。

2.2 Tanh函数

Tanh函数是Sigmoid函数的变体,它的数学表达式为:

f(x) = (exp(x) - exp(-x)) / (exp(x) + exp(-x))

Tanh函数的输出范围在-1到1之间,它比Sigmoid函数具有更好的数值稳定性。

2.3 ReLU函数

ReLU(Rectified Linear Unit)函数是一种简单的激活函数,它的数学表达式为:

f(x) = max(0, x)

ReLU函数在正数部分是线性的,在负数部分则为0。它在训练深度神经网络时具有很好的性能。

2.4 Leaky ReLU函数

Leaky ReLU函数是ReLU函数的改进版本,它的数学表达式为:

f(x) = max(alpha * x, x)

其中alpha是一个小于1的常数。Leaky ReLU函数在负数部分引入了一个小的斜率,这有助于避免神经元的死亡。

2.5 Softmax函数

Softmax函数常用于多分类问题中,它的数学表达式为:

f(x_i) = exp(x_i) / sum(exp(x_j))

其中x_i是输入向量的第i个元素,x_j是输入向量的其他元素。Softmax函数将输入向量转换为概率分布。

- 权重

权重是神经元中用于调整输入值的参数。权重的大小决定了输入对输出的影响程度。在训练过程中,权重会不断更新,以使神经网络的预测结果更接近真实值。

3.1 权重初始化

权重初始化是神经网络训练的第一步。合适的权重初始化方法可以加速训练过程并提高模型性能。常见的权重初始化方法有:

- 零初始化:将所有权重初始化为0。

- 随机初始化:将权重随机初始化为一个小的正数或负数。

- Xavier初始化:根据输入和输出的维度自动调整权重的初始值。

- He初始化:适用于ReLU激活函数,根据输入的维度自动调整权重的初始值。

3.2 权重更新

权重更新是训练过程中的关键步骤。权重更新的目的是减小预测值和真实值之间的差距。权重更新的方法有:

- 梯度下降法:通过计算损失函数关于权重的梯度,然后更新权重。

- 随机梯度下降法:使用一个训练样本来更新权重,可以加快训练速度。

- 小批量梯度下降法:使用一个小批量的训练样本来更新权重,可以在训练速度和模型性能之间取得平衡。

- 偏置

偏置是神经元中的另一个参数,它用于调整输出的偏移量。偏置可以帮助模型更好地拟合数据。

4.1 偏置初始化

偏置初始化通常使用较小的随机值或0。合适的偏置初始化可以提高模型的收敛速度。

4.2 偏置更新

偏置更新与权重更新类似,通过计算损失函数关于偏置的梯度,然后更新偏置。

- 损失函数

损失函数是衡量模型预测值与真实值之间差距的函数。选择合适的损失函数对于模型的性能至关重要。

5.1 均方误差损失函数

均方误差损失函数是最常用的损失函数之一,它的数学表达式为:

L = (1/n) * sum((y_i - y_hat_i)^2)

其中y_i是真实值,y_hat_i是预测值,n是样本数量。

-

人工智能

+关注

关注

1800文章

48064浏览量

242053 -

函数

+关注

关注

3文章

4352浏览量

63270 -

模型

+关注

关注

1文章

3410浏览量

49465 -

人工神经元

+关注

关注

0文章

11浏览量

6327

发布评论请先 登录

相关推荐

基于非联合型学习机制的学习神经元模型

神经网络与神经网络控制的学习课件免费下载

一种具有高度柔性与可塑性的超香肠覆盖式神经元模型

人工神经元模型的基本构成要素

人工神经元模型的基本构成要素

评论