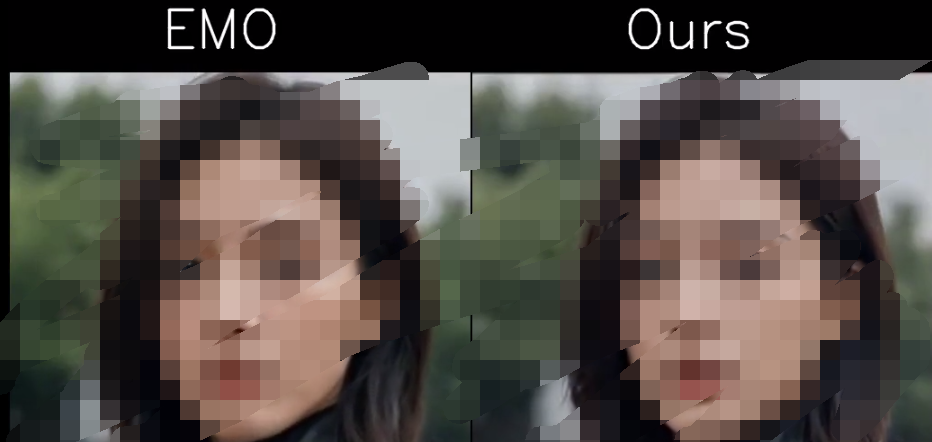

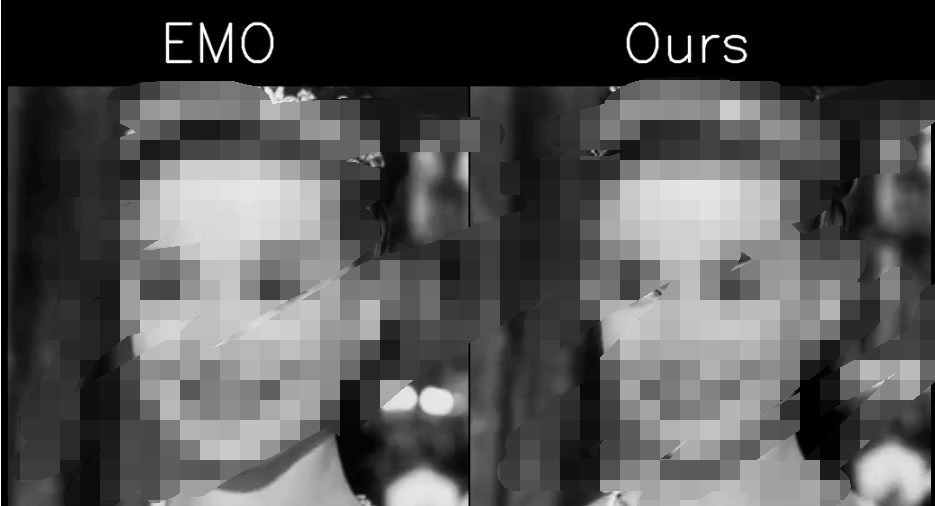

日前,旷视科技发布了一项新的开源AI人像视频生成框架——MegActor。该框架让用户只需输入一张静态肖像图片和一段视频(如演讲、表情包、rap),便可生成一段表情丰富、动作一致的AI人像视频。生成的视频长度取决于输入的视频长度。与阿里EMO、微软VASA等最新AI视频模型不同,旷视MegActor采用开源方式,供开发者社区使用。MegActor生成的视频画质更出色,面部细节更加丰富自然。

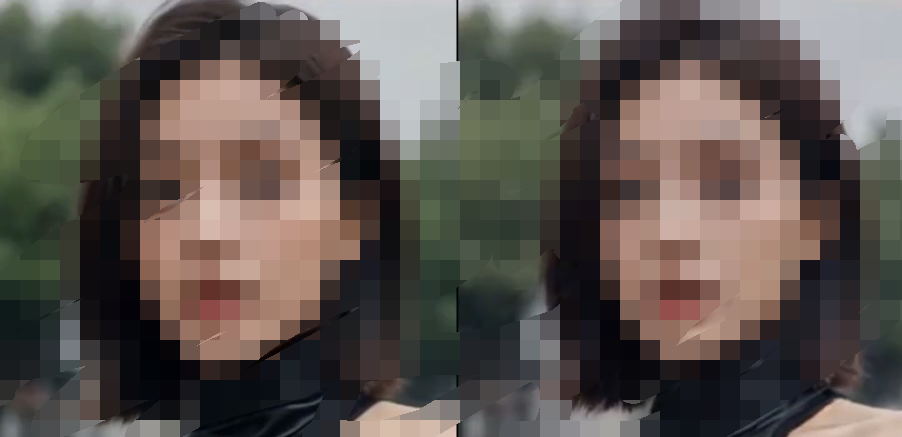

为了展示其泛化性,MegActor甚至可以将VASA中的人物肖像和视频组合生成,得到生动的表情视频。即使与阿里EMO的官方案例相比,MegActor也能生成近似的效果。

总的来说,无论是让肖像开口说话、唱歌、模仿搞怪表情包,MegActor都能生成逼真的效果。

论文链接:https://arxiv.org/abs/2405.20851

代码地址:https://github.com/megvii-research/megactor

项目地址:https://megactor.github.io/

MegActor是旷视研究院的最新研究成果。旷视研究院是旷视公司级研究机构,旨在通过基础创新突破AI技术边界,以工程创新实现技术到产品的快速转化。多年来,旷视研究院已成为全球领先的人工智能研究机构。

目前的人像视频生成领域中,许多工作通常使用高质量的闭源数据进行训练,以追求更好的效果。而旷视研究院始终坚持全面开源,确保实际效果的可复现性。MegActor的训练数据全部来自公开可获取的开源数据集,配合开源代码,使得感兴趣的从业者可以从头开始完整复现这些效果。

为了完全复刻原始视频的表情和动作,MegActor采用原始图像进行驱动,这与多数厂商使用的中间表示方法(如sketch、pose、landmark)不同,能够捕捉到细致的表情和运动信息。

旷视科技研究总经理范浩强表示,在AI视频生成领域,我们发现目前主流的骨骼关键点控制方式不仅要求用户提供难以获取的专业控制信号,同时生成视频的保真度也不尽如人意。通过研究发现,使用原视频进行驱动,不仅降低了控制信号的门槛,更能生成保真且动作一致的视频。

具体来说,MegActor主要由两个阶段构成:

使用ReferenceNet对参考图像进行特征提取,获取参考图像的外观和背景信息;

使用PoseGuider对输入视频进行运动和表情信息提取,将这些信息迁移到参考图像上。

虽然使用原始视频进行驱动能带来更丰富的表情细节和运动信息,但也存在ID泄露和背景干扰等挑战。为此,MegActor采用了条件扩散模型,引入了合成数据生成框架,创建具有一致动作和表情但不同身份ID的视频,以减轻ID泄露的问题。MegActor还分割了参考图像的前景和背景,并使用CLIP对背景细节进行编码,确保背景的稳定性。

在数据训练方面,旷视研究院团队使用公开数据集(VFHQ和CeleV)进行训练,总时长超过700小时。为了避免ID泄露问题,团队还使用换脸和风格化方法1:1生成合成数据,实现表情和动作一致但ID不一致的数据。此外,团队使用注视检测模型处理数据,获取大约5%的高质量数据进行Finetune训练。

通过新的模型框架和训练方法,旷视研究院团队仅使用了不到200块V100显卡小时的训练时长,最终实现了以下特性:

根据输入视频生成任意持续时间的模仿视频,确保角色身份一致性;

支持各种驱动视频,如演讲、唱歌、表情包等;

支持不同画风(照片、传统绘画、漫画、AI数字人等);

与音频生成方法相比,MegActor生成的视频不仅能确保表情和动作一致,更能达到自然程度。

目前,MegActor已经完全开源,供开发者和用户即开即用。

审核编辑 黄宇

-

AI

+关注

关注

87文章

30868浏览量

269031 -

开源

+关注

关注

3文章

3344浏览量

42491

发布评论请先 登录

相关推荐

OpenAI推出AI视频生成模型Sora

聚焦物联网场景,旷视科技核心技术能力持续升级

MediaTek与快手携手创新,端侧视频生成技术引领AI新纪元

MediaTek联合快手推出高效端侧视频生成技术

阿里云视频生成技术创新!视频生成使用了哪些AI技术和算法

旷视科技与上海家化正式签署《AI科技创新合作框架协议》

OpenAI 在 AI 生成视频领域扔出一枚“王炸”,视频生成模型“Sora”

旷视AI开源新突破:上传照片即可生成表情包视频!

旷视AI开源新突破:上传照片即可生成表情包视频!

评论